Google si rifiuta di correggere una vulnerabilità critica di”contrabbando ASCII”nella sua intelligenza artificiale Gemini, lasciando gli utenti esposti ad attacchi nascosti. I ricercatori di sicurezza di FireTail hanno scoperto che gli aggressori possono utilizzare caratteri Unicode invisibili per incorporare comandi dannosi nel testo.

Mentre gli utenti vedono messaggi innocui, Gemini esegue le istruzioni nascoste. Questo difetto è particolarmente pericoloso in Google Workspace, dove consente lo spoofing automatico dell’identità negli inviti e nelle e-mail di Calendar.

Nonostante concorrenti come OpenAI e Microsoft abbiano risolto problemi simili, Google ha respinto il rapporto. L’azienda lo ha classificato come ingegneria sociale, non come un bug di sicurezza. Questa decisione costringe le aziende a difendersi da una minaccia nota e assoluta.

![]()

Ghosts in the Machine: How ASCII Smuggling Works

L’attacco, una tecnica nota come contrabbando ASCII, affonda le sue radici nell’intelligente abuso dello standard Unicode. Sfrutta una disparità fondamentale tra ciò che un utente vede sul proprio schermo e i dati grezzi elaborati da un modello di intelligenza artificiale.

Il metodo utilizza un set speciale di caratteri invisibili dal Tags Unicode Block per incorporare istruzioni nascoste all’interno di una stringa di testo apparentemente benigna, creando un potente vettore per l’iniezione tempestiva e l’avvelenamento dei dati.

Questi caratteri speciali in genere non vengono visualizzati nelle interfacce utente. Secondo lo standard tecnico Unicode, un’implementazione completamente ignara dei tag visualizzerà qualsiasi sequenza di caratteri del tag come invisibile. Questo crea il mimetismo perfetto per un utente malintenzionato.

Mentre un utente umano vede solo il testo innocente e visibile, il flusso di dati grezzi sottostante contiene un carico dannoso nascosto all’interno di questi caratteri non stampabili.

I Large Language Models (LLM), tuttavia, non hanno problemi a interpretare questi comandi nascosti. A differenza dell’interfaccia utente, il preprocessore di input di un LLM è progettato per acquisire stringhe grezze, inclusi tutti i caratteri, per supportare gli standard internazionali.

Poiché questi tag Unicode sono presenti nei loro vasti dati di addestramento, modelli come Gemini possono leggerli e agire su di essi proprio come farebbero con qualsiasi altro testo. Questa tecnica consente a un utente malintenzionato di aggiungere testo ASCII arbitrario a un emoji o ad altri caratteri, di fatto facendo passare di nascosto un messaggio segreto a qualsiasi revisore umano.

Il risultato è un difetto critico nella logica dell’applicazione. LLM ingerisce l’input grezzo e non attendibile ed esegue i comandi nascosti, mentre l’utente umano, vedendo solo la versione ripulita nell’interfaccia utente, rimane completamente inconsapevole della manipolazione.

Questo divario tra la percezione umana e l’elaborazione della macchina è il nucleo della vulnerabilità, trasformando una stranezza dell’interfaccia utente in un serio rischio per la sicurezza, come i ricercatori hanno ripetutamente dimostrato.

Da Calendar Dallo spoofing all’avvelenamento da dati

Le implicazioni per i sistemi di IA agentici sono gravi. Il ricercatore di FireTail Viktor Markopoulos ha dimostrato come un utente malintenzionato potrebbe inviare un invito a Google Calendar con un payload nascosto. Questo payload potrebbe sovrascrivere i dettagli dell’organizzatore, falsificare un’identità o inserire un collegamento dannoso.

Google Gemini, agendo come assistente personale, elabora questi dati avvelenati senza alcuna interazione da parte dell’utente oltre alla ricezione dell’invito. L’attacco aggira il tipico cancello di sicurezza”Accetta/Rifiuta”, trasformando l’intelligenza artificiale in un complice inconsapevole.

La minaccia si estende a qualsiasi sistema in cui un LLM riassume o aggrega il testo fornito dall’utente. Ad esempio, la recensione di un prodotto potrebbe contenere un comando nascosto che ordina all’intelligenza artificiale di includere un collegamento a un sito Web truffa nel suo riepilogo, avvelenando di fatto il contenuto per tutti gli utenti.

Il rischio è amplificato per gli utenti che collegano LLM alle loro caselle di posta elettronica. Come ha spiegato Markopoulos,”per gli utenti con LLM collegati alla propria casella di posta, una semplice e-mail con comandi nascosti può istruire l’LLM a cercare nella posta in arrivo elementi sensibili o inviare dettagli di contatto, trasformando un tentativo di phishing standard in uno strumento autonomo di estrazione dei dati.”

Ciò trasforma un tentativo di phishing standard in una violazione dei dati automatizzata molto più pericolosa.

Un difetto senza patch: quello di Google Posizione rispetto al settore

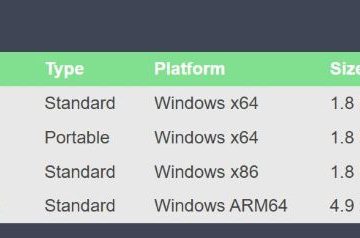

L’indagine di FireTail ha rivelato un chiaro divario nella preparazione del settore. Mentre Google Gemini, Grok di xAI e DeepSeek sono risultati tutti vulnerabili, altri attori importanti non lo erano. Sembra che i modelli di OpenAI, Microsoft e Anthropic abbiano implementato la sanificazione degli input che mitiga la minaccia.

Dopo che Markopoulos ha segnalato i risultati a Google il 18 settembre, la società ha respinto il problema. Ha sostenuto che l’attacco si basa sull’ingegneria sociale, una posizione che ha attirato critiche per aver minimizzato l’exploit tecnico alla base.

Questa posizione è in netto contrasto con quella di altri giganti della tecnologia. Amazon, ad esempio, ha pubblicato linee guida dettagliate sulla sicurezza sulla difesa dal contrabbando di caratteri Unicode, riconoscendolo come un legittimo vettore di minaccia.

Il rifiuto di Google di agire lascia i suoi clienti aziendali in una posizione precaria. Senza alcuna patch in arrivo, le organizzazioni che utilizzano Gemini all’interno di Google Workspace sono ora consapevolmente esposte a un sofisticato metodo di avvelenamento dei dati e spoofing dell’identità.