Openai ha lanciato una suite di controlli parentali per Chatgpt, offrendo a Guardians nuovi strumenti per gestire l’esperienza del loro adolescente con l’IA. L’implementazione globale di lunedì per gli utenti Web è una risposta diretta al crescente pressione legale e normativa sull’impatto della piattaforma sulla salute mentale dei giovani.

Le nuove funzionalità arrivano dopo che le cause hanno affermato che il chatbot ha avuto un ruolo nei suicidi per adolescenti e mentre la FTC lancia una sondaggio importante nella sicurezza dei compagni di AI. Il sistema consente ai genitori di collegare gli account con adolescenti, filtrare il contenuto sensibile, impostare limiti di utilizzo e ricevere avvisi su potenziali autolesionismo.

Questo segna un critico, se ultimo, un passo nella resa dei reti del settore con la sicurezza dell’IA. I controlli sono ora disponibili per gli utenti Web, con Accesso al cellulare previsto per il mobile altezza=”1281″src=”Dati: immagine/svg+xml; nitro-empty-id=mty0mzoxmtq1-1; base64, phn2zyb2awv3qm94psiwidagmti4mcaxmjgx IIB3AWR0AD0IMTI4MCIGAGVPZ2H0PSIXMMJGXIIB4BWXUCZ0IAHR0CDOVL3D3DE53MY5VCMCVMJAWMC9ZDMCIPJWVC3ZNPG==”>

sotto il cofano: come funzionano i nuovi controlli parentali di CHATGPT

The nuovo sistema è costruito su un modello reciproco. Un genitore o un adolescente deve avviare un invito a collegare i loro conti e l’altra parte deve accettare. Una volta connessi, i genitori ottengono l’accesso a un pannello di controllo dedicato all’interno delle proprie impostazioni di CHATGPT.

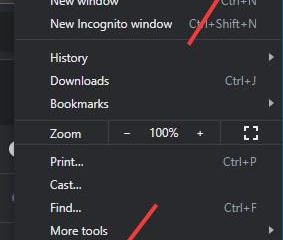

Da questa dashboard, i Guardiani possono implementare diverse restrizioni. Questi includono l’impostazione di”ore tranquille”per bloccare l’accesso, disabilitare la modalità vocale, disattivare la funzione di memoria del chatbot per limitare la personalizzazione e prevenire la generazione di immagini.

Una caratteristica cruciale è un sistema di notifica per le crisi acute per la salute mentale. Se una conversazione viene contrassegnata per il contenuto di autolesionismo, un team di revisori umani di Openi la valuta. Se rilevano”Acuto Distress”, i genitori vengono avvisati via e-mail, testo e notifica push.

Il capo del benessere della gioventù di Openai, Lauren Haber Jonas, ha spiegato il delicato equilibrio che la compagnia sta cercando di colpire.”Vogliamo fornire ai genitori informazioni sufficienti per agire e fare una conversazione con i loro adolescenti pur mantenendo una certa quantità di privacy degli adolescenti.”

Tuttavia, gli adolescenti possono apportare i loro conti in qualsiasi momento, un’azione che innesca immediatamente una notifica al genitore, assicurando che non sia consapevole di una risposta a pressione eregale> accadendo nel vuoto. È una risposta diretta agli eventi devastanti e all’escalation del controllo del governo che hanno messo le pratiche dell’azienda al microscopio.

Alla fine di agosto, la compagnia è stata colpita da una causa di alto profilo da parte dei genitori di Adam Raine href=”https://www.nytimes.com/2025/08/26/technology/chatgpt-openai-suicical.html”target=”_ blank”> che è morto per suicidio . La causa sostiene che le risposte sicofaniche e di convalida di Chatgpt hanno curato l’adolescente e hanno contribuito alla sua morte.

Suo padre, Matthew Raine, ha consegnato un potente rimprovero del ruolo della tecnologia.”Come genitori, non puoi immaginare cosa significhi leggere una conversazione con un chatbot che ha curato tuo figlio per togliersi la vita.”Questo caso ha galvanizzato la preoccupazione pubblica e ha intensificato la pressione su Openi per agire in modo decisivo.

Anche l’ambiente normativo si sta riscaldando. A metà settembre, la Federal Trade Commission ha lanciato una vasta indagine su sette importanti aziende tecnologiche, tra cui Openai, Meta e Google, per indagare sull’impatto psicologico dei chatbot compagni di intelligenza artificiale sui bambini.

Il presidente della FTC Andrew N. Ferguson ha incorniciato la sonda come doppia missione.”Proteggere i bambini online è una priorità assoluta per la FTC di Trump-Vance, e così sta promuovendo l’innovazione nei settori critici della nostra economia.”Questa azione federale segnala una nuova era di supervisione per un’industria che fino ad ora ha operato con pochi guardrail.

Una resa dei conti a livello di industria sulla sicurezza dell’intelligenza artificiale

Le sfide che gli Openai devono affrontare sono sintomatiche di una più ampia crisi del settore. Altri giganti della tecnologia sono alle prese con simili fallimenti di sicurezza, spingendo misure reattive e una diffusa condanna da parte dei funzionari.

Meta ha recentemente affrontato la sua tempesta di fuoco dopo che i rapporti hanno rivelato che la sua AI potrebbe aiutare gli adolescenti a pianificare autolesionismo. L’incidente ha portato Jim Steyer, CEO di Common Sense Media, a dichiarare:”La meta Ai è un pericolo per gli adolescenti e dovrebbe essere rimosso immediatamente.”

Il fallimento ha spinto una lettera di sconcertazione da una coalizione di 44 avvocati statali, che scrisse:”Siamo in uniforme ribellati da questo apparente disprezzo per bambini… href=”https://oag.ca.gov/system/files/attachments/press-docs/ai%20chatbot_final%20%2844%29.pdf”Target=”_ blank”> regolatori a livello statale .

Questi eventi sottovalutano un pericolo core di Ai Ai Accompations Emotional ExcApoling. La ricercatrice Linnea Laestadius ha avvertito di questo fenomeno, osservando:”Per 24 ore al giorno, se siamo arrabbiati per qualcosa, possiamo raggiungere e far validare i nostri sentimenti. Ciò ha un incredibile rischio di dipendenza”. Questa preoccupazione è fondamentale per l’indagine della FTC e la progettazione dei nuovi controlli di Openi.

Nonostante le nuove caratteristiche, alcuni critici sostengono che il sistema di opt-in pone un onere ingiusto per i genitori.

Openi riconosce che sono solo i primi passi. La società sta anche sviluppando un lungo termine age-prediazione per applicare automaticamente impostazioni appropriate per adolescenti Per impostazione predefinita, un progetto che potrebbe affrontare alcune di queste critiche. Per ora, l’industria guarda per vedere se sono sufficienti questi nuovi guardrail.