Meta sta spostando i pali della gara di codifica AI. La società ha rilasciato il suo codice World Code (CWM), A potente sistema 32-billion-billion non solo a Writ-with-with-world-models/”target=”_ blow”> potente sistema 32-Billion-papara Opere.

Rilasciato per la ricerca non commerciale, CWM funge da”debugger neurale”, simulando la logica di un programma prima di funzionare.

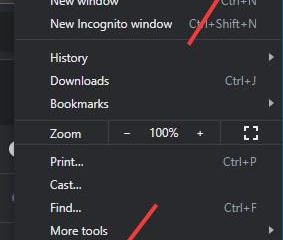

Questo approccio segna un perno strategico da parte di concorrenti come Google e Openai, che si sono recentemente concentrati sulle competizioni di codifica. src=”Dati: immagine/svg+xml; nitro-empty-id=mty1mdoxmziw-1; base64, phn2zyb2awv3qm94psiwidagmte2osa4mj Yiihdpzhropixmty5iibozwlnahq9ijgyniigeg1sbnm9imh0dha6ly93d3cudzmub3jnlziwmdavc3znij48l3n2zz4=”> L’obiettivo di

Meta, secondo i suoi ricercatori, è quello di colmare il divario tra l’aspetto del codice e ciò che fa effettivamente quando eseguito. Come ha spiegato un ricercatore,”per la codifica padroneggiata, non si deve capire non solo il codice ma cosa fa quando eseguito.”

Un”debugger neurale”che simula l’esecuzione del codice

La capacità unica di CWM deriva dal suo nuovo processo di formazione. Invece di analizzare solo il codice statico, il modello appreso da oltre 120 milioni di”tracce di esecuzione”dei programmi Python.

Questi dati gli hanno permesso di osservare le modifiche passo-passo nelle variabili di un programma, dandogli un modello profondo, causa ed effetto della logica del software.

Il nuovo paradigma di allenamento si muove al di là del semplice abbinamento. Comprendendo le conseguenze di ogni riga di codice, CWM può eseguire compiti oltre la semplice generazione.

può prevedere i risultati del programma, identificare i loop infiniti e persino analizzare la complessità algoritmica. Questo ragionamento più profondo è ciò che lo distingue in un campo affollato.

Performance competitive nell’arena di codifica AI

Nonostante la sua diversa attenzione, CWM detiene i suoi parametri di riferimento chiave del settore. Su SWE-Bench Verified, un test impegnativo di ingegneria del software del mondo reale, il modello ha ottenuto un punteggio di base del 53,9%, aumentando a un impressionante 65,8% con il ridimensionamento del tempo di prova.

Questa prestazione lo pone in vantaggio su molti conti di parametri open-4. un singolo test. Secondo il documento di ricerca di Meta, CWM dimostra anche un’ampia competenza segnando il 68,6% su LiveCodebench, il 96,6% su Math-500 e il 76% sull’AIME 2024 Mathematical Olimpiad. CWM eccelle particolarmente in compiti che richiedono una profonda comprensione del comportamento del programma.

Sull’altro di Meta bigobench benchmark

Inoltre, su un nuovo punto di riferimento chiamato Halteval, CWM ha raggiunto una notevole precisione del 94% nel prevedere se un programma terminerebbe o rimarrebbe bloccato in un ciclo infinito.

La capacità di ragionare sul flusso di esecuzione di un programma, piuttosto che solo la sua sintassi, è un obiettivo di design principale. Il punteggio più alto del modello del 94,3% sul punto di riferimento Cruxival per la comprensione del codice sottolinea ulteriormente il successo dell’approccio di Meta.

Le forti prestazioni su questo vario insieme di benchmark orientati al calcolo convalidano l’attenzione sulle tracce di esecuzione e sulla posizione di CWM di CWM come un nuovo strumento per la ricerca AI. (15)

Navigando le più ampie”guerre di riferimento”

L’ingresso di Meta arriva quando l’industria si avvicina ai limiti dei punteggi di riferimento. L’estate del 2025 vide una frenetica battaglia per il primo posto sulla panca SWE, con Claude Opus 4.1 di Antropico eclissata dal GPT-5 di Openai solo due giorni dopo.

Nel frattempo, il `Grok-Code-1-1″di Xai, il fast-1-fast-1″, per dare priorità alla velocità e al costo, una mossa che ha riconosciuto il mercato in crescita di Skepticism di Benchmark. GitHub’s Mario Rodriguez noted that “in early testing, Grok Code Fast has shown both its speed and quality in agentic coding tasks.”

This pursuit of high scores has sometimes led to real-world stumbles, such as the buggy launch of GPT-5.

Meta’s focus on robust, underlying logic with CWM appears to be a direct response, betting that reliability will ultimately importa più di una posizione di classifica.

aperto per la ricerca, ma non la produzione

Lo sfondo per il rilascio di CWM è un panorama di strumenti sempre più specializzati e potenti. OpenAI recently launched GPT-5-Codex, a coding version of GPT-5 that can work autonomously for hours.

Its product lead, Alexander Embiricos, highlighted its adaptive intelligence, stating, “GPT-5-Codex can decide five minutes into a problem that it needs to spend another hour.”

This trend toward advanced reasoning was also showcased at the ICPC World Finals, where Google’s Gemelli ha dimostrato la risoluzione dei problemi sovrumani.

DR. Bill Poucher, il regista ICPC, ha incorniciato questi risultati come un momento fondamentale, dicendo:”Gemini si uniscono con successo a questa arena e il raggiungimento dei risultati a livello di oro, segna un momento chiave per definire gli strumenti AI e gli standard accademici necessari per la prossima generazione.”

Meta sta contribuendo a questo evoluto rendendo CWM disponibile per la comunità di ricerca sull’abbracciare la faccia . Il modello, che può essere eseguito su una singola GPU NVIDIA H100, non è sintonizzato per la chat generale, sottolineando il suo scopo come strumento per far avanzare la scienza dell’IA stessa.