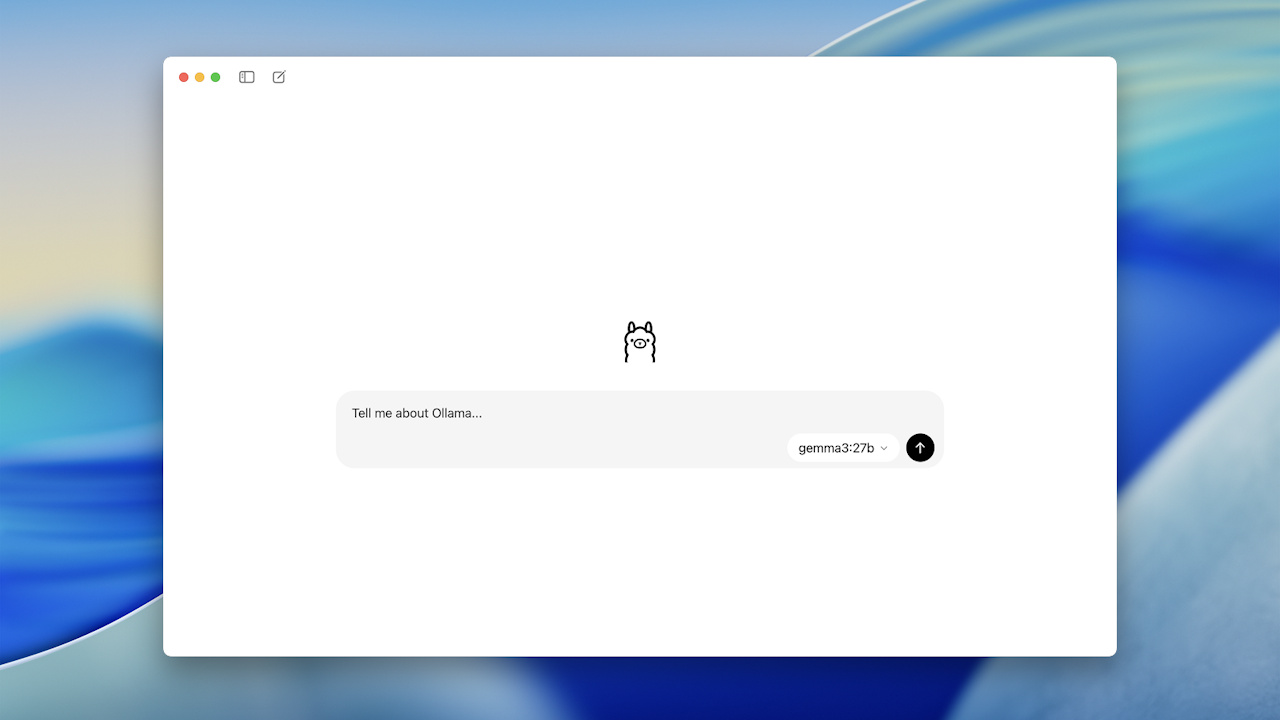

Ollama ha lanciato una nuova app desktop per macOS e Windows, rendendo semplice per chiunque eseguire potenti modelli AI sul proprio computer. Precedentemente noto per i suoi strumenti di comando per gli sviluppatori, la nuova app di Ollama offre un’interfaccia di chat intuitiva.

consente alle persone di scaricare e parlare con vari modelli di intelligenza artificiale e persino analizzare immagini o documenti con una semplice azione di drag-and-drop. Questo spostamento strategico rende l’intelligenza artificiale locale, che offre una privacy migliorata mantenendo tutti i dati sulla macchina di un utente, accessibili a un pubblico molto più ampio.

Dalla riga di comando al desktop: una nuova era di accessibilità

hel the href=”https://llama.com/blog/new-pp”Un perno significativo per Ollama, passando da uno strumento incentrato su sviluppatore a un prodotto tradizionale. Il nucleo dell’esperienza è la sua interfaccia utente grafica, che rimuove la necessità di competenze tecniche a iniziare con l’IA locale .

Gli utenti possono ora interagire con i modelli tramite una finestra di chat pulita, trascinare i file di rettifica per le lunghezza di rettifica per le lunghezza di rettifica per le rettifica di una religiosa per le lunghezza di chat per regolare. token.

Questa attenzione alla semplicità è un chiaro tentativo di ampliare il fascino degli LLM locali. Mentre gli utenti e gli sviluppatori di Power possono ancora accedere alla versione CLI tramite GitHub Page di Ollama , la nuova app è progettata per l’accessibilità. Può essere scaricato direttamente da Il sito Web dell’azienda .

sotto il cofano: il motore personalizzato che guida l’app

Questo frontale per l’utente è alimentato da uno sforzo di ingegneria significativo che ha iniziato a mesi fa. Nel maggio 2025, Ollama annunciò che stava sviluppando un motore multimodale proprietario, una partenza strategica dalla sua dipendenza dal popolare framework Llama.CPP. La società ha spiegato che la mossa era necessaria perché, nelle loro parole,”poiché più modelli multimodali vengono rilasciati dai principali laboratori di ricerca, il compito di supportare questi modelli nel modo in cui Ollama intende è diventato sempre più impegnativo.”

Questa sfida ha spinto lo sviluppo di una soluzione interna dettagliata nel suo , progettato per una migliore stabilità e prestazioni. Un obiettivo chiave della nuova architettura è quello di”limitare il”raggio di esplosione”di ogni modello, migliorando l’affidabilità e rendendo più facile per i creatori e gli sviluppatori integrare nuovi modelli”. Questo approccio modulare, con esempi disponibili su ollama di github , consente a ogni modello di essere autosufficiente, semplificare l’integrazione.

Il motore ha anche fatto una prestazione significativa per la gestione della memoria. Per migliorare l’accuratezza con immagini di grandi dimensioni, incorpora metadati aggiuntivi e gestisce il raggio più preciso. Presenta inoltre la memorizzazione nella cache delle immagini per mantenere le immagini elaborate in memoria per le ottimizzazioni di riutilizzo e KVCache per accelerare l’inferenza. Ollama ha osservato che sta collaborando attivamente con partner hardware come Nvidia, AMD e Intel per perfezionare la stima della memoria.

Il panorama competitivo e le limitazioni attuali

La nuova app di Ollama inserisce un mercato in crescita per gli strumenti locali ma scolpisce un nevicatore distinto per prioritario e facilitato. Mentre alternative più avanzate come LMStudio soddisfano gli utenti con ampie opzioni di configurazione, Ollama sta scommettendo su un’esperienza semplificata per attirare gli utenti che sono tecnicamente meno inclini. La società ritiene che i suoi vantaggi si trovino nella qualità, l’accessibilità e le relazioni di supporto diretto con i principali laboratori di ricerca di intelligenza artificiale.

Tuttavia, questa attenzione alla semplicità significa che il rilascio iniziale presenta alcune limitazioni notevoli. L’app attualmente manca di funzionalità più avanzate trovate su altre piattaforme, come le anteprime in diretta del codice generato o la possibilità di generare immagini. Inoltre, la libreria di modelli disponibile attraverso l’interfaccia grafica è curata, offrendo attualmente una selezione limitata di modelli più piccoli da Gemma, DeepSeek e Qwen. Ciò contrasta con la gamma molto più ampia di modelli accessibili agli sviluppatori attraverso l’interfaccia di comando tradizionale di Ollama, che rimane disponibile nella sua pagina di rilasci GitHub.

sul fronte hardware, alcuni utenti hanno sottolineato una lacuna significativa nella versione macOS: manca di supporto per MLX, il framework di apprendimento machine di Apple ottimizzato per Apple Silicon. Questa omissione potrebbe significare che le prestazioni sui moderni computer Mac non sono così efficienti come potrebbero essere, un dettaglio che è probabile che gli utenti tecnicamente esperti notino.

Nonostante questi primi limiti, il lancio rappresenta una direzione strategica chiara e deliberata. Ollama si sta posizionando come piattaforma di riferimento per gli utenti che desiderano la privacy e il controllo dell’intelligenza artificiale locale senza la ripida curva di apprendimento. La tabella di marcia dell’azienda suggerisce che questo è solo l’inizio, con piani futuri per supportare dimensioni di contesto più lunghe, ragionamento più sofisticato e chiamate di strumenti. Questa mossa potrebbe espandere in modo significativo la base di utenti per i modelli open source, sebbene introduca anche potenziali nuove strade per uso improprio man mano che questi potenti strumenti diventano più facili da accedere.