Il Dipartimento dell’efficienza governativa (DOGE) dell’amministrazione Trump sta utilizzando un nuovo strumento di intelligenza artificiale per tagliare le regole federali, secondo il Washington Post. Il progetto mira a rimuovere fino alla metà di tutte le normative governative entro gennaio 2026.

Lo strumento di decisione di deregolamentazione”DOGE AI”Secondo quanto riferito trova regole che potrebbero non essere più richieste dalla legge . La Casa Bianca afferma che questo aumenterà l’efficienza e taglierà gli oneri economici. Tuttavia, il piano deve affrontare una forte critica sulla sua legalità e velocità.

Gli esperti si preoccupano anche di usare un’intelligenza artificiale non testata per i compiti del governo vitali. The tool has already been tested at federal agencies, sparking debate over its accuracy and the potential consequences of automated governance on such a massive scale.

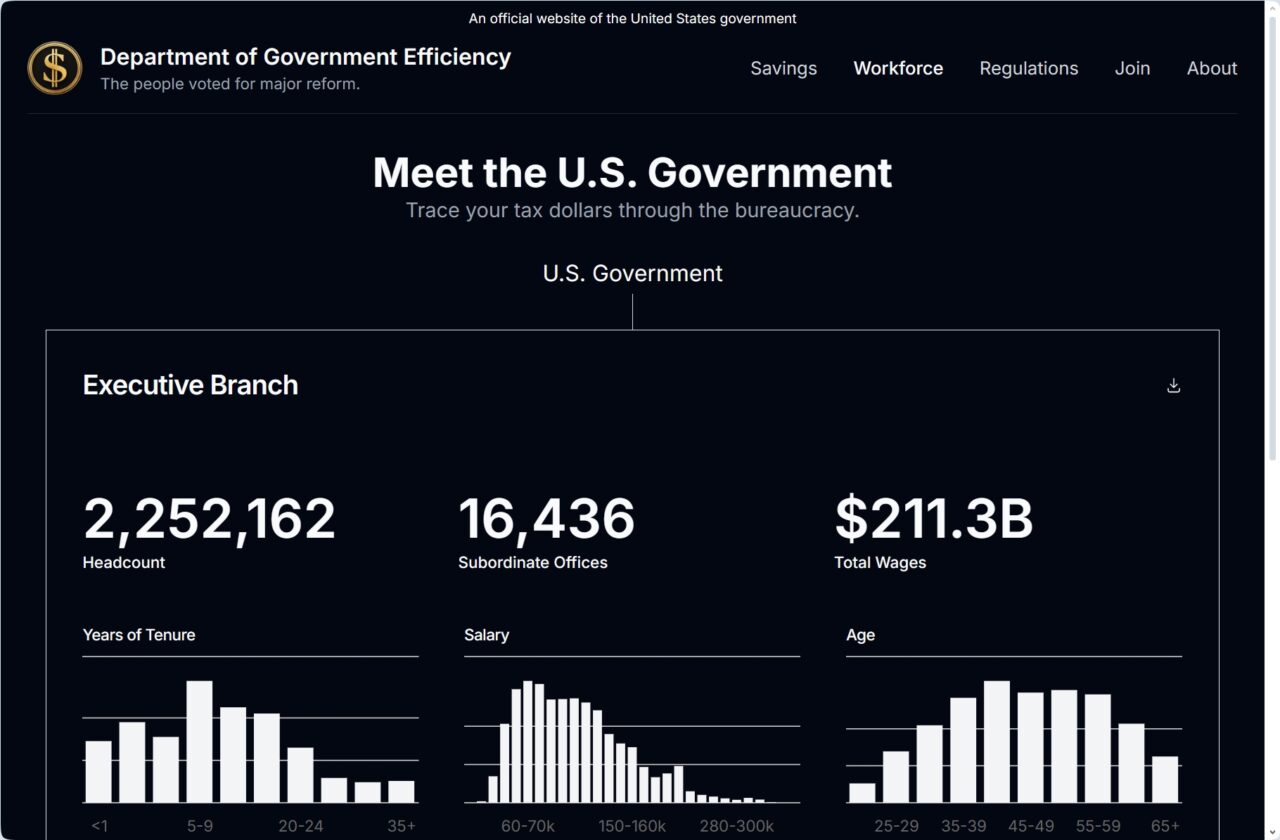

DOGE Deploys AI to Automate Deregolamentazione

L’iniziativa è la testa tecnologica di una politica delineata per la prima volta in un , che ha incaricato un enorme sforzo di deregolamentazione del”10 a 1″in tutto il governo. Lo strumento AI di DOGE è progettato per soddisfare questa direttiva analizzando algoritmicamente l’intero corpo delle regole federali.

soprannominato lo”strumento decisionale di deregolamentazione di DOGE”, il sistema ha il compito di sottoporsi a circa 200.000 regolamenti per identificare i candidati, secondo un presentazione interno di Doge PowerPoint . L’obiettivo dichiarato è quello di rimuovere 100.000 regole-la metà del codice normativo-dal primo anniversario dell’inaugurazione.

La presentazione fa affermazioni audaci, proiettando l’IA può salvare l’economia degli Stati Uniti $ 3,3 trilioni all’anno. Suggerisce inoltre che lo strumento potrebbe ridurre circa 3,6 milioni di ore di revisione umana necessarie per tale compito a soli 36 ore.

La Casa Bianca ha supportato pubblicamente gli obiettivi del progetto. Il portavoce Harrison Fields ha confermato che”tutte le opzioni vengono esplorate per ottenere le promesse di deregolamentazione del presidente”. Ha elogiato l’iniziativa, affermando:”Gli esperti di Doge che creano questi piani sono i migliori e più brillanti nel settore e si stanno intraprendendo in una trasformazione mai sfortunata dei sistemi governativi”, inquadrandolo come una fase di rivoluzionamento. In HUD, secondo quanto riferito, il sistema ha preso”decisioni su 1.083 sezioni normative”in meno di due settimane, mentre al CFPB è stato usato per scrivere”100% di deregulazioni”.

Tuttavia, il lancio iniziale non è stato senza problemi significativi. A HUD employee, speaking anonymously, told The Washington Post that the AI made several errors, incorrectly flagging legally sound regulations as being outside of the statute it was supposed to be analyzing.

A Pattern of Security Lapses and Controversial Methods

This aggressive push for AI-driven deregulation fits a broader pattern of controversial actions by DOGE. Fin dalla sua istituzione, l’agenzia è stata criticata per aver aggirato i protocolli di sicurezza e approvvigionamento standard mentre cercava un vasto accesso ai dati.

La sicurezza operativa del dipartimento è stata discutibile. A febbraio, il suo sito Web pubblico è stato lasciato con un database non protetto, consentendo che fosse deturpato per ore. Questo incidente ha sollevato le prime domande sulla competenza tecnica del gruppo di recente formazione.

Più allarmante, le credenziali di Kyle Schutt, un ingegnere che lavorano sia per DOGE che per CISA, sono state trovate in più dump di dati di malware a maggio, indicando che i suoi dispositivi erano stati compromessi da malware per le informazioni. Un funzionario NLRB ha affermato che DOGE ha facilitato una violazione dei dati, istruendo al personale di evitare di creare registri delle loro attività: una grande violazione delle migliori pratiche di sicurezza.

Le ambizioni di AI di DOGE si estendono oltre la deregolamentazione. Secondo quanto riferito, il gruppo ha utilizzato Grok Chatbot di Xai per analizzare i dati federali e ha fluttuato i piani per distribuire”agenti di intelligenza artificiale”per sostituire il lavoro di un massimo di 70.000 dipendenti federali.

La legalità delle domande e la fattibilità

La velocità e la scala del piano di Doge hanno disegnato criticismi legali e di sicurezza della cybersicurezza. Nicholas Bagley, un esperto di diritto amministrativo, notato che limita il limite di regolamenti federali governati dalla procedura amministrativa, non lelaterali.

Questa legge richiede alle agenzie di fornire una spiegazione motivata per il cambiamento delle regole, uno standard che un’intelligenza artificiale nera potrebbe avere difficoltà a soddisfare. Gli studiosi legali suggeriscono che semplicemente affermare che un’intelligenza artificiale ha trovato una regola inutile probabilmente non avrebbe fallito una sfida del tribunale, potenzialmente legando lo sforzo di deregolamentazione in contenzioso.

La legalità dell’uso di un’intelligenza artificiale per prendere queste determinazioni non è testata. L’ex avvocato capo del DOGE James Burnham ha riconosciuto l’approccio del romanzo, affermando:”Lo spiegamento creativo dell’intelligenza artificiale per far avanzare l’agenda normativa del presidente è una strategia logica per fare progressi significativi in quel periodo limitato di tempo”, suggerendo che la squadra sapeva che stava spingendo i confini legali e tecnologici.

L’iniziativa esiste in un clima climatico di disturbo da parte di Doge. L’esperto di sicurezza informatica Bruce Schneier ha descritto lo smantellamento sistematico del gruppo dei protocolli di sicurezza in modo simile a”un attacco informatico nazionale… lo smantellamento sistematico delle misure di sicurezza che avrebbero rilevato e impedito abusi”. Questo contesto rende anche il dispiegamento di un nuovo, potente strumento di intelligenza artificiale.

Anche la fattibilità del piano è in dubbio. I dipendenti federali e gli esperti contraenti affermano che la complessità dei regolamenti tra le agenzie renderebbe difficile la distribuzione ridimensionata. La nozione di sostituire 70.000 posti di lavoro con l’attuale tecnologia di intelligenza artificiale è stata respinta come irrealistica.

come Doge si muove per formare il personale delle agenzie sul nuovo strumento, le domande fondamentali rimangono. Non è chiaro se un’intelligenza artificiale non testata possa gestire la sfumatura della legge federale o se questo approccio automatizzato ad alta velocità alla governance creerà più problemi di quanto risolva.