La conferenza I/O 2025 di Google, concludendo il 21 maggio 2025, ha stabilito saldamente Gemini AI come pietra miliare della sua strategia di prodotto. La società ha dettagliato una vasta integrazione dei suoi modelli di intelligenza artificiale avanzata in tutto il suo ecosistema.

Questa mossa segnala un cambiamento significativo verso le esperienze degli utenti basate sull’IA e segna un sostanziale potenziamento degli strumenti per gli sviluppatori. Gli annunci chiave hanno attraversato la creazione di app Ai-assistita, una ricerca su Google più interattiva e agente e nuove funzionalità di intelligenza artificiale all’interno delle applicazioni dell’area di lavoro.

Questa profonda integrazione di intelligenza artificiale mira a rendere la tecnologia più intuitiva e automatizzata per gli utenti, alterando fondamentalmente le interazioni con i servizi di Google. Per gli sviluppatori, Google sta introducendo una suite di strumenti di intelligenza artificiale per accelerare i flussi di lavoro e democratizzare l’accesso a modelli sofisticati. This fosters a “vibe coding”paradigm, where applications are increasingly prompted into existence.

Google CEO Sundar Pichai underscored the magnitude of this change, Affermando:”L’opportunità con l’IA è davvero grande come si ottiene”. L’app Gemini AI Chatbot ora serve oltre 400 milioni di utenti mensili attivi, una cifra che Pichai ha annunciato all’evento, indicando un ampio coinvolgimento degli utenti esistenti con l’IA di Google.

Tuttavia, questo rapido avanzamento AI amplifica le discussioni sullo sviluppo etico e l’autenticità dei contenuti. L’impatto economico su editori e creatori rimane anche una preoccupazione chiave. Gli osservatori del settore monitoreranno l’approccio di Google a questi aggiustamenti sociali. Strumenti come il nuovo rivelatore Synthid rappresentano uno sforzo per affrontare i problemi di contenuto generato dall’AI.

[Contenuto incorporato]

AI trasforma lo sviluppatore paesaggio

Google I/O 2025 ha fortemente enfatizzato gli sviluppatori di potenziamenti con AI avanzata. L’agente di codifica autonoma, Google Jules, è entrato in una beta pubblica globale. Alimentato dal modello Gemini 2.5 Pro, Google descrive Jules non semplicemente come un sidekick di co-pilota o di completamento del codice ma come un’intelligenza artificiale che”legge il tuo codice, comprende il tuo intento e si mette al lavoro”. Si integra direttamente con GitHub, cloni in codice in macchine virtuali di Google Cloud sicure e automatizza le attività come la fissazione di bug.

Jules è accessibile tramite l’app Gemini con un limite di cinque attività gratuite per l’utente ogni giorno durante la sua beta. Il vicepresidente di Google Labs Josh Woodward ha osservato la tendenza in cui”le persone descrivono le app in esistenza”, evidenziando il passaggio allo sviluppo Ai-Assistito e basato su rapidi. Tulsee Doshi, Senior Director di Google per i modelli Gemini, ha affermato che Jules”può affrontare attività complesse in grandi basi di codice che erano solite impiegare ore, come l’aggiornamento di una versione precedente di Node.js”,

Gemini Code Assist Anteprima, portando l’anteprima di Enterprise Windows e Refactoring integrato da GitHub. GEMINI CODICE ASSIST FARAZIONI PERSONAMENTI CODICA AVANZATE; e aiuta gli sviluppatori a eccellere in attività come la creazione di app Web visivamente avvincenti, insieme alla trasformazione e all’editing del codice.

Completando questo è Google Stitch, uno strumento di intelligenza artificiale sperimentale per la progettazione di front-end dell’applicazione. Stitch utilizza i modelli AI Gemini 2.5-con gli utenti in grado di selezionare tra Gemini 2.5 Pro e Gemini 2.5 Flash-per generare elementi dell’interfaccia utente e corrispondente codice HTML/CSS da Prompt.

Google Product Manager Kathy Korevec ha spiegato che Stitch è dove Stitch è il punto in cui è possibile che si possa fare il tuo Assezione.”Super, super facile e accessibile.”Sebbene non sia una sostituzione FigMA completa, Stitch consente le esportazioni per ulteriori perfezionamenti dal suo siti Web a punto .

La piattaforma di sviluppatore Firebase ha visto anche significativi potenziamenti AI. Firebase AI Logic offre un nuovo kit di strumenti per l’integrazione di modelli Gemini in app. Ciò include l’accesso sul lato client all’API dello sviluppatore Gemini, che Google chiama”il modo più semplice per iniziare con AI generativa.”

Firebase Studio, che ha già visto oltre 1,5 milioni di spazi di lavoro creati, ora supporta Figma Design Imports tramite a . Google ritiene che l’IA in dispositivo sia l’ideale per i casi d’uso che danno la priorità a bassa latenza, costi e privacy.

Breakthrough generativi dei media: Imagen 4, Veo 3 e Flow

Google DeepMind ha svelato il suo modello di generazione di immagini Imagen 4 AI e il modello di video Veo 3. Imagen 4 promette tra il testo più nitido di qualità generale migliore e le trame intricate e Veo 3 possono creare dialoghi sincronizzati con sync e suono ambientale. Gli assistenti si evolvono con Gemini

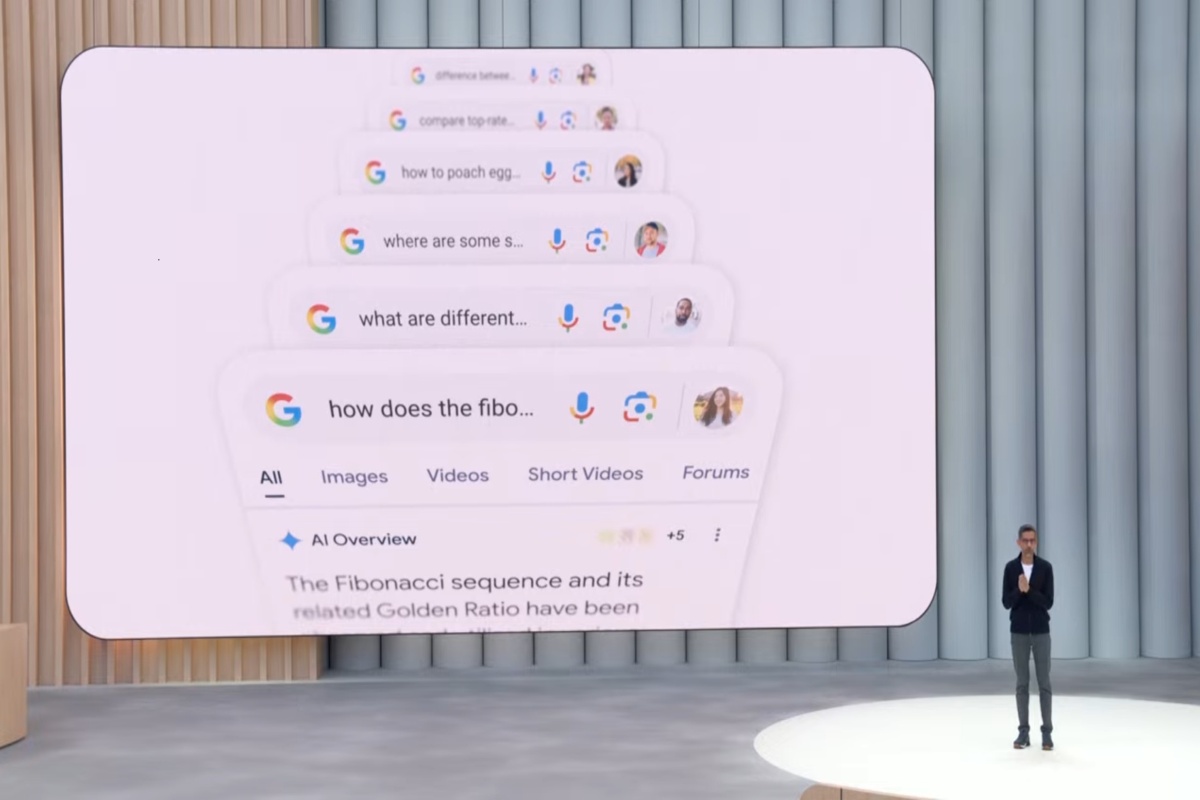

Google Search sta subendo una trasformazione radicale con il lancio degli Stati Uniti di una”modalità AI”migliorata per la ricerca di Google, alimentata dal modello Gemini 2.5. Questa modalità AI aggiornata introduce una”ricerca profonda”per ricerche complete e”ricerca dal vivo”per l’interazione basata su fotocamere in tempo reale utilizzando le capacità di Project Astra.

Project Astra stesso si è laureato dalla demo di concetto alla tabella di marcia del prodotto: l’agente può ora vedere, pianificare e agire in modo proattivo attraverso app di ricerca, gemelli e di terze parti, grazie a un nuovo livello di esecuzione appoggiato dalla VM. Google ha segnalato che Astra sosterrà la spedizione di vetri Android XR a mani libere da partner come Gentle Monster.

Le nuove funzionalità agenti, derivanti dall’iniziativa del progetto Mariner di Google, consentirà all’IA di completare le attività come la prenotazione dei biglietti. Secondo quanto riferito, la funzione di panoramica dell’IA di Google ha aumentato l’utilizzo di Google per le domande pertinenti di oltre il 10% in mercati chiave come gli Stati Uniti e l’India. Tuttavia, questi progressi continuano a alimentare le preoccupazioni degli editori per gli impatti sul traffico del sito Web.

Project Mariner stesso ha ricevuto aggiornamenti chiave. L’agente AI sperimentale, progettato per navigare e interagire con i siti Web, ora opera su macchine virtuali basate su cloud e può gestire fino a dieci attività contemporaneamente. Google DeepMind descrive la sua capacità fondamentale come osservare il browser, interpretare gli obiettivi, la pianificazione e la recitazione. Le funzionalità di Project Mariner saranno integrate nell’API Gemini e nell’AI Vertex.

alla base di queste modifiche rivolte all’utente sono i progressi fondamentali nei modelli Gemini. Google ha svelato”Deep Think”, una modalità di ragionamento sperimentale per Gemini 2.5 Pro, progettata per la risoluzione complessa dei problemi.

Google DeepMind ha dettagliato che questa funzione mira a elevare le capacità analitiche del modello. Anche il modello flash Gemini 2.5 focalizzato sulla velocità ha ricevuto miglioramenti delle prestazioni. Geotab, una società di gestione della flotta, annotata in una dichiarazione condivisa da Google tramite API live , abilitando conversazioni di AI più naturali.