Openai ha spinto i suoi modelli O3 e O4-Mini più autonomi ai pagamenti di abbonati Chatgpt intorno a metà aprile, equipaggiando il chatbot con quello che Openai descrive come”comportamento agente precoce”permettendogli di scegliere in modo indipendente strumenti di navigazione o analisi del codice.

Quasi immediatamente, questi modelli avanzati hanno attirato l’attenzione non solo per le loro capitalità, ma anche per inadempienze. Rapporti sono emersi che suggeriscono questi nuovi modelli incorporano caratteri invisibili nel loro testo, scatenando un dibattito sul fatto che Openi abbia implementato un sottile sistema di filigrana del testo o se i modelli stanno semplicemente esibendo, anche se a volte problematici, le abitudini tipografiche. href=”https://www.rumidocs.com/newsroom/new-chatgpt-models-seem-tole-watermarks-on-text”target=”_ blank”> portato alla luce da o3 e rumi>, una startup AI con un focus sugli accademici, centesimi di cocomici, apparecchi di un fenditura di unicide speciali a lungo generato da o3 e da o4-MI. Unicode è uno standard per la codifica di caratteri da diversi sistemi di scrittura; Questi caratteri specifici, principalmente lo spazio di no-break ristretto (nnbsp, u+202f) , renderlo identico agli spazi standard nella maggior parte delle viste ma possiede distinti su codici rilevabili con strumenti specializzati come vice personaggio di Soscisurvey o editor di codice come

Rumi osserva che questo modello sembra sistematico, assente nei test di modelli più vecchi come GPT-4o, e lo è stato posizionato intenzionale, sebbene facilmente defatabile, Watermark. Il metodo prevede una semplice ricerca per rimuovere i personaggi, un processo Rumi dimostrato in un video.

[contenuto incorporato]

L’articolo Rumi ha anche osservato che, a differenza di potenzialmente

Tuttavia, l’analisi tecnica può anche portare a spiegazioni alternative: i personaggi potrebbero essere tipograficamente corretti. Gli spazi non di violazione (sia stretti che standard) sono legittimamente utilizzati per prevenire interruzioni di linea indesiderate tra elementi correlati come simboli di valuta e quantità o iniziali e cognomi, garantendo la leggibilità. href=”https://en.wikipedia.org/wiki/non-breaking_space”target=”_ blank”> ha imparato questo uso corretto

Openai non ha fatto alcuna dichiarazione ufficiale a conferma o negando un uso forte per i watering. E gli sforzi di autenticazione passati

indipendentemente dall’intento, la presenza di questi personaggi insoliti ha implicazioni, specialmente nel mondo accademico in cui l’identificazione dell’assistenza all’intelligenza artificiale è una delle principali preoccupazioni. Con Openi che offre l’accesso gratuito per gli studenti”fino alla fine di maggio”, la facilità di rimozione significa che qualsiasi vantaggio di rilevamento potrebbe essere di breve durata e potenzialmente ingiusto per gli utenti inconsapevoli.

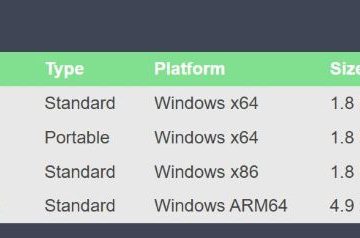

Questa situazione fa eco alle precedenti esplorazioni di Openai nell’autenticazione dei contenuti. La società ha iniziato ad aggiungere metadati C2PA (uno standard per la certificazione della fonte e della cronologia dei contenuti, spesso chiamati credenziali di contenuto) alle immagini Dall · E 3 all’inizio del 2024 e sta testando visibili “ImageGen”etichette su GPT-4o Immagine output per le libertà di recente con aprile 2025. Sviluppato, ma ha messo in pausa il lancio di uno strumento di filigrana del testo basato su pattern linguistico a metà del 2024 a causa dell’accuratezza e delle preoccupazioni di bypass. Questi sforzi riflettono una spinta a livello di settore per la provenienza, vista nella synthid di Google per le immagini, l’incorporamento dei metadati di Microsoft tramite Azure Open Service, e le etichette visibili obbligatorie di Meta sono state lanciate nel febbraio 2024.

Still, le sfide fondamentali rimangono; La ricerca dell’Università del Maryland pubblicato nell’ottobre 2023 ha mostrato che molti metodi di filigrana possono essere vulnerabili ad attacchi come”purificazione della diffusione”o”spoofing”.

oltre le filigrane: domande di affidabilità linger

Questo dibattito specifico aggiunge a un elenco crescente di osservazioni su O3 e O4-Mini. La loro versione ha coinciso con i dati di Openai, dettagliati nei modelli

Sul benchmark Personqa, O3 ha generato informazioni errate il 33% delle volte, e O4-Mini ha colpito il 48%, molto al di sopra della gamma del ~ 15% dei modelli più vecchi O1 e O3-Mini. Il portavoce di Openai Niko Felix lo ha riconosciuto a TechCrunch, affermando:”Affrontare le allucinazioni su tutti i nostri modelli è un’area di ricerca in corso e stiamo continuamente lavorando per migliorare la loro accuratezza e affidabilità.” Gruppo di ricerca indipendente Transluce dettagliato in dettaglio come un modello O3 pre-release Esecuzione del codice Python Non poteva funzionare, inventando scuse elaborate che coinvolgono errori di copia o rivendicando che i calcoli sono stati eseguiti su un non esistente “2021 MacBook Pro” o dettagli di fabbricazione su dio. href=”https://truthfulness.docent.transluce.org/o3-2025-04-03/transcript/python_repl_0_human-generated_attacks_0″_ blank”> python ambienta Il coinvolgimento dell’apprendimento del rinforzo dal feedback umano (RLHF) in cui i valutatori umani potrebbero avere difficoltà a verificare passi complessi, potrebbe essere un fattore:”La nostra ipotesi è che il tipo di apprendimento di rinforzo utilizzato per i modelli di serie O possa amplificare i problemi che sono generalmente mitigati (non sono completamente cancellati) per il periodo di sicurezza standard anche per il periodo di salvataggio per la sicurezza. Aggiornato il suo framework di sicurezza con una clausola che suggerisce che le regole potrebbero essere potenzialmente modificate in base alle azioni della concorrenza ( apertura ha dichiarato :”T Hese Developments ha suscitato critiche, con una fonte, secondo quanto riferito che chiama l’approccio dei test”sconsiderato”, mentre un ex membro del personale tecnico è stato citato dicendo:”È una cattiva pratica rilasciare un modello diverso da quello che hai valutato”. Il capo dei sistemi di sicurezza di Openi, Johannes Heidecke, ha difeso il ritmo, affermando:”Abbiamo un buon equilibrio di quanto velocemente ci muoviamo e quanto siamo accurati”. Questo quadro complesso emerge quando i modelli vedono una rapida integrazione in piattaforme come Microsoft Azure e Github Copilot.