Openai sembra prepararsi a introdurre un nuovo significativo ostacolo per gli sviluppatori che vogliono accedere ai suoi più potenti modelli di AI futuri tramite API: un potenziale requisito per le organizzazioni per sottoporsi alla verifica dell’identità utilizzando ID emessi dal governo.

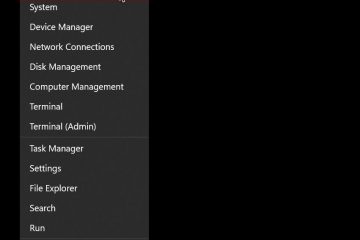

Dettagli emergenti da un href=”href=”https://help.openai.com/En/Articles/10911-apization”Target=”_ blank”> Pagina di supporto aperta La scorsa settimana descrivi un processo di”organizzazione verificata”, incorniciato dalla società come un passo necessario per contrastare l’abuso e promuovere la distribuzione responsabile dell’intelligenza artificiale. Openi suggerisce che ciò si rivolge a una”piccola minoranza”che viola intenzionalmente le sue politiche di utilizzo, con l’obiettivo di”mitigare l’uso non sicuro dell’IA mentre continua a rendere i modelli avanzati disponibili per la più ampia comunità di sviluppatori.”

Questa verifica collega una verifica autorizzata a tutte le assicudi per tutti i giorni di garanzia, non garantita per tutti i giorni di garanzia, non garantisce una garanzia per la garanzia, non è garantita una garanzia per la garanzia, non è garantita una garanzia per la garanzia, non è garantita una garanzia per le abili, non è garantita una garanzia per le abili, non è garantita una garanzia per le assicudi, non è garantita una garanzia per le assicudi, non è garantita una garanzia per i giorni di garanzia. sollevare domande sui criteri specifici.

Il sistema proposto sta già generando una discussione tra gli sviluppatori online. Centro di preoccupazione per l’attrito operativo aggiunto, le considerazioni sulla privacy della presentazione dell’identificazione del governo, la potenziale esclusione degli utenti in regioni al di fuori di

sottolineare i tempi della politica rivela. Nuovi lanci potrebbero avvenire non appena questa settimana, incluso GPT-4.1 come aggiornamento al suo modello multimodale GPT-4O, insieme a modelli di ragionamento specializzati designati Designati O3, O4-Mini e O4-Mini-High. La strategia di lancio del modello di Openai allinea con una significativa regolazione strategica confermata dal CEO Sam Altman al 4 ° aprile. Annunciando un”cambio di piani”, Altman ha dato la priorità al rilascio dei modelli O3 e O4-Mini”probabilmente in un paio di settimane”, mentre spinge il debutto del tanto atteso GPT-5 di”e ha twitato i modelli di chat-5 per fare la compagnia”, suggerendo la compagnia”, suonare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”da fare”per fare la compagnia”per fare la compagnia”per fare la compagnia”per fare la compagnia”da fare per le compagnie”per fare la compagnia”da fare per le compagnie”. GPT-5 molto meglio di quanto inizialmente [t].”Ciò ha invertito un piano da febbraio 2025 per piegare potenzialmente le capacità di O3 in GPT-5. La necessità di distinti modelli di ragionamento era evidente anche dopo il lancio di fine febbraio di GPT-4.5, che è un blazzo di Opentai”_ Blank”A corto di modelli specializzati su alcuni benchmark intensivi logici, nonostante Altman In un post sul blog , ha sostenuto che ciò potrebbe portare i laboratori a sottovalutare i pericoli, Dicendo ai tempi finanziari ,”Non fare tali test potrebbe significare OpenAi e le altre società di AI stanno conducendo i peggiori rischi dei loro modelli.”Sono state inoltre sollevate preoccupazioni sui test delle versioni del modello intermedio o dei checkpoint, invece del codice finale spedito al pubblico.”È una cattiva pratica rilasciare un modello diverso da quello che hai valutato”, un ex membro del personale tecnico menzionato al Ft. Il capo dei sistemi di sicurezza di Openai, Johannes Heidecke, ha contrastato questi punti, affermando:”Abbiamo un buon equilibrio di quanto velocemente ci muoviamo e quanto siamo accurati”, attribuendo la velocità di attribuzione dell’automatizzazione e che gli sono stati contrastati i punti di checkpoint”. > Tensioni interne e sfondo del settore

Questa apparente attrito tra velocità di sviluppo e cautela della sicurezza non è un nuovo territorio per OpenIA. I disaccordi interni furono sottolineati dalla partenza del maggio 2024 di Jan Leike, quindi co-conduttore del team di sovraallineamento incentrato sul rischio a lungo termine, che dichiarava pubblicamente che”la cultura e i processi di sicurezza hanno preso un sedile posteriore per i prodotti brillanti.” Aggiungendo un’altra dimensione alla dinamica interna dell’azienda, ex dipendenti di Openi hanno presentato un briefing di Amicus su Elon. Il brief sostiene che il passaggio di Openi verso una struttura a profitto a tappo si discosta dalla sua missione senza scopo di lucro fondata, influendo potenzialmente agli impegni di sicurezza e all’allocazione delle risorse. La potenziale politica di verifica dell’ID si svolge mentre i concorrenti si impegnano a una sicurezza pubblica e trasparenza di una deepazione globale, come una società di deepa, anche una società di deepazione globale) Struttura di sicurezza AGI. Ciò si verifica su uno sfondo di nascente regolamentazione come la legge AI dell’UE, le scoperte in corso di vulnerabilità del modello e le tecniche di prigione, e Opens’s Own Href=”https://x.com/sama/status/1907098207467032632″. Nuovi lanci. nuovi modelli potrebbero scatenare nuovi controlli