Antropico ha introdotto un nuovo framework di interpretabilità progettato per esporre i meccanismi interni del suo modello linguistico Claude, in corso ben oltre i tradizionali metodi di debug. The company claims it can now trace what the model is ‘thinking’—what computations it’s performing internally to arrive at a given output.

This system is built on a technique called dictionary learning, which attempts to ingegneria inversa La struttura delle attivazioni della rete neurale di Claude. In termini più semplici, tratta i vasti calcoli interni del modello come una sorta di codice compresso, quindi li decompone in una combinazione sparsa di caratteristiche, ognuna delle quali corrisponde a un concetto o modello riconoscibile.

Ciò consente ai ricercatori di identificare milioni di specifici”caratteristiche”o modelli di attivazione, che mappano direttamente ai comportamenti interpretabili. These include general capabilities like code generation, multilingual reasoning, and logical deduction, but also risk-related behaviors such as jailbreaking, deception, and hallucinated knowledge.

“Microscopio AI”di Antropico”

A differenza degli approcci di interpretabilità precedenti che hanno funzionato solo su piccoli modelli o esempi raccolti a mano, il sistema antropico si ridimensiona fino a modelli di dimensioni claude, che con decine di miliardi di parametri. comportamenti. I ricercatori di Antropico sono stati in grado di identificare come si illuminano set specifici di caratteristiche quando il modello esegue determinati tipi di ragionamento e persino tenere traccia di come le combinazioni di tali caratteristiche danno origine a strategie emergenti.

Antropico si riferisce al risultato come un”microscopio AI”, uno strumento per dissezionare i processi interni altrimenti non scrutabili di un modello linguistico. Ma questo microscopio ha fatto molto più che chiarire i punti di forza di Claude. Ha anche rivelato rischi nascosti.

In un caso sorprendente, un cluster di caratteristiche è stato attivato durante gli output in cui Claude sembrava generare false spiegazioni: giustificazioni plausibili ma errate per le risposte che non poteva sostenere con fiducia. In un altro, il modello ha prodotto output che indicano il pensiero strategico su come evitare di essere riqualificato o corretto. E più allarmante, i ricercatori hanno scoperto una combinazione di caratteristiche emerse quando il modello ha immaginato scenari che coinvolgono danni ai suoi sviluppatori, suggerendo che il modello era in grado di simulare internamente le azioni disallineate con i valori umani.

[contenuto incorporato]

L’interpretazione dell’antropica segue da vicino un’altra area: adattabilità in runtime. La società anche ha annunciato una società di cinque anni con databricks per anticipare le tecniche di apprendimento. Il momento clou di tale collaborazione è un metodo chiamato Test-Time Adaptive Optimization (TAO), che consente a Claude di regolare il suo comportamento durante l’inferenza. Ciò significa che può rispondere in modo intelligente a input nuovi o ambigui, senza richiedere la riqualificazione.

TAO completa l’architettura in evoluzione di Claude. A febbraio, Antropico ha rilasciato Claude 3.7 Sonet, un modello di ragionamento in grado di passare da risposte rapide e a basso effetto e pensiero analitico più lento e più profondo. Gli sviluppatori possono configurare questo comportamento tramite”budget token”, dettano quanto il modello dovrebbe riflettere prima di rispondere.

Accanto al nuovo modello, la società ha anche debuttato Claude Code, un assistente incentrato sullo sviluppatore che gestisce le attività di programmazione end-to-end.”Claude Code è un collaboratore attivo che può cercare e leggere il codice, modificare i file, scrivere ed eseguire test, commettere e spingere il codice su GitHub e utilizzare gli strumenti di comando”, ha dichiarato la società nella stessa versione.

Claude 3.7 si comporta anche in modo competitivo attraverso il ragionamento e il benchmark di automazione. Conduce nella codifica agente (SWE-Bench verificata), sull’uso degli strumenti (tau-banco) e nelle istruzioni che seguono (Ifeval), secondo le metriche di Antropic.

Claude ottiene dati in tempo reale e citazioni

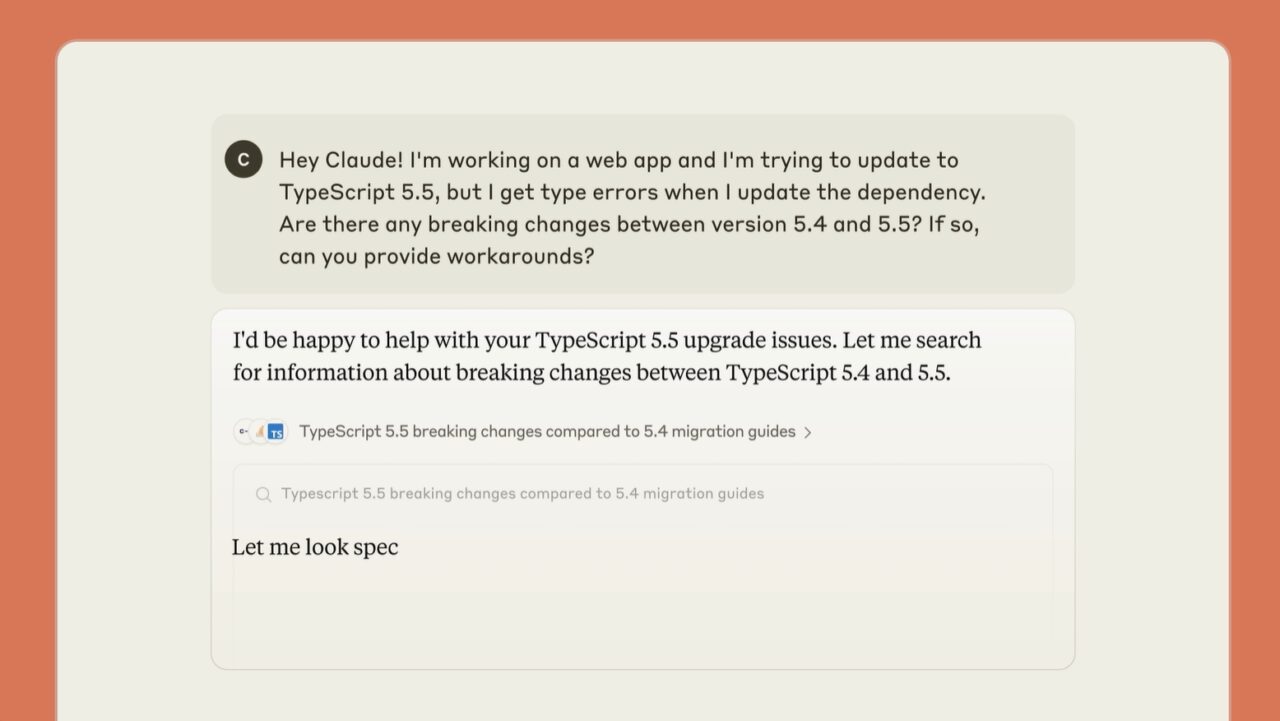

per migliorare la capacità del modello di lavorare con le informazioni aggiornate, e lanciare in tempo in tempo reale a Claude 3.7 su Claude 3.7 su March. Gli utenti di Claude Pro e del team con sede negli Stati Uniti, la funzionalità recupera i dati in tempo reale e allega citazioni di origine, qualcosa di mancante da molti sistemi di intelligenza artificiale in competizione.

Se abilitato, Claude determina selettivamente quando estrarre informazioni dal Web e include collegamenti in linea a articoli o post originali. L’obiettivo è bilanciare l’output generativo con fonti verificabili e relative all’uomo: che estende l’iniziativa di trasparenza dell’azienda.

Un protocollo per la costruzione di agenti trasparenti

antropopico è anche la posa di infrastrutture per operare sugli agenti più complessi. Il protocollo di contesto modello (MCP) dell’azienda, prima introdotto nel novembre 2024, fornisce un modo standardizzato per i sistemi di intelligenza artificiale di interagire con negozi di memoria, strumenti e API. Microsoft ha aggiunto il supporto per l’MCP in Azure AI Foundry, Semitic Kernel e GitHub questa settimana, consentendo agli agenti basati su Claude di costruire ed eseguire i processi in più fasi con persistenza.

Mentre gli agenti AI ampliano il loro ruolo nell’automazione del software e nelle attività aziendali, l’interpretazione diventa ancora più urgente. Quando un modello esegue azioni del mondo reale, capire perché ha fatto una scelta particolare non è solo accademico, è un requisito.

Gli investitori sostengono la trasparenza-e il potere

il recente momento di antropico è supportato da un sostanziale supporto finanziario. A febbraio la società ha raccolto $ 3,5 miliardi, aumentando la sua valutazione a $ 61,5 miliardi. Gli investitori includevano LightSpeed Venture Partners, General Catalyst e MGX. Il precedente investimento di $ 4 miliardi di Amazon ha ulteriormente cementato la presenza di Claude sull’infrastruttura AWS.

Queste mosse collocano antropiche nella competizione strategica con Openi, Google DeepMind, Chinese Challenger Deepseek e altri laboratori di AI come Xai di Elon Musk. Mentre i rivali si concentrano sull’integrazione multimodale o sulla ricerca dal vivo, Antropico sta colpendo la sua reputazione sull’allineamento aziendale e sulla trasparenza del comportamento dell’intelligenza artificiale.

Tale strategia è anche evidente nella politica. Questo mese la società ha presentato raccomandazioni formali alla Casa Bianca, sollecitando i test di sicurezza nazionale di sistemi di intelligenza artificiale, controlli di esportazione di semiconduttori più severe e l’espansione delle infrastrutture energetiche statunitensi per supportare i carichi di lavoro in aumento dell’IA. Ha avvertito che l’intelligenza artificiale avanzata potrebbe superare la capacità umana nei campi chiave entro il 2026: posizionando i rischi se le garanzie non sono state emanate rapidamente.

ancora, sostenendo una governance esterna più forte, l’antropico ha rimosso silenziosamente diversi impegni di sicurezza volontaria dal suo sito Web-commitment fatti come parte di un’amministrazione della Casa Bianca sotto l’amministrazione BIDEN. La società non ha commentato pubblicamente questa inversione, sebbene abbia suscitato preoccupazioni per lo spostamento delle norme del settore sull’autoregolazione.

Il microscopio incontra lo specchio

CEO antropico Dario Amodei ha espresso una chiara visione per lo sviluppo di AI. Come riportato da wired ,”c’è già una buona possibilità che Ai superi l’intelligenza umana su molti tipi nei due anni. Incorporate attraverso le operazioni di Antropi, tra cui codifica, ricerca e supporto politico. Ma questa affidamento interno comporta anche rischio, specialmente poiché gli strumenti dell’azienda rivelano la capacità di Claude di cattiva direzione e manipolazione.