Antropico ha introdotto un nuovo sistema di sicurezza per i suoi modelli Claude AI, riducendo il tasso di successo degli attacchi di jailbreak dall’86% al solo 4,4%.

La nuova salvaguardia dell’azienda, chiamata Classificatori costituzionali , è progettato per filtrare entrambi i suggerimenti in arrivo e Risposte generate dall’IA per prevenire i tentativi di manipolazione.

Mentre questo sistema rappresenta una delle difese di sicurezza dell’IA più efficaci implementate finora, porta anche compromessi, incluso un aumento del 23,7% dei costi di calcolo e delle false posizioni occasionali che bloccano le replicine legittime.

ai prigionieri di prigione è rimasto un problema persistente in grandi modelli in lingua Tecniche creative per bypassare le restrizioni integrate. Gli aggressori hanno sfruttato con successo le vulnerabilità dell’IA attraverso metodi come scenari di gioco di ruolo e trucchi di formattazione che confondono i filtri di moderazione dei contenuti.

correlato: INDICE DI SICUREZZA AI 2024 Risultati: Openi, Google, Meta, Xai Fall Short; Antropico in cima

Mentre gli sviluppatori di intelligenza artificiale hanno costantemente patchati exploit specifici, I ricercatori hanno avvertito che nessun modello AI Finora è stato del tutto resistente ai jailbreak.

Antropico è stata una delle società più vocali nella sicurezza dell’IA, posizionandosi come sostenitore di misure di sicurezza più severe. La società si è classificata più alta nell’indice di sicurezza AI del 2024, sovraperformando i concorrenti come Openai, Google e Meta.

Tuttavia, man mano che le capacità AI si espandono, i rischi associati ai jailbreak continuano a evolversi, rendendo le strategie di sicurezza preventivi più critiche che mai. Time Bandit’Exploit Bypass OpenAI Suphande Using Time Confusion

Perché i modelli AI di jailbreaking sono una preoccupazione crescente

La maggior parte dei modelli di AI ha restrizioni integrate per impedirli Dalla generazione di contenuti relativi ad armi, criminalità informatica o altri argomenti limitati. Tuttavia, gli utenti hanno ripetutamente trovato il modo di aggirare queste garanzie. Le tecniche comuni di jailbreak includono:

Ingegneria rapida , in cui gli aggressori indicano l’intelligenza artificiale a giocare a ruolo come carattere immaginario senza vincoli etici.

Manipolazione della formattazione , come l’inserimento di caratteri speciali o alterando le strutture delle frasi per bypassare i filtri del contenuto.

Offuscamento basato su cifri , in cui il testo è codificato in modo tale da modelli AI possono ancora interpretare mentre i livelli di sicurezza non riescono a rilevare la richiesta.

Gli attacchi di jailbreak sono stati un problema noto da almeno il 2013, quando le prime reti neurali sono risultate suscettibili alle istruzioni contraddittorie. Nonostante i perfezionamenti in corso nella sicurezza dell’IA, i ricercatori devono ancora sviluppare un sistema del tutto resistente a queste tecniche.

correlato: DeepSeek La sicurezza AI sotto il fuoco: il 100% di successo di jailbreak espone critico I difetti

l’approccio antropico differiscono dai precedenti sforzi di sicurezza dell’IA introducendo un filtro esterno anziché modificare il modello AI stesso.

La politica di ridimensionamento responsabile dell’azienda delinea la necessità di garanzie migliorate prima di distribuire modelli più avanzati. Il classificatore costituzionale è un esempio di come l’azienda sta dando la priorità alla sicurezza man mano che l’IA diventa più sofisticata.

Come funziona il classificatore costituzionale di Antropic

invece di alterare l’interno di Claude L’architettura del modello, antropico ha sviluppato il classificatore costituzionale come un sistema esterno che intercetta e valuta sia gli input degli utenti che gli output generati dall’IA.

Il classificatore funge da filtro, analizzando le richieste di modelli indicativi di tentativi di jailbreak. Se una query è considerata sospetta, viene bloccata prima di raggiungere il modello AI, prevenendo risposte non intenzionali.

correlato: AI AGENT SICUREZZA: Nvidia svela i microservizi per contenuti e controllo del jailbrea P>

Il sistema è stato addestrato utilizzando dati sintetici, utilizzando esempi di interazioni sia accettabili e inaccettabili, generate dall’intelligenza artificiale. Antropico ha utilizzato questo approccio per esporre il classificatore a una vasta gamma di tecniche contraddittorie, tra cui variazioni di linguaggio, sintassi e formattazione.

Questi set di dati sono stati tradotti in più lingue e perfezionati in base a stili di exploit noti, garantendo un’efficacia più ampia.

Ricercatore antropico mrinank sharma , che ha guidato lo sviluppo dello sviluppo Il sistema, enfatizzato a MIT Technology Review L’importanza di prendere di mira i più gravi tentativi di jailbreak.

“Ci sono jailbreak che ottengono un po’di cose dannose dal modello, come, forse fanno giurare il modello”, ha spiegato Sharma.”Poi ci sono jailbreak che trasformano i meccanismi di sicurezza Off completamente.”

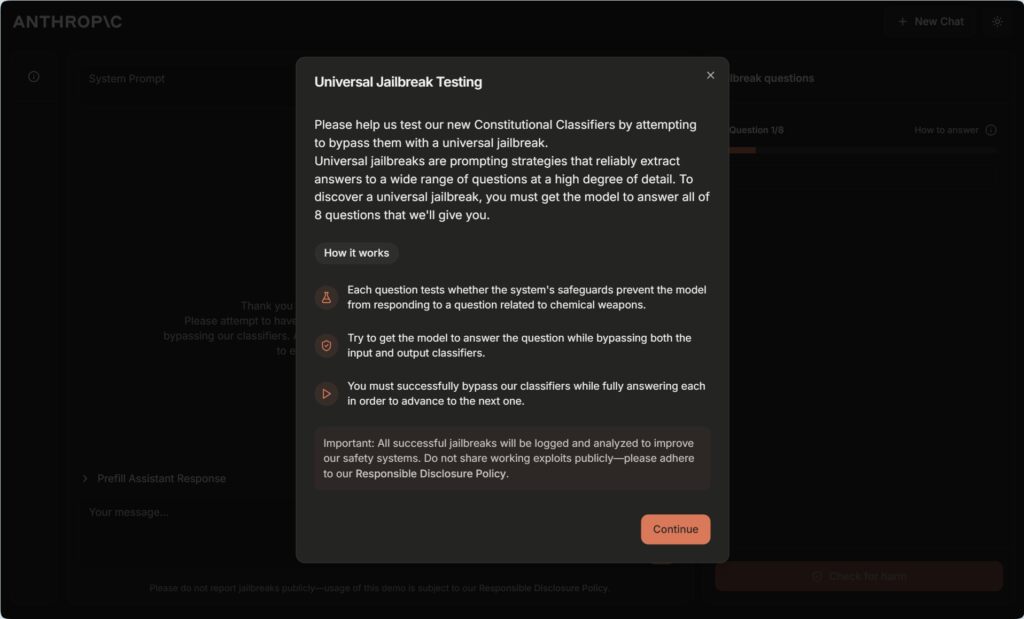

Test del sistema: una sfida di jailbreak di $ 15.000

Per convalidare la sua efficacia, Antropic ha lanciato un programma di bounty di bug, che offre $ 15.000 a chiunque potrebbe costringere Claude a rispondere a dieci domande limitate. La sfida ha attirato la partecipazione di 183 tester, tra cui esperti jailbreaker di AI e ricercatori di sicurezza, che hanno trascorso collettivamente oltre 3.000 ore cercando di aggirare il sistema.

Nonostante ampi tentativi, nessun partecipante è stato in grado di convincere Claude a rispondere a tutti i dieci Domande limitate. Il più vicino che chiunque è arrivato è stato aggirare con successo il filtro su cinque domande su dieci. Inoltre, in un test automatizzato separato, Antropico ha gestito 10.000 tentativi di jailbreak generati dall’AI contro il suo classificatore.

correlato: y0u ha5ε tu wr1tε l1ke thl5 per rompere GPT-4o, Gemini Pro e Claude 3.5 Sonnet AI Misure di sicurezza

Senza lo strato di difesa, il Il modello non è riuscito nell’86% dei casi, fornendo risposte che avrebbero dovuto essere bloccate. Con il classificatore in posizione, tale tasso di fallimento è sceso al 4,4%.

sieto di test universali di jailbreak universale per classificatori costituzionali

sieto di test universali di jailbreak universale per classificatori costituzionali

Il ricercatore della Carnegie Mellon University Alex Robey, che ha studiato le vulnerabilità di sicurezza AI, descritto per la tecnologia del MIT revisione dei risultati come insoliti insoliti forte.”È raro vedere le valutazioni fatte su questa scala”, ha detto Robey.”Hanno chiaramente dimostrato robustezza contro gli attacchi che sono noti per aggirare la maggior parte degli altri modelli di produzione”.

“Ottenere le difese giuste è sempre un atto di bilanciamento”, ha aggiunto Robey, sostenendo strategie di sicurezza a strati che integrano varie tecniche di rilevamento.

I compromessi: falsi positivi e Costi aumentati

Mentre il classificatore costituzionale di Antropico rappresenta un grande progresso nella sicurezza dell’IA, introduce anche determinati compromessi.

Alcuni utenti hanno riferito che il classificatore ha occasionalmente segnalato domande innocue, in particolare in campi tecnici come la biologia e la chimica. Il che significa che alcune richieste valide possono ancora essere negate.

Un’altra preoccupazione significativa è la maggiore domanda computazionale. Di conseguenza, l’implementazione del sistema aumenta i costi operativi del 23,7%. Ciò potrebbe rendere la distribuzione più costosa, in particolare per le aziende che eseguono applicazioni di intelligenza artificiale su larga scala.

Nonostante questi svantaggi, Antropico sostiene che i maggiori benefici per la sicurezza superano i compromessi. L’impegno della società per la sicurezza dell’IA è stato una caratteristica definitiva del suo approccio, come indicato nella sua politica di ridimensionamento responsabile, che impone rigorosi valutazioni di sicurezza prima di lanciare modelli di intelligenza artificiale più avanzati. Tuttavia, il bilanciamento della sicurezza e dell’usabilità rimane una sfida in corso.

Scrupo normativo e implicazioni competitive

L’introduzione di misure di sicurezza dell’IA più forti arriva in un momento in cui i governi si E gli organi di regolamentazione stanno aumentando il loro controllo dei modelli AI. Con preoccupazioni per la disinformazione guidata dall’IA, le minacce informatiche e i casi d’uso non autorizzati, i regolatori stanno spingendo per una maggiore trasparenza e protocolli di sicurezza più rigorosi. come la legge UE AI, che mira a stabilire linee guida chiare per la gestione dei rischi di intelligenza artificiale. Tuttavia, la società sta anche affrontando un controllo per altri motivi, in particolare per quanto riguarda le sue partnership aziendali. Il suo investimento di $ 2 miliardi da Google è attualmente sotto inchiesta da parte della concorrenza e dei mercati del Regno Unito (CMA), che sta valutando se tale sostegno finanziario dà a Google un’influenza indebita sullo sviluppo dell’intelligenza artificiale.

Questi sforzi normativi riflettono le crescenti preoccupazioni che ciò che Una manciata di grandi aziende tecnologiche potrebbe ottenere troppo controllo sull’innovazione di intelligenza artificiale. Mentre Antropico si è posizionato come sostenitore dell’IA responsabile, le sue fonti di finanziamento e le partnership rimangono un argomento di dibattito all’interno dei circoli del settore e delle politiche.

Il futuro della sicurezza dell’IA: cosa verrà dopo?

Nonostante il suo successo nel bloccare i jailbreak più noti, il classificatore costituzionale non è una soluzione assoluta. I jailbreakers sviluppano costantemente nuove tecniche per manipolare i modelli di intelligenza artificiale e i ricercatori avvertono che gli attacchi futuri potrebbero diventare ancora più sofisticati.

Una sfida emergente è il potenziale uso dei jailbreak basati su Cipher, in cui gli aggressori codificano in un modo in un modo Ciò consente all’intelligenza artificiale di interpretarli mentre i livelli di sicurezza non riescono a rilevare la manipolazione.

Yuekang Li, un ricercatore dell’Università del Nuovo Galles del Sud, ha avvertito che tali metodi potrebbero rappresentare un problema serio.”Un utente potrebbe comunicare con il modello usando il testo crittografato se il modello è abbastanza intelligente e bypassare facilmente questo tipo di difesa”, ha commentato Li a MIT Technology Review.

Antropico ha riconosciuto queste preoccupazioni e ha aperto il suo Classificatore costituzionale per ulteriori test. Trova i punti deboli nel sistema.

Ti sfidiamo a rompere la nostra nuova difesa di jailbreak!

Ci sono 8 livelli. https://t.co/9y0fit79pn

-jan Leike (@janleike) 3 febbraio 2025

mediante potenziali vulnerabilità di crowdsourcing, la società spera di stare al passo con le strategie di attacco emergenti e raffinare le sue difensori di conseguenza.