I ricercatori di Google hanno introdotto un nuovo framework chiamato Chain-of-Agents (CoA), progettato per affrontare uno dei limiti più persistenti dei modelli linguistici di grandi dimensioni (LLM): la gestione di attività a lungo contesto.

CoA utilizza un modello di collaborazione multi-agente per migliorare significativamente l’efficienza e l’accuratezza del ragionamento in attività come il riepilogo, la risposta alle domande e il completamento del codice.

Dividendo gli input lunghi in input più piccoli e gestibili blocchi e assegnandoli ad agenti specializzati, il framework fornisce risultati migliori rispetto agli approcci tradizionali come i modelli Retrieval-Augmented Generation (RAG) e Full-Context.

Correlato: Google svela Agentspace per sfidare il crescente ecosistema di intelligenza artificiale di Microsoft

Il framework CoA offre un cambio di paradigma per l’intelligenza artificiale, in particolare in la sua capacità di elaborare input estesi che altrimenti supererebbero i limiti dei LLM. Google ha sottolineato la semplicità e l’efficacia dell’approccio, descrivendolo come”privo di formazione, indipendente da attività/lunghezza, interpretabile ed economicamente vantaggioso”.

Le sfide delle attività di intelligenza artificiale a lungo contesto

Uno dei principali ostacoli al progresso delle capacità di intelligenza artificiale risiede nella gestione di input a contesto lungo. La maggior parte dei LLM opera con una finestra di contesto fissa che limita la loro capacità di elaborare set di dati di grandi dimensioni senza troncamento

I metodi di riduzione dell’input, come RAG, tentano di superare questo problema recuperando solo le parti più rilevanti dell’input. Tuttavia, questo approccio spesso soffre di una bassa precisione di recupero, portando a informazioni incomplete strong>Correlato: NVIDIA migliora l’intelligenza artificiale con i modelli Llama e Cosmos Nemotron

D’altro canto, i modelli Full-Context estendono la loro capacità di elaborazione ma devono affrontare inefficienze computazionali, in particolare perché la lunghezza dell’input aumenta. Questi modelli spesso incontrano il problema”lost-in-the-middle”, in cui le informazioni critiche nel mezzo del set di dati hanno una priorità ridotta.

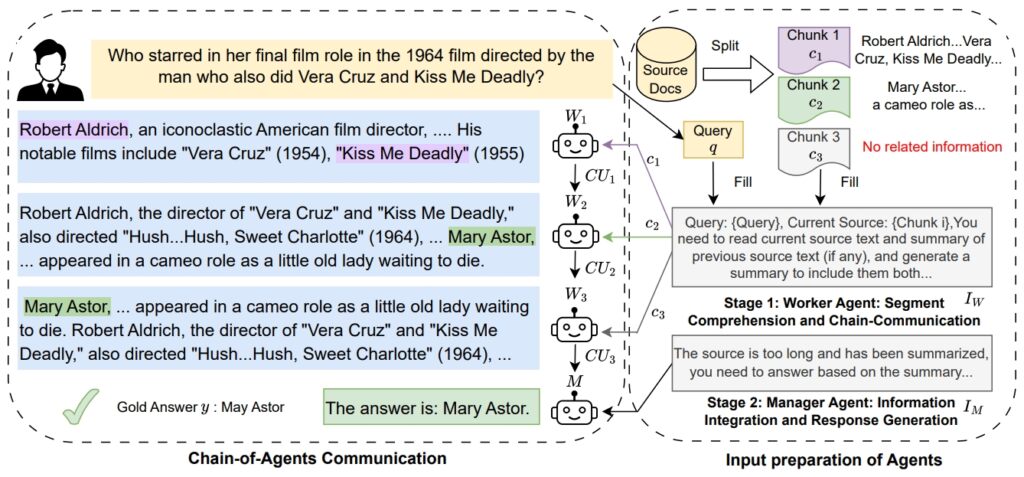

Il framework CoA di Google affronta questi problemi sfruttando un approccio collaborativo. sistema in cui gli agenti lavoratori elaborano segmenti specifici dell’input in sequenza. Ogni agente lavoratore perfeziona e trasferisce i propri risultati al successivo, garantendo che nessun contesto venga perso.

Un agente manager sintetizza quindi tutte le informazioni raccolte per produrre una risposta finale. Questo approccio graduale imita la risoluzione dei problemi umana, in cui le attività vengono suddivise in parti più piccole per una migliore concentrazione e precisione.

Immagine: Google

Immagine: Google

I ricercatori di Google hanno evidenziato motivazione alla base del quadro, affermando:”Quando la finestra diventa più lunga anche delle loro capacità di input estese, tali LLM faticano ancora a concentrarsi sulle informazioni necessarie per risolvere il compito e soffrono di un utilizzo inefficace del contesto come il problema”perso nel mezzo”.”

Come funziona la catena degli agenti

La struttura della catena degli agenti opera in due fasi distinte. Nella prima fase, gli agenti lavoratori elaborare blocchi di input assegnati, eseguendo attività come estrarre prove a sostegno o inoltrare risultati rilevanti.

Questa catena di comunicazione garantisce che ciascun lavoratore si basi sulle intuizioni della precedente. Nella seconda fase, l’agente manager aggrega tutte le prove raccolte e genera un finale coerente produzione. Questa struttura gerarchica non solo migliora la precisione del ragionamento, ma riduce anche i costi computazionali.

Correlato: Salesforce presenta Agentforce 2.0, espansione degli agenti AI oltre il CRM

Google ha spiegato il struttura del framework come”interlacciamento di lettura e ragionamento, assegnando a ciascun agente un breve contesto”. Questo approccio consente a CoA di gestire contesti lunghi senza richiedere ai LLM di elaborare tutti i token simultaneamente.

Di riducendo la complessità computazionale, CoA offre una soluzione più efficiente e scalabile per attività a lungo contesto.

Prestazioni superiori rispetto ai benchmark

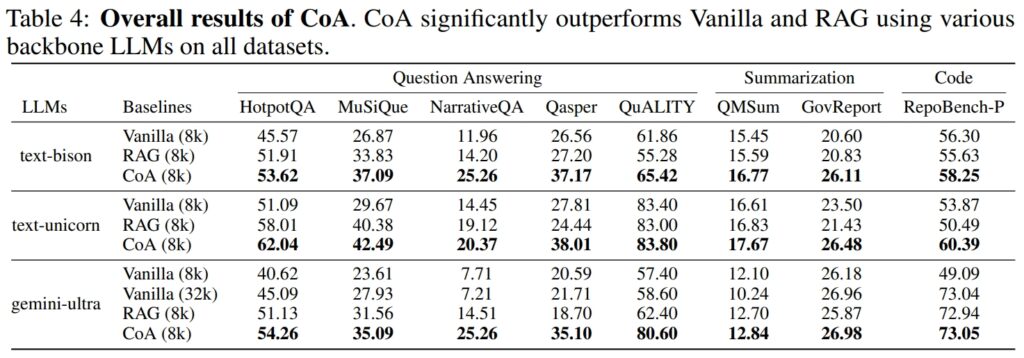

Google ha condotto esperimenti approfonditi su nove set di dati per valutare le prestazioni di CoA. Questi set di dati abbracciavano vari domini, tra cui la risposta alle domande (ad esempio, HotpotQA, MuSiQue), il riepilogo (ad esempio, QMSum, GovReport) e. completamento del codice (ad esempio, RepoBench-P).

CoA ha costantemente sovraperformato i modelli RAG e Full-Context in termini di precisione ed efficienza.

Fonte: Google

Fonte: Google

Ad esempio, sul set di dati HotpotQA, CoA eccelleva nel ragionamento multi-hop, un’attività che richiede la sintesi di informazioni da più fonti per arrivare ad una risposta accurata.

Mentre RAG spesso non riusciva a collegare informazioni semanticamente disgiunte ma contestualmente rilevanti, CoA metteva insieme sistematicamente informazioni dettagliate da ogni blocco di input. Google ha osservato:”I nostri risultati mostrano che su tutti e nove i set di dati, CoA ottiene un miglioramento fino al 10% rispetto a tutti i valori di riferimento.”

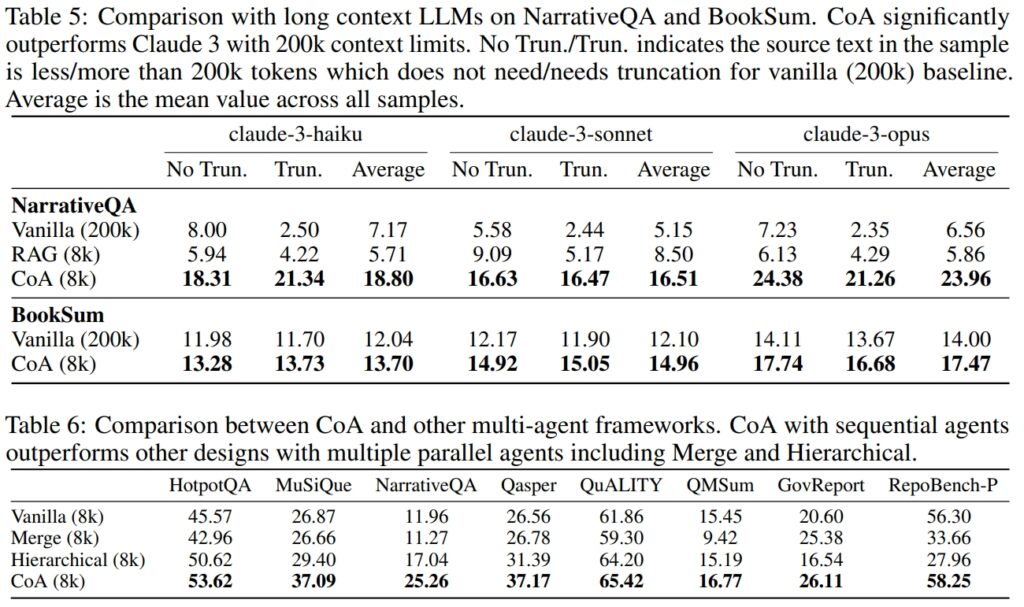

Sul set di dati NarrativeQA, CoA ha dimostrato la sua capacità di sovraperformare i modelli Full-Context, anche quelli in grado di gestire 200.000 token Limitando la finestra di contesto a 8.000 token e utilizzando il suo approccio multi-agente, CoA ha mantenuto prestazioni elevate riducendo significativamente i costi computazionali.

Fonte: Google

Fonte: Google

Applicazioni in scenari reali

Le applicazioni pratiche della CoA si estendono a più settori. Nell’analisi legale, la CoA può elaborare documenti legali estesi e identificare informazioni critiche senza perdere i dettagli chiave. Nel settore sanitario, il quadro potrebbe aggregare le cartelle cliniche dei pazienti provenienti da varie fonti per fornire approfondimenti diagnostici completi.

Le istituzioni accademiche e governative potrebbero utilizzare CoA per il riepilogo della ricerca, sintetizzando i risultati da set di dati di grandi dimensioni.

La capacità di CoA di gestire attività di completamento del codice evidenzia anche il suo potenziale nello sviluppo di software. Analizzando basi di codici di grandi dimensioni e identificando le dipendenze, il framework può ottimizzare i flussi di lavoro per gli sviluppatori che lavorano con sistemi complessi.

Correlato: Cognition.ai lancia il suo Devin AI Software Engineer per $ 500 al mese

Confronti con i concorrenti del settore

L’introduzione del CoA da parte di Google riflette una crescente enfasi sui singoli agenti IA e sui framework collaborativi degli agenti IA all’interno del settore tecnologico. OpenAI ha appena lanciato Operator, un agente AI basato su browser progettato per l’automazione delle attività, mentre Microsoft ha presentato AutoGen v0.4 con il framework Magentic-One per flussi di lavoro multi-agente.

Il CoA di Google si distingue concentrandosi specificamente sul ragionamento a lungo contesto e sull’elaborazione delle attività.

Secondo i ricercatori di Google, i LLM spesso ricevono un contesto incompleto a causa delle limitazioni dei metodi tradizionali, ma il CoA risolve questo problema elaborando l’intero input in modo collaborativo attraverso più agenti.

Questa attenzione alle attività a lungo contesto conferisce a CoA un vantaggio unico nelle aree che richiedono un’ampia sintesi di informazioni.

A Uno sguardo al futuro dell’intelligenza artificiale

L’introduzione del CoA evidenzia una tendenza più ampia nello sviluppo dell’intelligenza artificiale verso sistemi modulari e collaborativi. Consentendo ad agenti specializzati di lavorare insieme, CoA dimostra come la divisione dei compiti possa migliorare la precisione e la scalabilità.

Il quadro potrebbe aprire la strada ai progressi nell’intelligenza generale artificiale (AGI), dove i sistemi sono capaci di ragionamento e risoluzione dei problemi a livello umano.

Gli sforzi di Google sottolineano anche l’importanza di soluzioni convenienti e interpretabili nell’intelligenza artificiale aziendale.