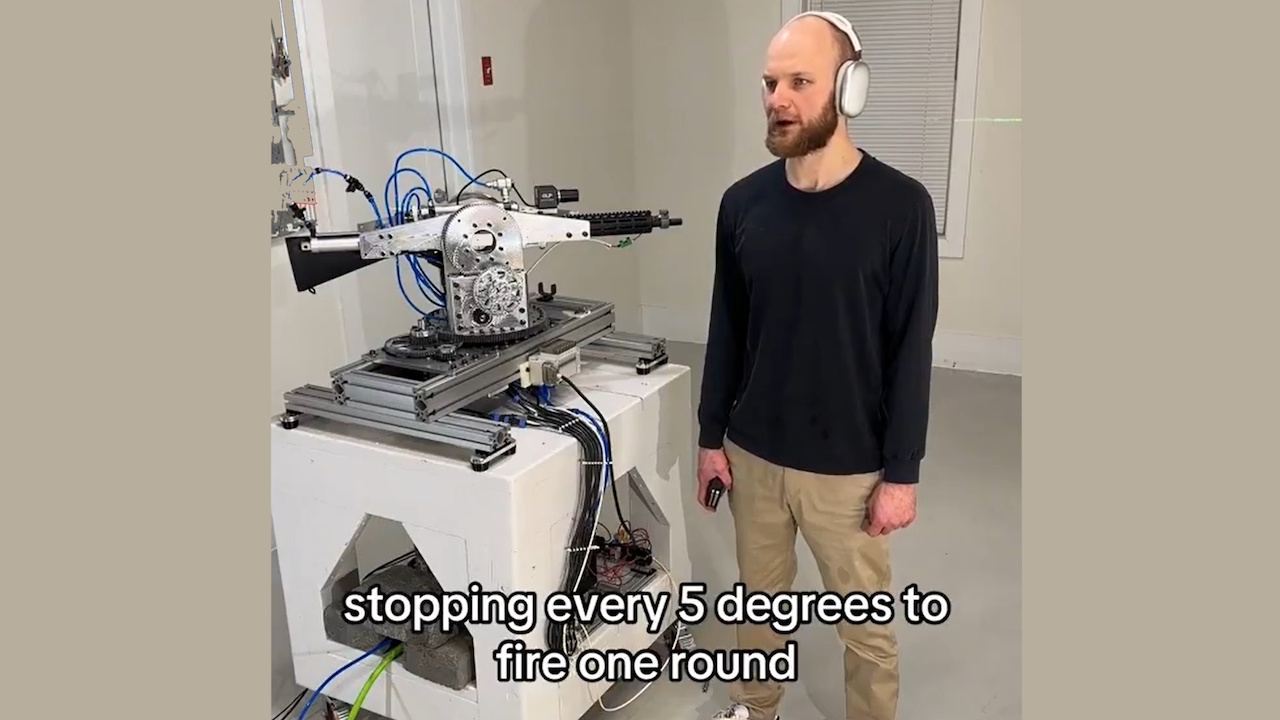

OpenAI ha revocato l’accesso API a uno sviluppatore che utilizzava la sua API Realtime per alimentare un sistema di fucili autonomo. Il progetto, che prevedeva una torretta robotica dotata di fucile, poteva interpretare comandi verbali ed eseguire azioni di fuoco simulate.

L’incidente sottolinea le crescenti preoccupazioni circa il potenziale uso improprio dell’intelligenza artificiale nello sviluppo di armi autonome, sollevando interrogativi sull’etica e sulla sicurezza dell’IA.

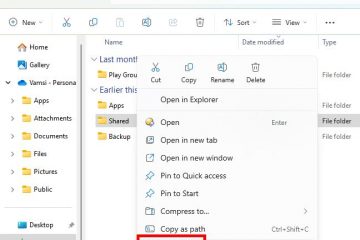

Lo sviluppatore, noto online come “STS Innovations LLC,” ha condiviso video online del sistema, dimostrandone la funzionalità. In una clip, lo sviluppatore ha emesso il comando:”ChatGPT, siamo sotto attacco dalla parte anteriore sinistra e anteriore destra”, al quale la torretta ha risposto immediatamente, ruotando e sparando a salve nelle direzioni specificate.

Simulazione di mira/fuoco con laser #robotica #elettronica

Una voce sintetizzata ha aggiunto:”Se hai bisogno di ulteriore assistenza, fammelo sapere”. L’agghiacciante dimostrazione ha evidenziato come gli strumenti di intelligenza artificiale di livello consumer possano essere facilmente adattati per usi potenzialmente dannosi.

Aggiornamento sul sistema di tracciamento #robotica #vision #electronics

Swift Policy Enforcement di OpenAI

OpenAI, nota per le sue rigide politiche contro l’uso della sua tecnologia nell’armamento, ha risposto tempestivamente. Un portavoce ha detto a Futurism:”Abbiamo identificato in modo proattivo questa violazione delle nostre politiche e notificato allo sviluppatore di interrompere questa attività prima di ricevere la tua richiesta.”

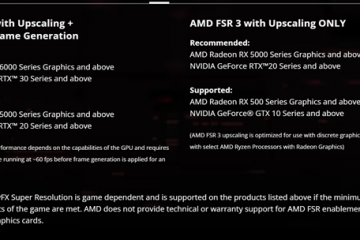

L’azienda ha sottolineato il divieto di utilizzare i propri strumenti per creare o utilizzare armi o automatizzare sistemi che potrebbero comportare rischi per la sicurezza personale.

Sistema di gestione del rinculo, demo rapida #robotica #elettronica #cnc

L’API Realtime, uno strumento progettato per applicazioni interattive, hanno permesso allo sviluppatore di trasformare i comandi del linguaggio naturale in input utilizzabili per la torretta robotica.

Sebbene l’API sia destinata a casi d’uso vantaggiosi, come il miglioramento dell’accessibilità o delle interazioni con i clienti, questo uso improprio dimostra le sfide legate alla regolamentazione delle tecnologie a duplice uso.

Correlati: Partnership tra OpenAI e Anduril Forge per la difesa dei droni militari statunitensi

Implicazioni più ampie per l’intelligenza artificiale e l’armamento

Questo caso ha riacceso i dibattiti sulla etica delle armi autonome. Questi sistemi, in grado di selezionare e coinvolgere obiettivi senza la supervisione umana, pongono complesse sfide legali e morali.

Le Nazioni Unite sostengono da tempo norme più severe sull’intelligenza artificiale in guerra, avvertendo che i sistemi autonomi potrebbero violare le leggi internazionali e ridurre la responsabilità.

Correlato: Antropico Collabora con Palantir, AWS per l’intelligenza artificiale nell’intelligence e nell’esercito degli Stati Uniti

Un rapporto del Washington Post recentemente ha dettagliato esempi preoccupanti di implementazione dell’IA in ambito militare operazioni, comprese le affermazioni secondo cui Israele avrebbe utilizzato l’intelligenza artificiale per selezionare gli obiettivi dei bombardamenti.

Il rapporto osserva:”In certi momenti, l’unica conferma richiesta era che l’obiettivo fosse un maschio.”Tali casi evidenziano i rischi di fare affidamento sull’intelligenza artificiale nelle decisioni di vita o di morte e il potenziale di comportamenti indiscriminati. violenza.

Correlati: Il berretto verde ha utilizzato ChatGPT per l’esplosione di un cybertruck, la polizia pubblica i registri delle chat

Il ruolo di OpenAI nella difesa Tecnologie

Mentre OpenAI applica politiche che vietano l’uso di armi, la sua partnership con Anduril Industries, un’azienda specializzata in soluzioni di difesa basate sull’intelligenza artificiale, solleva interrogativi sulla sua posizione.

La collaborazione mira a migliorare l’intelligence sul campo di battaglia e a migliorare i sistemi di difesa dei droni. OpenAI descrive questi sforzi come difensivi, ma i critici sostengono che contribuiscono a una più ampia militarizzazione delle tecnologie di intelligenza artificiale.

Il settore della difesa statunitense, sostenuto da un budget annuale prossimo. 1 trilione di dollari, fa sempre più affidamento su tecnologie avanzate per ottenere un vantaggio strategico. Questa crescente intersezione tra aziende di intelligenza artificiale e applicazioni militari evidenzia le sfide legate al bilanciamento dell’innovazione tecnologica con considerazioni etiche.

Correlati: Il nuovo consorzio Palantir-Anduril AI per affrontare le lacune dei dati sulla difesa degli Stati Uniti

Armi fai-da-te e rischi per l’accessibilità

La facilità con cui gli individui possono utilizzare in modo improprio gli strumenti di intelligenza artificiale e altre tecnologie come la stampa 3D aggrava il problema. Le forze dell’ordine hanno già riscontrato casi di utilizzo di armi fai-da-te, come le presunte azioni di Luigi Mangione, che secondo quanto riferito, ha utilizzato parti stampate in 3D per assemblare armi da fuoco. Queste tecnologie riducono le barriere che impediscono agli individui di creare sistemi autonomi con potenziale letale.

Il progetto di STS 3D dimostra come gli strumenti di intelligenza artificiale accessibili possano essere adattati per scopi non desiderati. L’azione decisiva di OpenAI in questo caso dimostra il suo impegno nel prevenire gli abusi, ma sottolinea anche la difficoltà di controllare completamente il modo in cui le sue tecnologie vengono implementate una volta che diventano di dominio pubblico.

L’incidente solleva domande più ampie sulla governance di Tecnologie di intelligenza artificiale. I sostenitori della regolamentazione sottolineano la necessità di standard globali chiari per garantire che lo sviluppo dell’intelligenza artificiale sia in linea con i principi etici. Tuttavia, raggiungere il consenso tra nazioni con interessi e priorità diversi rimane un compito arduo.