OpenAI ha ampliato la propria offerta per gli sviluppatori lanciando la versione completa del suo modello o1 tramite la sua API. Questo modello di ragionamento avanzato, che eccelle in attività complesse in più fasi, introduce nuove funzionalità che promettono di rimodellare il modo in cui gli sviluppatori creano applicazioni basate sull’intelligenza artificiale.

L’aggiornamento fa parte della serie di annunci”12 Days of OpenAI”, in cui l’azienda rilascia nuove funzionalità e aggiornamenti per i suoi prodotti principali.

Oltre al modello o1, OpenAI ha ha inoltre annunciato miglioramenti alla sua API Realtime per le interazioni vocali e un nuovo metodo di regolazione delle preferenze, offrendo agli sviluppatori una flessibilità senza precedenti.

Il modello o1-2024-12-17 sostituisce la versione o1-preview lanciata all’inizio di quest’anno. Secondo OpenAI, il modello aggiornato offre”un’interfaccia più completa e risposte accurate, in particolare per domande relative alla programmazione e al business, ed è meno probabile che rifiuti erroneamente le richieste.”

Questi miglioramenti, insieme a una riduzione del 60% nell’utilizzo dei token di ragionamento, rendono il modello o1 più veloce, più efficiente e più versatile.

[contenuto incorporato]

Ragionamento avanzato tramite API con il modello o1

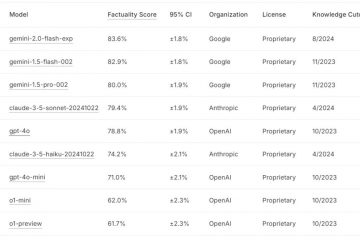

Il modello o1 di OpenAI è progettato per affrontare attività che richiedono coerenza logica e profondità analitica, superando le iterazioni precedenti su benchmark come SWE-Bench verificato e AIME.

OpenAI riferisce che la precisione per le attività di programmazione è aumentata dal 52,3% al 76,6%, mentre le prestazioni sui problemi matematici sono aumentate dal 42% a quasi l’80%.

Fonte: OpenAI

Una caratteristica straordinaria è il supporto dell’output strutturato, che consente agli sviluppatori di generare risposte in formati predefiniti come JSON.

Ciò garantisce una perfetta integrazione con sistemi esterni come API e database, rendendo il modello ideale per applicazioni nell’assistenza clienti, nella logistica e nell’analisi dei dati.

Il modello introduce anche funzionalità di ragionamento visivo, consentendo l’analisi delle immagini per attività come il debug o la ricerca scientifica. Ad esempio, gli sviluppatori possono ora inserire dati visivi, come documenti o progetti scansionati, e ricevere risposte sensibili al contesto.

Inoltre, un nuovo parametro”sforzo di ragionamento”consente agli sviluppatori di controllare quanto tempo il modello impiega su ciascuna attività, bilanciando precisione ed efficienza.

OpenAI ha spiegato nel suo blog:”Stiamo rotolando fornire l’accesso in modo incrementale mentre si lavora per espandere l’accesso a livelli di utilizzo aggiuntivi e aumentare i limiti di velocità.”

Miglioramento delle interazioni vocali con l’API Realtime

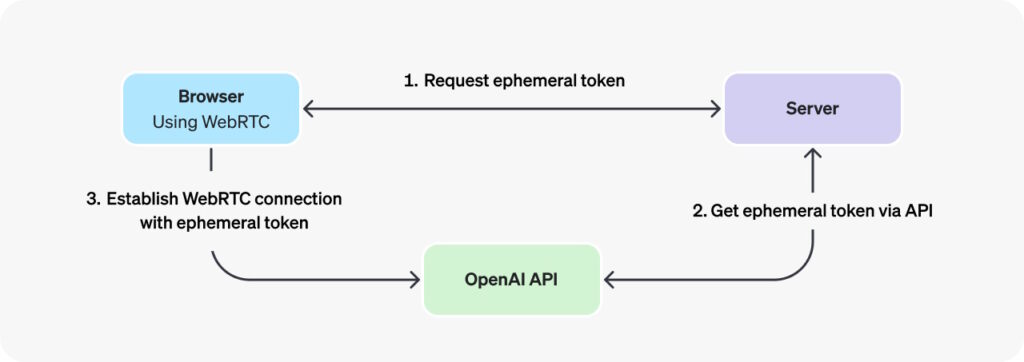

OpenAI ha inoltre ottenuto risultati significativi aggiornamenti al suo API in tempo reale, che alimenta le interazioni vocali in tempo reale. L’aggiunta di WebRTC, Web Real-Time Communication, un protocollo per la comunicazione a bassa latenza, consente agli sviluppatori di creare applicazioni vocali fluide per tutor virtuali, assistenti e strumenti di traduzione. Abilita connessioni peer-to-peer (P2P) senza richiedere plug-in o software aggiuntivi.

OpenAI ha evidenziato i vantaggi di WebRTC, affermando:”Negli scenari in cui desideri connetterti a un modello Realtime da un client non sicuro sulla rete (come un browser Web), ti consigliamo di utilizzare il metodo di connessione WebRTC. WebRTC è meglio attrezzato per gestire stati di connessione variabili e fornisce una serie di comode API per acquisire input audio dell’utente e riprodurre flussi audio remoti dal modello.“

L’implementazione di WebRTC utilizza i cosiddetti token effimeri, chiavi API temporanee progettate specificamente per l’autenticazione sicura delle applicazioni lato client durante la connessione all’API OpenAI Realtime su WebRTC. Il loro scopo è garantire un meccanismo di autenticazione sicuro e di breve durata che eviti di esporre chiavi API standard sensibili direttamente in ambienti client come i browser Web.

Immagine: OpenAI

Immagine: OpenAI

Gli aggiornamenti all’API Realtime semplificano il processo di sviluppo, riducendo il codice richiesto per le applicazioni vocali e migliorando al tempo stesso la qualità audio e la precisione della risposta. Gli sviluppatori possono ora creare applicazioni che iniziano a formulare risposte mentre gli utenti stanno ancora parlando, migliorando la reattività.

Le modifiche ai prezzi rendono le applicazioni vocali più accessibili. Il costo dei token audio GPT-4o è stato ridotto del 60%, mentre i token di input memorizzati nella cache sono ora più economici dell’87,5%. OpenAI ha anche introdotto GPT-4o mini, un’opzione conveniente per gli sviluppatori che cercano alternative convenienti, al prezzo di $ 10 per milione di token di input.

Perfezionamento del comportamento dell’IA con la messa a punto delle preferenze

La regolazione fine delle preferenze è un nuovo metodo di personalizzazione che consente agli sviluppatori di perfezionare il comportamento del modello in base al confronto accoppiato delle risposte. A differenza della regolazione fine tradizionale, che si basa su esatte coppie input-output, la regolazione fine delle preferenze insegna al modello a distinguere tra risposte preferite e meno desiderabili.

OpenAI descrive questo metodo come particolarmente efficace per compiti soggettivi, come come personalizzare il tono e lo stile nella scrittura creativa o garantire il rispetto di specifici requisiti di formattazione. Secondo OpenAI, i primi utilizzatori, come una società di analisi finanziaria, hanno riferito che la regolazione fine delle preferenze ha migliorato l’accuratezza della risposta del 5% per query complesse e fuori distribuzione.

“Abbiamo iniziato a testare la regolazione fine delle preferenze con partner fidati che finora hanno visto risultati promettenti. Ad esempio, Rogo AI(opens in a new window) sta creando un assistente AI per analisti finanziari che suddivide le query complesse in sottoquery.

Utilizzando il loro benchmark creato da esperti, Rogo-Golden, hanno scoperto che mentre il Supervised Fine Tuning affrontava sfide con l’espansione delle query fuori distribuzione, come la mancanza di metriche come ARR per domande come”quanto è veloce?”azienda X in crescita”—Preference Fine Tuning ha risolto questi problemi, migliorando le prestazioni dal 75% di precisione del modello base a oltre l’80%.”

Espansione delle opzioni SDK per Sviluppatori

Per supportare una gamma più ampia di ambienti di programmazione, OpenAI ha anche introdotto SDK ufficiali per Vai e Java, insieme a s librerie esistenti per Python, Node.js e.NET. Questi SDK semplificano l’integrazione, consentendo agli sviluppatori di distribuire modelli di intelligenza artificiale in sistemi backend scalabili o aziende applicazioni.

Go SDK è progettato per applicazioni lato server leggere ed efficienti, mentre Java SDK si rivolge a soluzioni di livello aziendale, offrendo una digitazione forte e un supporto solido per progetti su larga scala. La documentazione di OpenAI fornisce una guida dettagliata per sfruttare questi nuovi strumenti.

Annunci precedenti durante i”12 giorni di OpenAI”

Il 16 dicembre, OpenAI ha realizzato il suo ChatGPT funzionalità di ricerca web in tempo reale disponibile per tutti gli utenti, che consente a chiunque di recuperare informazioni aggiornate direttamente dal Web.

Il 14 dicembre ha introdotto nuove opzioni di personalizzazione su ChatGPT, consentendo agli utenti di semplificare le attività e gestire i progetti in modo efficace. Projects consente agli utenti di raggruppare chat, file e istruzioni personalizzate in cartelle dedicate, creando uno spazio di lavoro organizzato per la gestione di attività e flussi di lavoro.

Come enorme miglioramento della modalità vocale avanzata per ChatGPT, OpenAI il 12 dicembre ha aggiunto funzionalità di visione, consentendo agli utenti di condividere video e schermate in tempo reale per analisi e assistenza in tempo reale.

L’11 dicembre, OpenAI ha rilasciato completamente Canvas, uno spazio di lavoro di editing collaborativo che offre strumenti avanzati per Perfezionamento sia del testo che del codice Lanciato inizialmente in versione beta nell’ottobre 2024, Canvas sostituisce l’interfaccia standard di ChatGPT con un design a schermo diviso, consentendo agli utenti di lavorare su testo o codice mentre sono impegnati in scambi conversazionali con l’intelligenza artificiale.

L’aggiunta dell’esecuzione Python è una caratteristica distintiva di Canvas, che consente agli sviluppatori di scrivere, testare ed eseguire il debug di script direttamente all’interno della piattaforma. OpenAI ha dimostrato la sua utilità durante un evento dal vivo utilizzando Python per generare e perfezionare le visualizzazioni dei dati. OpenAI ha descritto la funzionalità come”ridurre l’attrito tra la generazione di idee e l’implementazione”.

Il 9 dicembre, OpenAI ha lanciato ufficialmente Sora, il suo strumento avanzato di intelligenza artificiale per generare video da messaggi di testo, segnalando una nuova era per l’intelligenza artificiale creativa. Integrato negli account ChatGPT a pagamento, Sora consente agli utenti di animare immagini fisse, estendere video esistenti e unire scene in narrazioni coerenti.

Rilasciato il 7 dicembre è stato Reinforcement Fine-Tuning come nuovo framework progettato per consentire la personalizzazione dei modelli di intelligenza artificiale per applicazioni specifiche del settore. È l’ultimo approccio di OpenAI al miglioramento dei modelli di intelligenza artificiale addestrandoli con set di dati e sistemi di valutazione forniti dagli sviluppatori, a differenza dell’apprendimento supervisionato tradizionale, che si concentra sulla replica dei risultati desiderati.

Il 5 dicembre, OpenAI ha presentato ChatGPT Pro, un nuovo livello di abbonamento premium al prezzo di $ 200 al mese, rivolto a professionisti e aziende che cercano funzionalità IA avanzate per le richieste più elevate flussi di lavoro.