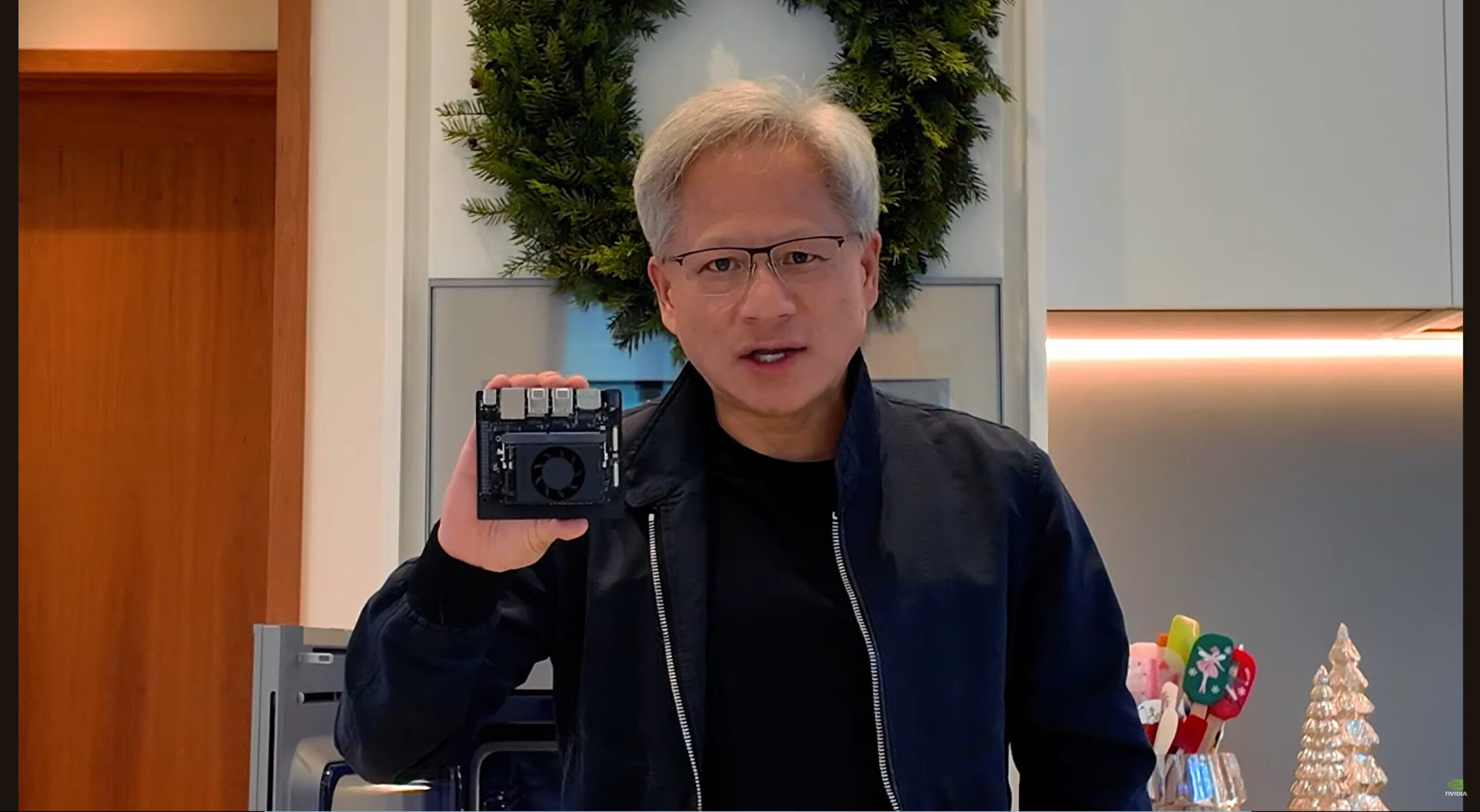

Nvidia ha introdotto Jetson Orin Nano Super Developer Kit, una piattaforma AI ad alte prestazioni che offre un aumento del 70% nella velocità di inferenza dell’IA generativa raddoppiando la larghezza di banda della memoria rispetto al suo predecessore.

Prezzo di $ 249, il kit offre a sviluppatori, ricercatori e studenti uno strumento conveniente per creare e distribuire applicazioni IA avanzate all’edge.

Il super Developer Kit NVIDIA Jetson Orin Nano è un edge compatto Scheda AI progettata per la creazione di dispositivi entry-level basati sull’intelligenza artificiale come robot, droni e fotocamere intelligenti.

È la combinazione di prestazioni hardware migliorate e ottimizzazioni software retrocompatibili lo posiziona come una soluzione interessante per robotica, visione artificiale e carichi di lavoro di intelligenza artificiale generativa in tempo reale, aree in cui la potenza computazionale deve incontrare energia e spazio vincoli.

Confronto della configurazione del Jetson Orin Nano Super Developer Kit

Incrementi di prestazioni IA convenienti per l’edge computing

Jetson Orin Nano Super si basa sull’architettura GPU Ampere di Nvidia, che ha è stata una pietra angolare delle sue offerte di intelligenza artificiale nei data center, nel cloud e ora nell’edge computing. Il kit per sviluppatori include il System-on-Module (SoM) Jetson Orin Nano da 8 GB e offre una maggiore efficienza per attività come modelli basati su trasformatori, modelli linguistici e simulazioni di robotica.

Nvidia segnala un aumento di 1,7 volte nell’inferenza dell’intelligenza artificiale generativa prestazioni, rese possibili dagli aggiornamenti hardware e dall’ottimizzazione del software. In particolare, il nuovo sistema raggiunge prestazioni di elaborazione sparse di 67 TOPS (trilioni di operazioni al secondo), rispetto ai 40 TOPS della precedente serie Orin Nano, e aumenta la larghezza di banda della memoria a 102 GB/s, un salto significativo rispetto ai precedenti 68 GB/s./p>

Secondo Nvidia, il kit di sviluppo mantiene lo stesso fattore di forma compatto offrendo allo stesso tempo una maggiore efficienza. Deepu Talla, vicepresidente Embedded and Edge Computing di Nvidia, ha notato l’impatto dell’aggiornamento, affermando:”È come se avessimo preso Orin Nano e gli avessimo dato un mantello da supereroe.”

Questi miglioramenti consentono agli sviluppatori di gestire l’intelligenza artificiale attività precedentemente limitate ai sistemi cloud, come l’esecuzione di modelli di linguaggio di grandi dimensioni (LLM) compatti come Llama-3.1 e Gemma-2 Consentendo l’esecuzione locale di modelli più piccoli e ottimizzati, Jetson Orin Nano Super riduce la dipendenza dalle risorse cloud e dalla latenza, fondamentali per la robotica, le macchine autonome e altre applicazioni in tempo reale.

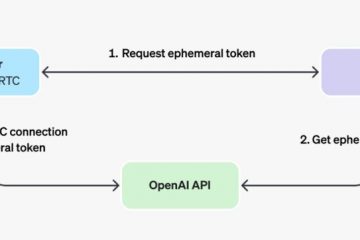

[contenuto incorporato]

Gli aggiornamenti software estendono i miglioramenti delle prestazioni ai dispositivi esistenti

Oltre al rilascio dell’hardware, Nvidia ha introdotto un aggiornamento JetPack SDK che avvantaggia l’intera famiglia Jetson Orin, inclusi i vecchi modelli Orin Nano e NX. Questo aggiornamento sblocca la Super Mode, un’impostazione più potente che aumenta le frequenze di clock della GPU e della CPU per migliorare le prestazioni.

Gli sviluppatori possono attivare la Super Mode utilizzando Nvidia. Strumento di selezione della modalità di alimentazione, accessibile tramite la riga di comando o l’interfaccia grafica. Con questa funzionalità, l’hardware esistente può ottenere miglioramenti prestazionali simili a Jetson Orin Nano Super senza investimenti aggiuntivi.

Garantindo la parità software in tutta la linea Orin, Nvidia massimizza il ciclo di vita e il valore delle sue piattaforme AI edge, rendendole rende più semplice per gli sviluppatori scalare i propri progetti.

Applicazioni del mondo reale: robotica, modelli visivi e intelligenza artificiale generativa

Jetson Orin di Nvidia Nano Super è progettato appositamente per le applicazioni edge che richiedono un’elaborazione IA efficiente. Le principali aree di interesse includono robotica, visione artificiale e intelligenza artificiale generativa:

Nella robotica, Nvidia La piattaforma Isaac offre strumenti di simulazione e generazione di dati sintetici per accelerare lo sviluppo. Ad esempio, Isaac Sim consente agli sviluppatori di prototipare sistemi robotici in ambienti virtuali prima di implementarli nel mondo reale. Allo stesso modo, Omniverse Replicator di Nvidia facilita la creazione di dati sintetici di alta qualità per l’addestramento di modelli di intelligenza artificiale.

Per la visione artificiale, Jetson Orin Nano Super supporta modelli basati su trasformatori come DINOv2 di Meta, modello di trasformatore di visione autocontrollato e CLIP, che offrono una maggiore precisione per immagine attività di riconoscimento, classificazione e rilevamento di oggetti.

Questi modelli consentono ai sistemi di analizzare immagini e flussi video ad alta risoluzione con maggiore efficienza, rendendo il dispositivo ideale per applicazioni come controllo di qualità automatizzato, sorveglianza e navigazione autonoma.

Anche i carichi di lavoro di intelligenza artificiale generativa beneficiano delle funzionalità della piattaforma. Eseguendo LLM compatti localmente, come Llama-3.1 8B o Gemma-2: gli sviluppatori possono implementare applicazioni come chatbot RAG (retrieval-augmented generation) o contenuti in tempo reale riepilogo.

La combinazione di bassa latenza e consumo energetico ridotto rende Jetson Orin Nano Super adatto per ambienti edge in cui la larghezza di banda e l’accesso al cloud sono limitati.

Ecosistema per sviluppatori e lunga durata-Supporto a termine

Nvidia afferma di essere impegnata a supportare la comunità Jetson attraverso risorse e strumenti completi. Jetson AI Lab fornisce agli sviluppatori contenitori predefiniti, guide di distribuzione ed esercitazioni per l’implementazione di modelli AI. Gli esempi includono l’integrazione di Ollama per l’implementazione di chatbot e l’utilizzo di framework di Hugging Face, Google, Microsoft e Meta.

Anche il kit per sviluppatori supporta fino a quattro telecamere, consentendo l’elaborazione multi-stream per attività basate sulla visione, fondamentali per la robotica e i sistemi autonomi.

Per garantire stabilità a lungo termine, Nvidia ha esteso il ciclo di vita del prodotto Jetson Orin fino al 2032 , offrendo agli sviluppatori e alle aziende la fiducia nella disponibilità della piattaforma per implementazioni future.

Un passo avanti per l’Edge AI

Con Jetson Orin Nano Super, Nvidia combina miglioramenti Prestazioni dell’intelligenza artificiale a costi accessibili, rispondendo alla crescente esigenza di elaborazione on-device in tempo reale. La capacità della piattaforma di eseguire modelli di intelligenza artificiale generativa compatti, elaborare immagini ad alta risoluzione e accelerare lo sviluppo della robotica la rende uno strumento essenziale per gli sviluppatori che lavorano su soluzioni edge.

Offrendo miglioramenti hardware insieme alle ottimizzazioni software che si applicano alle soluzioni esistenti dispositivi, Nvidia ha creato un solido ecosistema per lo sviluppo dell’intelligenza artificiale all’avanguardia.