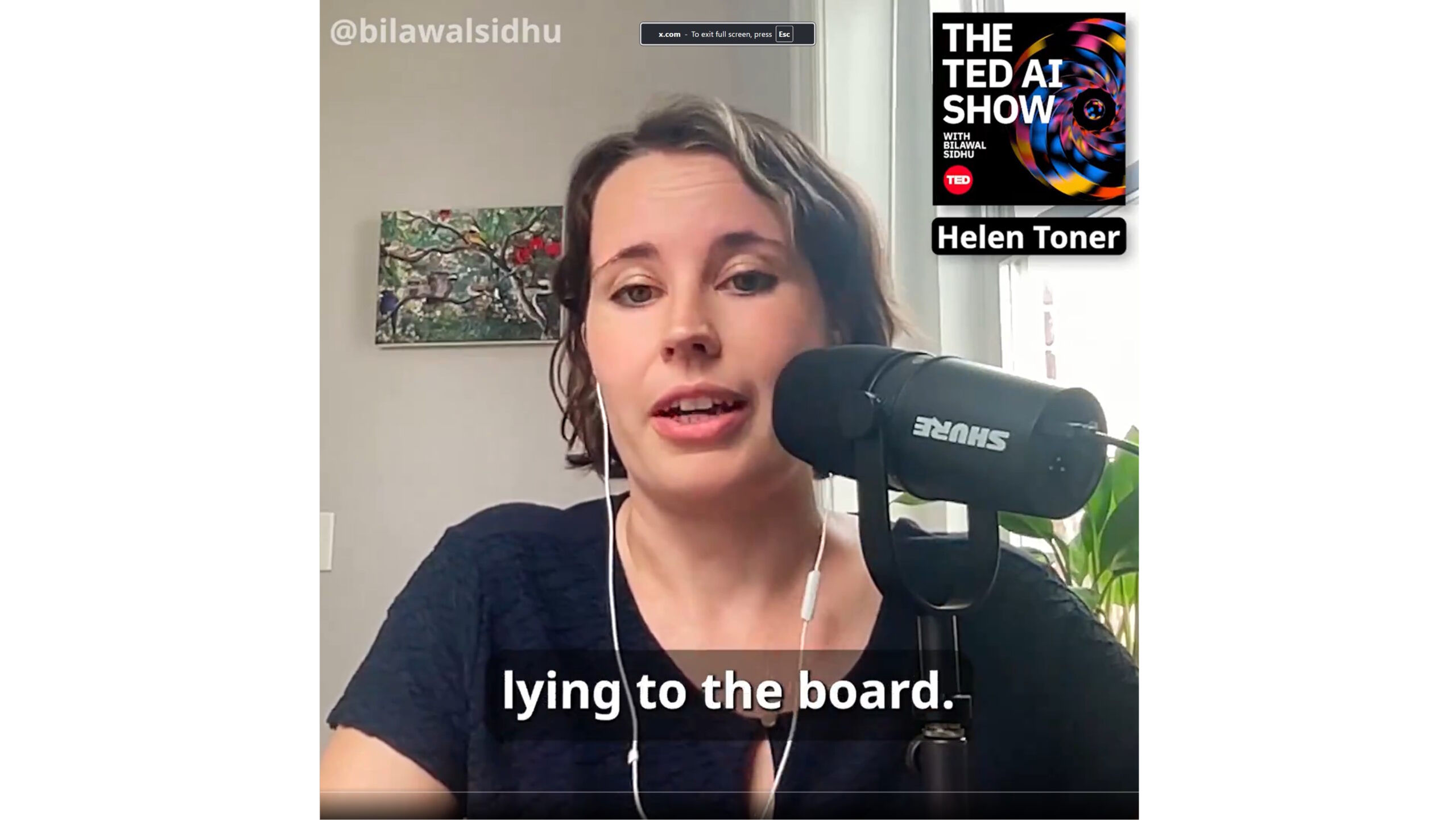

Helen Toner, ex membro del consiglio di amministrazione di OpenAI, ha rivelato che il consiglio non era a conoscenza del lancio di ChatGPT fino a quando non è stato annunciato pubblicamente su Twitter. Toner lo ha rivelato durante un’intervista al TED AI Show con Bilawal Sidhu.

Durante il podcast, Toner ha fornito il suo resoconto più dettagliato fino ad oggi delle circostanze che portarono alla rimozione di Altman nel novembre dell’anno precedente. Ha spiegato che la decisione è stata influenzata da una serie di eventi non divulgati che hanno sollevato preoccupazioni tra i membri del consiglio.

❗ESCLUSIVO:”Abbiamo appreso di ChatGPT su Twitter.”

Cosa è successo VERAMENTE a OpenAI L’ex membro del consiglio Helen Toner la distrugge silenzio con nuovi dettagli scioccanti sul licenziamento di Sam Altman Ascolta la storia esclusiva e non raccontata su The TED AI Show

Ecco solo un’anteprima: pic.twitter.com/7hXHcZTP9e

— Bilawal Sidhu (@bilawalsidhu) 28 maggio 2024

Toner ha tenuto un discorso TED alcune settimane fa, in cui ha condiviso la sua visione su come dovrebbe essere governata l’intelligenza artificiale senza condividere alcun dettaglio sulle turbolenze a livello mondiale. OpenAI o il suo ruolo in tutto questo. Con l’intervista, la situazione cambia, poiché Toner attacca direttamente Sam Altman e lo accusa di mentire e nascondere dettagli importanti al consiglio di amministrazione di OpenAI.

[contenuto incorporato]

Disturbi nella leadership di OpenAI e reazioni negative da parte dei dipendenti

Dopo il lancio di ChatGPT, OpenAI ha vissuto notevoli sconvolgimenti interni. Un anno dopo, il CEO Sam Altman è stato inaspettatamente rimosso dalla sua posizione dal consiglio di amministrazione e sostituito dal CTO Mira Murati. Tuttavia, Altman è stato reintegrato in pochi giorni, a seguito del forte sostegno del CEO di Microsoft Satya Nadella. Questa reintegrazione ha portato alla partenza di Toner e di altri membri del consiglio.

In seguito al licenziamento improvviso di Altman, i dipendenti hanno reagito con forza, molti dei quali hanno minacciato di dimettersi. Questa pressione interna ha portato alla reintegrazione di Altman e alla successiva partenza di Toner e di altri membri del consiglio, evidenziando le profonde divisioni all’interno dell’organizzazione.

Il consiglio di OpenAI è stato progettato per dare priorità al benessere pubblico rispetto al profitto, operando come organizzazione no-profit entità. Nonostante questa missione, il consiglio non è stato informato di sviluppi significativi, come il rilascio di ChatGPT nel novembre 2022.

Critiche interne e partenze

Altre chiavi i dati hanno anche criticato la direzione dell’azienda. Il co-fondatore Ilya Sutskever e il ricercatore sulla sicurezza Jan Leike hanno lasciato OpenAI, esprimendo preoccupazione per la decisione dell’azienda di interrompere il lavoro di superallineamento. Questa ricerca garantisce che i sistemi di intelligenza artificiale si allineino ai valori e alle intenzioni umane.

Come annunciato ieri, Leike guiderà un nuovo team di”superallineamento”presso Anthropic. Leike ha annunciato tramite un post su X che il suo nuovo team presso Anthropic si concentrerà su vari aspetti della sicurezza e della protezione dell’intelligenza artificiale. Le aree di interesse principali includeranno la supervisione scalabile, la generalizzazione da debole a forte e la ricerca sull’allineamento automatizzato.

OpenAI ha istituito un comitato per la sicurezza e la protezione in risposta a richieste interne e critiche esterne. Questo nuovo organismo mira a esaminare attentamente le procedure di sicurezza dell’azienda relative allo sviluppo del prodotto, garantendo che le operazioni siano in linea con la sua missione fondamentale di bene pubblico. Il comitato comprende il CEO di OpenAI Sam Altman, i membri del consiglio Bret Taylor, Adam D’Angelo e Nicole Seligman, insieme al capo scienziato Jakub Pachocki e al capo della sicurezza Matt Knight.