I ricercatori di Microsoft e dell’Università di Beihang hanno introdotto MoRA, una nuova tecnica progettata per mettere a punto modelli linguistici di grandi dimensioni (LLM) con maggiore efficienza e costi ridotti.

A differenza dei tradizionali Parameter-Efficient Fine-Tuning (PEFT), MoRA si concentra sulla regolazione di un sottoinsieme ottimale di parametri, consentendo al modello di apprendere nuove informazioni senza rivedere l’intero set di parametri. Questo metodo semplifica il processo di adattamento dei LLM a compiti specifici riducendo significativamente le risorse necessarie per la messa a punto.

Sfide con i metodi tradizionali

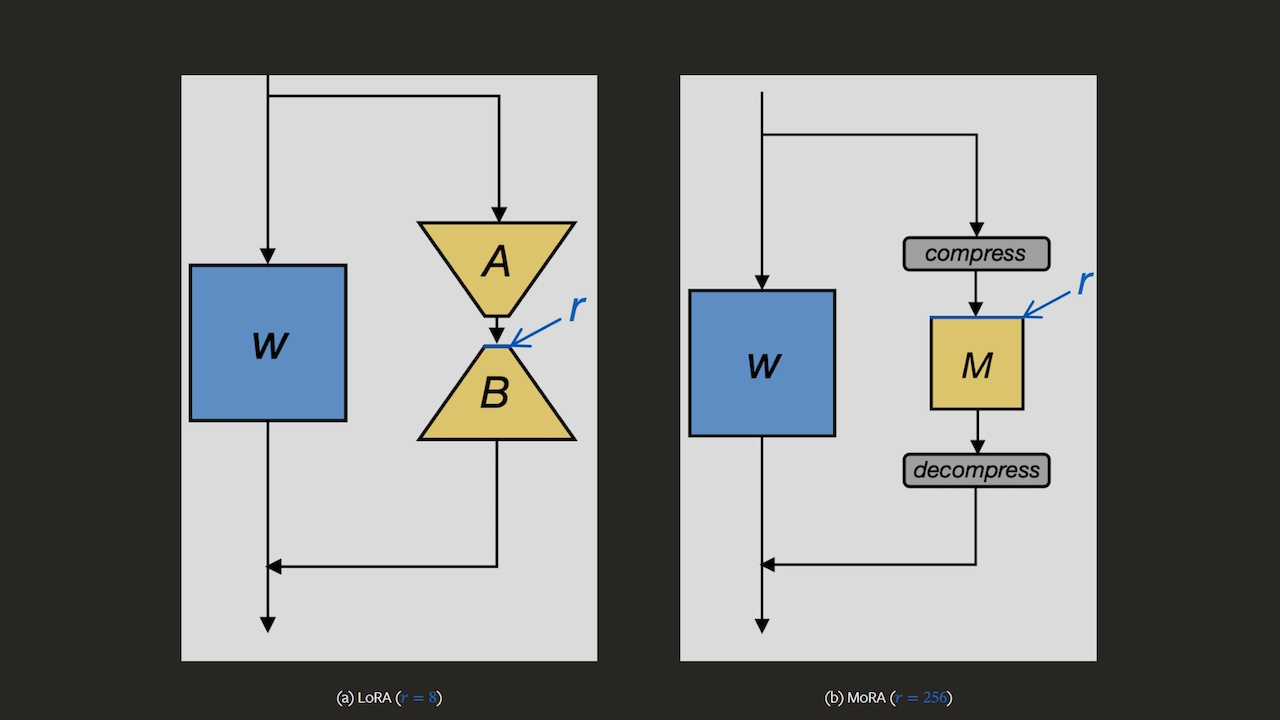

Tradizionale Metodi PEFT, come L’adattamento di basso rango (LoRA) è stato ampiamente adottato grazie alle minori richieste di memoria e alla facilità di archiviazione e distribuzione di modelli ottimizzati. Tuttavia, questi metodi devono affrontare dei limiti quando si affrontano compiti complessi che richiedono un’ampia espansione delle conoscenze, come il ragionamento matematico avanzato e la pre-formazione continua in diversi ambiti. I ricercatori hanno identificato che il meccanismo di aggiornamento di basso rango di LoRA fatica ad assimilare e archiviare in modo efficace nuove informazioni a causa della dimensione limitata del rango del suo adattatore rispetto al modello completo.

Differenze strutturali di MoRA

MoRA si distingue utilizzando una matrice quadrata per ottimizzazione dei parametri, in contrapposizione alle matrici di basso rango utilizzate da LoRA. Questo cambiamento strutturale consente al MoRA di raggiungere un rango più elevato all’interno delle dimensioni originali del modello, migliorando la sua capacità di incorporare nuove conoscenze in modo più efficace rispetto al LoRA o ai modelli di dimensioni simili. Per integrare questo nuovo sistema all’interno dei framework LLM esistenti senza alterarne i parametri operativi, il team ha sviluppato una funzione di compressione-decompressione unica che facilita transizioni fluide tra gli spazi del modello modificato e quello originale.

L’efficacia pratica del MoRA è stata valutata attraverso una serie di analisi comparative con adattamenti LoRA di pari dimensioni. I risultati hanno dimostrato le prestazioni superiori di MoRA nei compiti di memorizzazione e la sua efficacia comparabile nell’ottimizzazione delle istruzioni e nel ragionamento matematico. Nei campi che richiedono una pre-formazione continua, come i settori biomedico e finanziario, la maggiore capacità di MoRA per l’aggiornamento di alto livello si è rivelata particolarmente vantaggiosa, superando costantemente i modelli LoRA.

Implicazioni per imprese e sviluppatori

Con l’introduzione del MoRA, l’approccio alla messa a punto efficiente dei parametri è destinato ad evolversi. Le aziende e gli sviluppatori che lavorano con LLM possono sfruttare MoRA per utilizzare modelli più piccoli e più specializzati per attività complesse senza incorrere nei costi elevati associati a sistemi più grandi e generalizzati. Il rilascio open source di MoRA da parte dei ricercatori ne amplifica ulteriormente il potenziale impatto, offrendo uno strumento solido per migliorare i modelli di base con nuove conoscenze specializzate in varie aree di applicazione.