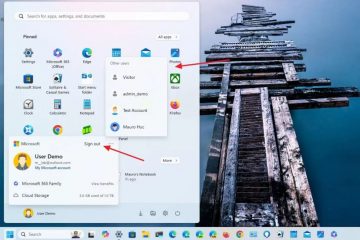

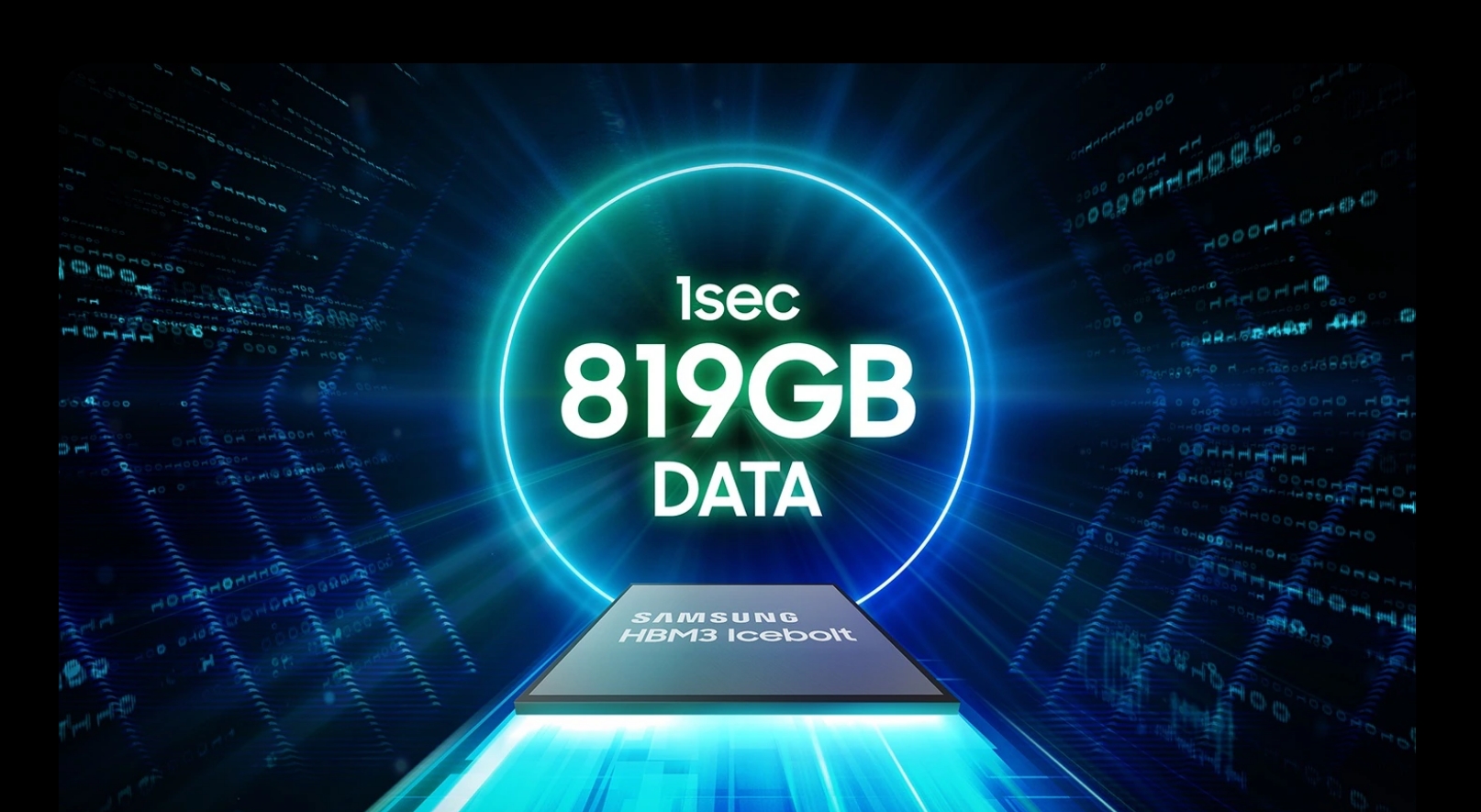

I chip DRAM HBM3 di Samsung, progettati per l’uso negli acceleratori AI di Nvidia, hanno riscontrato problemi di prestazioni durante test. Le preoccupazioni principali riguardano l’eccessiva generazione di calore e l’elevato consumo energetico, che hanno sollevato dubbi sulla loro idoneità alle esigenze di calcolo ad alte prestazioni di Nvidia. HBM è l’acronimo di High Bandwidth Memory, che utilizza un design del chip che fornisce una larghezza di banda maggiore rispetto ai moduli DDR4 o GDDR5 utilizzando meno energia e in un fattore di forma sostanzialmente più piccolo. Ciò si ottiene impilando fino a otto DRAM dies e un die base opzionale che può includere circuiti buffer e logica di test.

Preoccupazioni sul consumo di calore e energia

I problemi segnalati di calore e consumo energetico non riguardano solo i chip HBM3. Anche i chip HBM3E di Samsung, presentati alcuni mesi fa, stanno riscontrando problemi simili. Questi problemi sono diventati evidenti quando i risultati dei chip HBM3E a 8 e 12 strati di Samsung sono stati rilasciati nell’aprile 2024.

Al contrario, SK Hynix ha iniziato a fornire chip HBM3E a Nvidia nel marzo 2024, posizionandosi come un attore chiave nel mercato HBM. SK Hynix è attualmente il maggiore fornitore di Nvidia di chip HBM, essenziali per il funzionamento degli acceleratori AI. La posizione dominante di Nvidia nel mercato dell’intelligenza artificiale, con una quota dell’80%, rende la sua certificazione cruciale per qualsiasi produttore di chip HBM.

Sforzi di ottimizzazione di Samsung

Samsung ha riconosciuto la necessità di ottimizzazione in linea con le esigenze dei clienti. L’azienda ha lavorato a stretto contatto con i clienti per risolvere questi problemi e da oltre un anno si sforza di superare i severi test di Nvidia. I recenti cambiamenti alla leadership di Samsung, inclusa la nomina di un ex esperto nello sviluppo di DRAM e flash NAND, sottolineano il suo impegno nel risolvere queste sfide.

La certificazione di Nvidia è vitale per le ambizioni di Samsung nel mercato HBM. I problemi irrisolti di calore e consumo energetico gettano un’ombra sulle prospettive di Samsung. Non è chiaro se questi problemi possano essere affrontati tempestivamente. L’approvazione da parte del CEO di Nvidia Jensen Huang del chip di memoria HBM3E 12H (12 strati) di Samsung alla conferenza GTX AI 2024, dove ha scritto”Jensen Approved”sul chip, sottolinea l’importanza di questa partnership.

La capacità di Samsung di superare queste sfide non è fondamentale solo per il suo business ma anche per l’industria in generale. Sia AMD che Nvidia desiderano che Samsung risolva questi problemi per garantire una fornitura stabile di chip HBM da più fornitori, il che aiuterebbe a mantenere i prezzi competitivi. Samsung sta già fornendo chip HBM ad AMD, sottolineando ulteriormente la necessità di soluzioni di memoria affidabili ed efficienti.

Samsung punta ad avviare la produzione di massa di chip HBM3E entro la fine del secondo trimestre dell’anno gli sforzi per ottimizzare i propri chip HBM in collaborazione con i clienti riflettono la sua determinazione a garantire un punto d’appoggio nel competitivo mercato dell’hardware AI. Il risultato di questi sforzi avrà un impatto significativo sul panorama futuro degli acceleratori AI e del calcolo ad alte prestazioni.