Slack di Salesforce ha dovuto affrontare critiche per le sue politiche sulla privacy, che consentivano piattaforma per analizzare i dati degli utenti per la formazione sull’intelligenza artificiale, a meno che gli utenti non abbiano rinunciato. L’azienda ha chiarito che questi dati rimangono all’interno della piattaforma e non vengono utilizzati per addestrare modelli di terze parti.

Slack ha spiegato che i suoi modelli di machine learning operano a livello di piattaforma per migliorare funzionalità come i consigli sui canali e sulle emoji e la ricerca. risultati. Questi modelli non accedono al contenuto del messaggio originale da messaggi diretti, canali privati o canali pubblici per generare suggerimenti. L’azienda ha sottolineato che i suoi modelli non sono progettati per memorizzare o riprodurre i dati dei clienti.

AI generativa e dati dei clienti

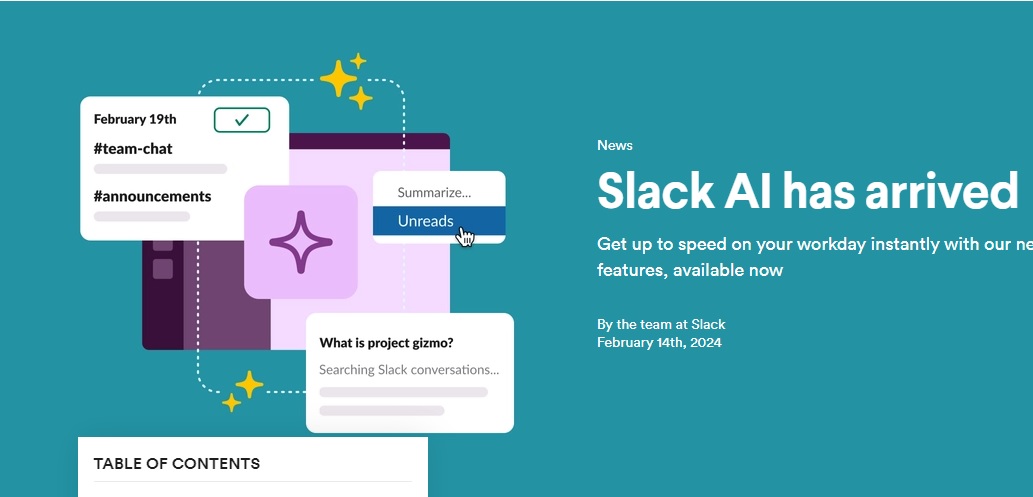

Slack utilizza l’intelligenza artificiale generativa nella sua Slack AI prodotto, utilizzando modelli linguistici di grandi dimensioni (LLM) di terze parti. Secondo la società, nessun dato dei clienti viene utilizzato per formare questi LLM di terze parti. Slack utilizza invece LLM standard che non conservano i dati dei clienti. Questi modelli sono ospitati sull’infrastruttura AWS di Slack, garantendo che i dati dei clienti non lascino il confine di fiducia di Slack e che i fornitori LLM non abbiano accesso a questi dati.

I principi sulla privacy, aggiornati nel 2023, inizialmente includevano un linguaggio che affermava che i sistemi di Slack analizzano i dati dei clienti, come messaggi, contenuti e file, per sviluppare modelli AI/ML. Questo ampio utilizzo dei dati ha portato a una significativa reazione da parte degli utenti, molti dei quali hanno espresso preoccupazione per l’utilizzo dei loro dati per la formazione sull’intelligenza artificiale.

Preoccupazioni degli utenti e risposta dell’azienda

Slack ha insistito affinché i dati non si diffondano tra gli spazi di lavoro, pur riconoscendo che i suoi modelli globali utilizzano i dati dei clienti. Vengono invece analizzati i messaggi all’interno delle singole aree di lavoro. L’azienda ha rivisto i suoi principi sulla privacy per affermare:”Per sviluppare modelli AI/ML non generativi per funzionalità come emoji e consigli sui canali, i nostri sistemi analizzano i dati dei clienti.”

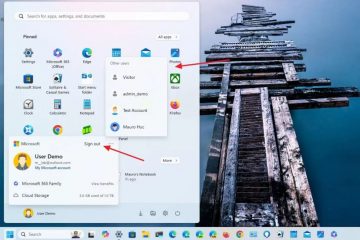

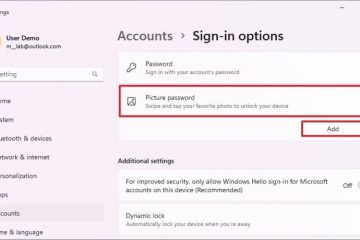

Un portavoce di Slack ha sottolineato che le politiche dell’azienda e le pratiche non sono cambiate; solo la lingua è stata aggiornata per chiarezza. La funzionalità di analisi dei dati è abilitata per impostazione predefinita, il che potrebbe sollevare problemi normativi per annullare l’iscrizione, anche se la società non ha specificato per quanto tempo questo processo richiede.

La disattivazione significa che i clienti potranno comunque beneficiare di modelli addestrati a livello globale senza contribuire con i propri dati a questi modelli. Slack ha spiegato che i dati vengono utilizzati per migliorare funzionalità come l’analisi delle query, il completamento automatico e i suggerimenti delle emoji L’azienda ritiene che questi miglioramenti personalizzati siano possibili solo studiando le interazioni degli utenti con Slack.

Controllo giornalistico e aggiornamenti della documentazione

I giornalisti che si occupano del problema hanno segnalato. ricevendo avvertimenti da Slack sulle”inesattezze”nei loro articoli, che erano basati sulla documentazione di Slack. Da allora l’azienda ha aggiornato questa documentazione per chiarire le proprie pratiche. A partire dal 17 maggio, Slack afferma esplicitamente:”Non sviluppiamo LLM o altri modelli generativi utilizzando i dati dei clienti”e specifica che i suoi sistemi analizzano i dati dei clienti, inclusi i file, per”sviluppare modelli AI/ML non generativi per funzionalità come emoji e consigli sui canali.”

La documentazione aggiornata di Slack rileva inoltre che per il completamento automatico,”i suggerimenti sono locali e provengono da frasi di messaggi pubblici comuni nell’area di lavoro dell’utente. Il nostro algoritmo che sceglie tra potenziali suggerimenti è stato precedentemente addestrato a livello globale completamenti suggeriti e accettati. Proteggiamo la privacy dei dati utilizzando regole per valutare la somiglianza tra il testo digitato e il suggerimento in vari modi, incluso solo l’utilizzo dei punteggi numerici e dei conteggi delle interazioni passate nell’algoritmo.“

Contesto di settore e confronti

L’incidente, che ha portato numerosi utenti a chiudere i propri luoghi di lavoro Slack, evidenzia le sfide che le aziende di software devono affrontare nel comunicare come utilizzano i dati degli utenti per applicazioni di intelligenza artificiale generativa. Le complessità legate alla spiegazione dei flussi di lavoro di retrieval-augmented generation (RAG) e di altri approcci di machine learning in una politica sulla privacy rappresentano un rischio per la reputazione delle aziende.

Slack ha dichiarato:”Il nostro principio guida mentre costruiamo questo prodotto è che il la privacy e la sicurezza dei dati dei clienti sono sacrosante, come dettagliato nella nostra politica sulla privacy, nella documentazione sulla sicurezza, in SPARC e nei Termini Slack.”Tuttavia, una revisione del 17 maggio di The Stack ha rilevato che nessuno di questi documenti menziona l’intelligenza artificiale generativa o l’apprendimento automatico.

Slack raccoglie anche i dati degli utenti per”identificare tendenze e approfondimenti organizzativi”, secondo la sua politica sulla privacy. L’azienda deve ancora rispondere alle domande sul tipo di tendenze organizzative che trae dai dati dei clienti.

Dropbox ha dovuto affrontare un problema simile nel dicembre 2023, quando la confusione su una nuova attivazione/disattivazione predefinita era impostata su”condividi con terze parti”party AI”ha suscitato scalpore. Il CTO di AWS ha segnalato pubblicamente le sue preoccupazioni sulla privacy a Dropbox, che in seguito ha chiarito che”solo il [loro] contenuto pertinente a una richiesta o comando esplicito viene inviato ai nostri partner AI di terze parti [OpenAI] per generare una risposta , riepilogo o trascrizione… i tuoi dati non vengono mai utilizzati per addestrare i loro modelli interni e vengono eliminati dai server di OpenAI entro 30 giorni.”