Qualcomm ha stretto una partnership con Ampere Computing, progettista di processori per server Arm, per rafforzare le capacità dell’infrastruttura AI. Questa collaborazione è stata svelata durante l’aggiornamento annuale della strategia e della roadmap di Ampere, introducendo un server 2U dotato di otto acceleratori Qualcomm AI 100 Ultra e core CPU da 192 Ampere per l’inferenza del machine learning.

Il Qualcomm Cloud AI 100 Ultra offre una soluzione di inferenza AI con prestazioni e costi ottimizzati su misura per l’intelligenza artificiale generativa e modelli linguistici di grandi dimensioni (LLM). Presenta fino a 576 MB di SRAM on-die e 64 core AI per scheda, soddisfacendo le esigenze specifiche di scalabilità dei carichi di lavoro AI classici e generativi, tra cui visione artificiale, elaborazione del linguaggio naturale e LLM basati su trasformatore.

Soluzioni AI ARM ad alta densità

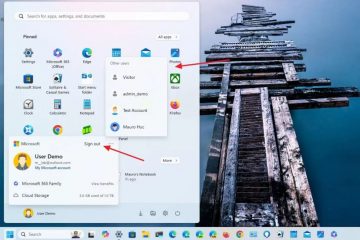

Ampere afferma che questa configurazione può supportare fino a 56 acceleratori AI e 1.344 core di calcolo in un rack standard da 12,5 kW, eliminando la necessità di costosi sistemi di raffreddamento a liquido. L’azienda ha inoltre annunciato che il suo ultimo processore per server sarà dotato di 256 core CPU e fino a 12 canali di memoria, passando alla tecnologia di processo a 3 nm di TSMC il prossimo anno.

Ampere e Oracle hanno dimostrato che i modelli linguistici di grandi dimensioni (LLM) possono essere eseguiti su CPU, anche se con alcune limitazioni. Le CPU sono generalmente più adatte per modelli più piccoli con sette-otto miliardi di parametri e dimensioni batch più piccole. Gli acceleratori AI 100 di Qualcomm, con la loro maggiore larghezza di banda di memoria, sono progettati per gestire modelli più grandi o dimensioni batch più elevate, rendendoli più efficienti per le attività di inferenza.

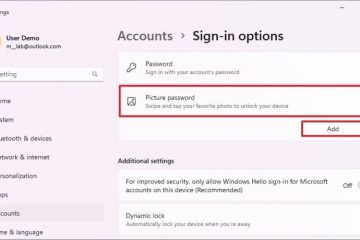

Acceleratori AI 100 Ultra di Qualcomm

Gli acceleratori AI 100 Ultra di Qualcomm, sebbene non così ampiamente riconosciuti nel mercato dei chip AI per data center come le GPU di Nvidia o Gaudi di Intel, sono disponibili da diversi anni. La serie AI 100 Ultra, introdotta lo scorso autunno, è una scheda PCIe sottile a slot singolo destinata all’inferenza LLM. Con 150 W, i suoi requisiti energetici sono modesti rispetto alle GPU da 600 W e 700 W di AMD e Nvidia. Qualcomm afferma che un singolo AI 100 Ultra può eseguire 100 miliardi di modelli di parametri, con una coppia che supporta modelli in scala GPT-3 (175 miliardi di parametri).

La scheda AI 100 Ultra a 64 core offre 870 TOP con precisione INT8 ed è dotato di 128 GB di memoria LPDDR4x, che offre 548 GB/s di larghezza di banda. La larghezza di banda della memoria è essenziale per scalare l’inferenza dell’intelligenza artificiale a batch di dimensioni maggiori. Qualcomm ha implementato ottimizzazioni software come la decodifica speculativa e i formati micro-scaling (MX) per migliorare la produttività e l’efficienza. La decodifica speculativa utilizza un modello più piccolo per generare risposte iniziali, che vengono poi controllate e corrette da un modello più grande. I formati di microscala, una forma di quantizzazione, riducono l’ingombro di memoria dei modelli comprimendo i pesi dei modelli per ridurre la precisione.