Il CEO di OpenAI Sam Altman e Greg Brockman, cofondatore e attualmente presidente di OpenAI, hanno affrontato le preoccupazioni sulla sicurezza dell’IA in seguito alle dimissioni di Jan Leike. Hanno sottolineato l’impegno di OpenAI verso test rigorosi, feedback continuo e collaborazione con governi e parti interessate per garantire solidi protocolli di sicurezza.

Cambiamenti di leadership e preoccupazioni sulla sicurezza

Gen Leike, che ha co-guidato il team di superallineamento con Ilya Sutskever, si è dimesso dopo aver espresso preoccupazione per il fatto che la sicurezza fosse stata messa da parte a favore di rapidi progressi. Sia l’uscita di Leike che quella di Sutskever hanno evidenziato disaccordi interni sulla priorità della sicurezza rispetto all’innovazione. Il team di superallineamento, formato meno di un anno fa, è stato incaricato di esplorare modi per gestire le IA superintelligenti.

Jan Leike, in un thread su X (ex Twitter), ha spiegato di non essere d’accordo con la leadership dell’azienda riguardo alle sue”priorità fondamentali”per”un bel po’di tempo”, portando a un”punto di rottura”. Leike ha affermato che”la cultura e i processi della sicurezza di OpenAI sono passati in secondo piano rispetto a prodotti brillanti”negli ultimi anni, e il suo team ha lottato per ottenere le risorse necessarie risorse per il loro lavoro sulla sicurezza.

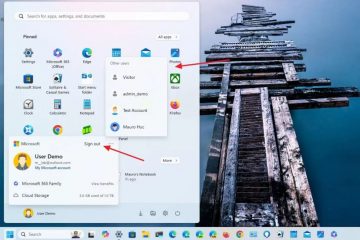

Altman ha risposto inizialmente con una breve risposta al post di Leike di venerdì, riconoscendo che OpenAI ha”molto altro da fare”e che è”impegnato a farlo”, promettendo che sarebbe arrivato un post più lungo. Sabato, Brockman ha pubblicato una risposta condivisa da lui stesso e da Altman su X, esprimendo gratitudine per il lavoro di Leike e rispondendo alle domande successive alle dimissioni.

Siamo davvero grati a Jan per tutto ciò per cui ha fatto OpenAI, e sappiamo che continuerà a contribuire alla missione dall’esterno. Alla luce delle domande sollevate dalla sua partenza, volevamo spiegare un po’come pensiamo alla nostra strategia complessiva.

In primo luogo, abbiamo… https://t.co/djlcqEiLLN

— Greg Brockman (@gdb) 18 maggio 2024

Brockman e Altman hanno sottolineato che OpenAI ha”dimostrato più volte le incredibili possibilità derivanti dall’espansione del deep learning e ne hanno analizzato le implicazioni”e hanno chiesto una governance internazionale dell’intelligenza generale artificiale (AGI) prima che tali appelli diventassero popolari. Hanno citato il Preparedness Framework dell’azienda, che prevede”rischi catastrofici”e cerca di mitigarli, come un modo per migliorare la sicurezza del lavoro.

Nella loro dichiarazione dettagliata, Altman e Brockman hanno riconosciuto la complessità di garantire che la nuova tecnologia sia sicura e hanno delineato il loro approccio alla sicurezza dell’IA. Hanno sottolineato gli sforzi di OpenAI per aumentare la consapevolezza sui rischi e le opportunità dell’AGI, sostenere la governance internazionale e sviluppare metodi per valutare i sistemi di intelligenza artificiale per rischi catastrofici. Hanno inoltre sottolineato l’ampio lavoro svolto per implementare in sicurezza GPT-4 e i miglioramenti continui basati sul feedback degli utenti.

Direzioni future e ricerca sulla sicurezza

Looking in futuro, Altman e Brockman prevedono che i futuri modelli di intelligenza artificiale saranno più integrati con le applicazioni del mondo reale e saranno in grado di eseguire attività per conto degli utenti. Ritengono che questi sistemi offriranno vantaggi sostanziali ma richiederanno un lavoro fondamentale, inclusa una supervisione scalabile e un’attenta considerazione dei dati di formazione. Hanno sottolineato l’importanza di mantenere un elevato standard di sicurezza, anche se ciò significa ritardare i tempi di rilascio.

Altman e Brockman hanno concluso affermando che non esiste una guida stabilita per percorrere il percorso verso l’AGI. Ritengono che la comprensione empirica guiderà la via da seguire e si impegnano a bilanciare i potenziali benefici con la mitigazione dei rischi gravi. Hanno riaffermato il loro impegno nella ricerca sulla sicurezza in diversi periodi temporali e nella collaborazione continua con governi e parti interessate.