Un’indagine completa di Lasso Security ha scoperto che i token API chiave di importanti aziende tecnologiche come Meta, Microsoft e Google sono stati esposti pubblicamente su Hugging Face, la popolare piattaforma di machine learning e intelligenza artificiale open source. I ricercatori hanno identificato più di 1.500 token di questo tipo, garantendo potenzialmente accesso non autorizzato agli account di 723 organizzazioni.

Nella maggior parte dei casi, i token compromessi fornivano permessi di scrittura, che potevano consentire a soggetti esterni di alterare i file all’interno dei repository degli account. Significativamente, i token trapelati includevano l’accesso a importanti progetti di intelligenza artificiale come Llama di Meta, Pythia di EleutherAI e Bloom di BigScience Workshop.

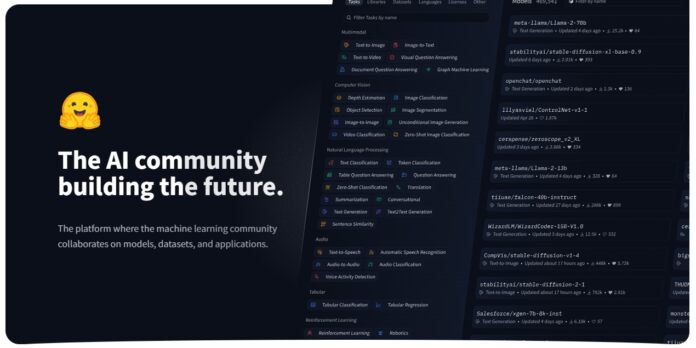

Hugging Face, spesso paragonato a GitHub ma per l’apprendimento automatico e i modelli di intelligenza artificiale, è stato in prima linea la comunità dell’intelligenza artificiale. La piattaforma ospita numerosi modelli di intelligenza artificiale generativa, inclusi modelli degni di nota come Stable Diffusion di Stability AI e Llama 2 di Meta.

L’azienda sviluppa anche i propri modelli di intelligenza artificiale generativa, incluso l’assistente di codice AI SafeCoder che Hugging Face ha rivelato questo mese. La progettazione di SafeCoder consente la distribuzione in sede, conferendo alle aziende la proprietà del proprio codice. A luglio, Hugging Face ha annunciato Agent.js, una libreria JavaScript che consente agli sviluppatori di creare agenti conversazionali che possono essere eseguiti nel browser o sul server.

Potenziale impatto sulle catene di fornitura dell’IA

La portata di questa violazione della sicurezza rappresenta una preoccupazione nei settori dell’intelligenza artificiale e dell’apprendimento automatico. Con i token che offrono sia autorizzazioni di lettura che di scrittura, l’opportunità di gravi attacchi informatici, come l’avvelenamento dei dati, incombe grande. I ricercatori stimano che più di 1 milione di utenti potrebbero essere colpiti, con la possibilità che gli aggressori rubino set di dati, corrompano dati di addestramento o fuggano con modelli proprietari.

Lasso Security ha sottolineato che le ramificazioni di tali violazioni si estendono a elementi fondamentali dell’ecosistema digitale, compresi i filtri antispam di Google e la gestione del traffico di rete. I ricercatori sono stati in grado di dimostrare la facilità con cui potevano modificare set di dati popolari, sottolineando l’urgenza di proteggere le catene di fornitura dell’IA.

Risposta del settore e mitigazione dei rischi

In seguito alle scoperte di Lasso Security, Meta, Google, Microsoft e altri giganti della tecnologia sono stati pronti a revocare i token esposti e rimuovere il codice vulnerabile dai loro repository. Hugging Face, simile a un GitHub per l’intelligenza artificiale, presenta oltre 250.000 set di dati e 500.000 modelli di intelligenza artificiale. In risposta a queste carenze nella sicurezza, Hugging Face offre strumenti per avvisare gli utenti dei token API esposti. Inoltre, hanno adottato misure specifiche per bloccare i token API obsoleti dell’organizzazione (org_api) con accesso in lettura e fatturazione, che i ricercatori hanno ritenuto sfruttabili.

Mentre i token API esposti sono stati risolti, l’incidente porta alla luce la delicata questione natura della sicurezza all’interno delle piattaforme di intelligenza artificiale. Alla comunità tecnologica è stata ricordata l’importanza di pratiche di sicurezza diligenti, compreso l’uso di strumenti di scansione segreti simili a quelli forniti da GitHub, per proteggersi da tali vulnerabilità.

In un’era digitale in cui l’intelligenza artificiale e le macchine stanno diventando sempre più integrati, la scoperta funge da forte avvertimento sul potenziale di attacchi informatici che potrebbero avere conseguenze di vasta portata sia per le organizzazioni che per gli utenti finali. Gli esperti del settore continuano a sostenere misure di sicurezza rafforzate per salvaguardarsi da questi rischi.