Il portale di notizie MSN di Microsoft è sotto esame dopo aver pubblicato un articolo generato dall’intelligenza artificiale che etichettava il giocatore NBA recentemente scomparso, Brandon Hunter, come”inutile”. L’articolo originale, apparso su un sito di notizie sportive chiamato”Race Track”, è diventato virale, suscitando critiche diffuse.

L’articolo, apparentemente generato dall’intelligenza artificiale, descriveva la morte dell’ex giocatore NBA di 42 anni in modo disgustoso, con frasi come”trasmesso”e”eseguita in 67 videogiochi.”Questo incidente ha sollevato preoccupazioni circa l’affidabilità e la sensibilità dei contenuti generati dall’intelligenza artificiale, soprattutto quando si tratta di argomenti delicati come i necrologi.

Un ex giocatore NBA muore giovane e l’intelligenza artificiale scrive questo titolo:

“Brandon Hunter inutile a 42”

E controlla quella prosa:

“L’ex giocatore della NBA Brandon Hunter, che in precedenza giocava per i Boston Celtics e gli Orlando Magic, è morto all’età di 42 anni.”https://t.co/xEvVVHo9DP pic.twitter.com/EiKlZEhluS

— Joshua Benton (@jbenton) 14 settembre 2023

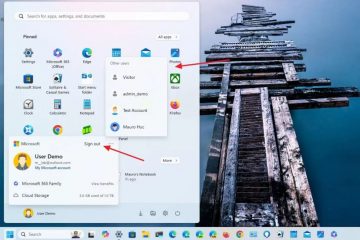

Precedenti incidenti legati all’intelligenza artificiale in Microsoft

Questa non è la prima volta che le iniziative AI di Microsoft News vengono criticate. Nell’agosto 2023, una guida di viaggio generata dall’intelligenza artificiale sul portale di notizie MSN ha stranamente consigliato un banco alimentare locale a Ottawa, in Canada, come attrazione turistica. Nonostante questi ripetuti errori, Microsoft continua a fare molto affidamento sui contenuti generati dall’intelligenza artificiale.

Nel 2020, l’azienda ha persino licenziato il suo team di giornalisti di MSN, provocando un’impennata degli articoli generati dall’intelligenza artificiale sulla piattaforma. Alcuni di questi articoli sono stati criticati per essere di fatto inaccurati, mal composti o addirittura plagiati.

Le implicazioni più ampie dell’intelligenza artificiale nel giornalismo

Le recenti controversie che circondano i contenuti generati dall’intelligenza artificiale di Microsoft evidenziano le sfide e le implicazioni più ampie dell’integrazione dell’intelligenza artificiale nel giornalismo. Sebbene l’intelligenza artificiale sia in grado di generare contenuti rapidamente e su larga scala, manca del tocco umano, della sensibilità e del giudizio necessari per determinati argomenti.

L’incidente con il necrologio di Brandon Hunter serve a ricordare duramente le potenziali insidie del fare affidamento anche su fortemente sull’intelligenza artificiale per la generazione di contenuti. Poiché l’intelligenza artificiale continua a svolgere un ruolo sempre più importante nel giornalismo, è fondamentale per gli editori trovare il giusto equilibrio tra automazione e supervisione umana per mantenere fiducia e credibilità.

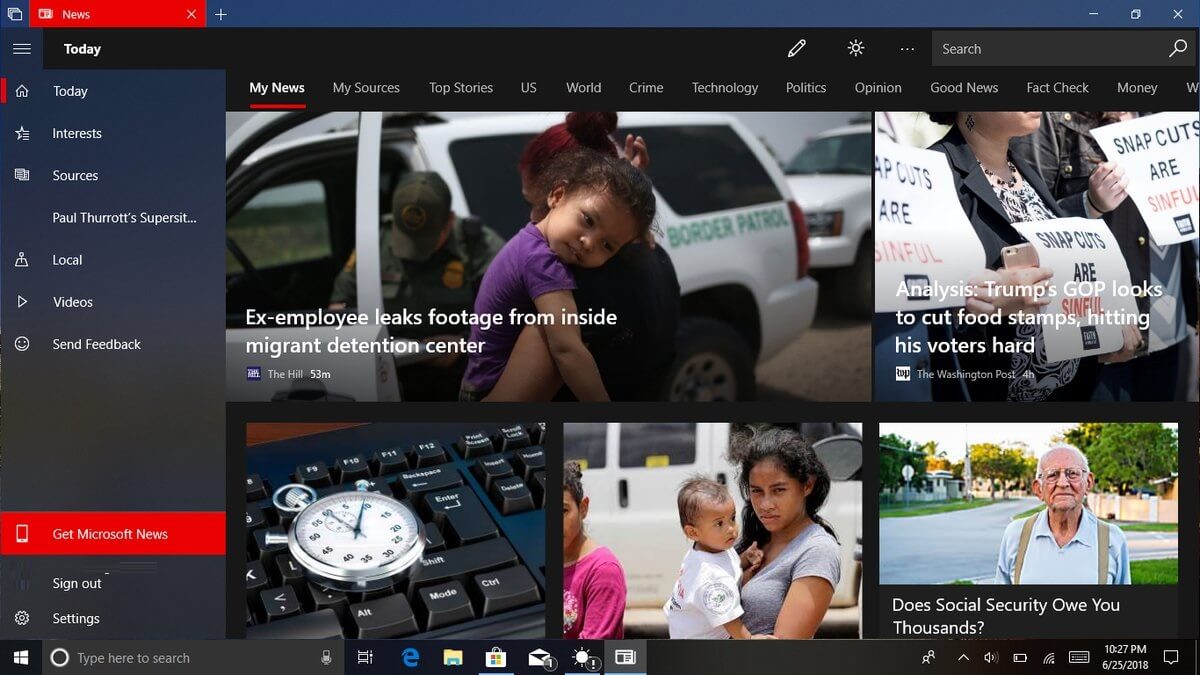

Microsoft sfrutta la stessa generazione di contenuti basata sull’intelligenza artificiale che è alla base di Bing. Chatta Chatbot di ricerca AI. Ciò potrebbe essere problematico perché Bing Chat è una fonte di informazioni molto inaffidabile. Ho smesso di utilizzare Bing Chat come qualsiasi tipo di strumento di ricerca/ricerca corretto. Il chatbot di Microsoft è semplicemente troppo casuale nel dire la verità, includendo virgolette false, inventando nomi e in generale sbagliando dettagli minori ma importanti.

Bing Chat insiste anche sulle sue inesattezze, discute e si confonde facilmente. Questo è importante perché significa che gli utenti devono gestire microgestire il bot, utilizzare istruzioni molto chiare ed essere disposti a verificare tutto ciò che produce. Questo richiede molto tempo e non è molto efficiente per quello che dovrebbe essere uno strumento di ricerca.

Se non è possibile fare affidamento sui risultati delle ricerche, che senso ha usare Bing Chat? È una situazione simile con l’utilizzo per qualsiasi tipo di creazione di contenuti. Se è necessario verificare tutto e utilizzare più suggerimenti, questi strumenti ci aiutano davvero?