Kurang dari empat bulan setelah meluncurkan Segmen Anything Model 2 yang berfokus pada video, Meta telah merilis SAM 3 dan SAM 3D, yang segera menerapkan model visi komputer canggih ke dalam produk konsumen seperti Facebook Marketplace dan Instagram.

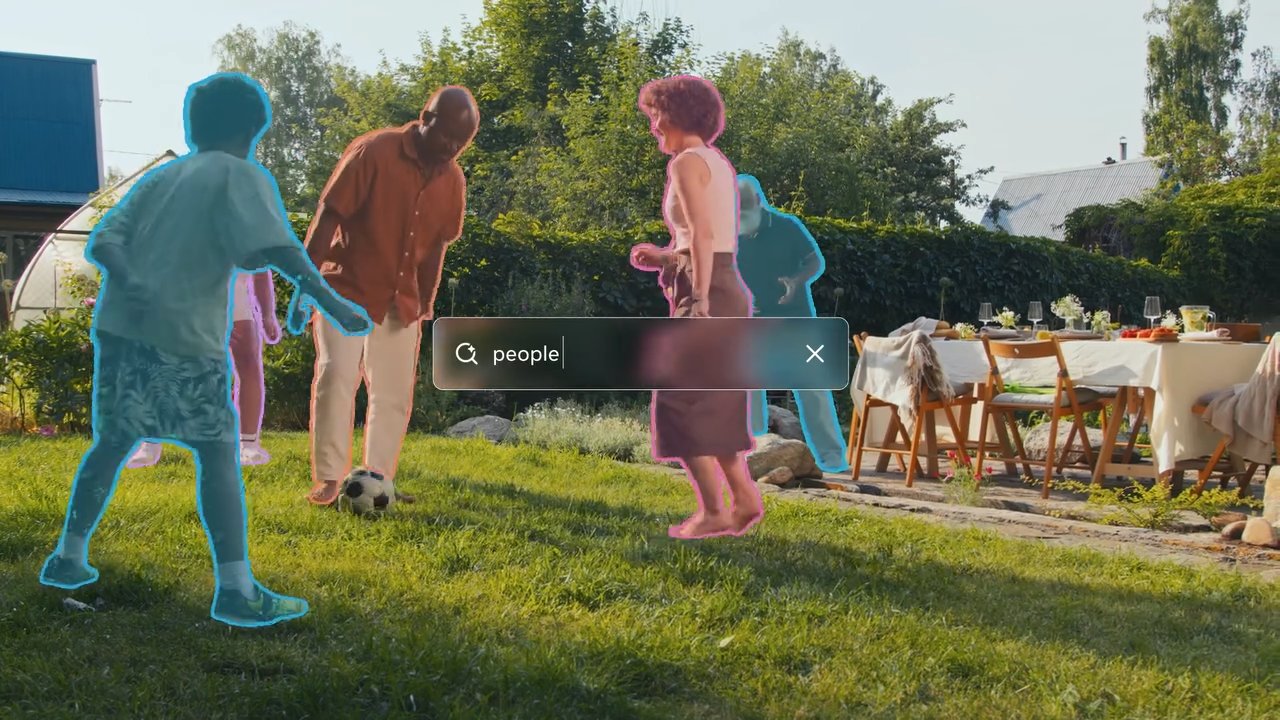

Kedua alat tersebut memberikan komputer pemahaman yang jauh lebih baik tentang apa yang mereka lihat. SAM 3 memungkinkan pengguna mengetikkan deskripsi dan membuat AI langsung menemukan dan menyorot setiap objek yang cocok dalam foto atau video.

SAM 3D melangkah lebih jauh dengan mengambil gambar datar dua dimensi dan memprediksi tampilan objek dari sudut lain, sehingga secara efektif mengubah foto standar menjadi model 3D yang dapat diputar.

Meskipun iterasi sebelumnya sebagian besar masih berada dalam domain penelitian, pembaruan ini menandai peralihan cepat ke utilitas terapan, mendukung fitur yang memungkinkan pengguna memvisualisasikan furnitur di rumah mereka atau menerapkan efek ke objek tertentu dalam video.

Model baru ini memperkenalkan “Segmentasi Konsep yang Dapat Diminta”, yang memungkinkan identifikasi berbasis teks dari semua objek yang cocok dalam sebuah adegan, dan rekonstruksi 3D dengan fidelitas tinggi dari gambar 2D tunggal – kemampuan yang diklaim Meta mengungguli tolok ukur yang ada dengan selisih yang besar.

SAM 2 yang dirilis pada tahun 2024 sangat berfokus pada efisiensi segmentasi video, namun pengumuman hari ini secara signifikan memperluas cakupannya dengan menyertakan pemahaman semantik dan pembuatan 3D.

Dari Riset ke Produk: Integrasi Langsung

Melanggar siklus penelitian hingga produk yang tradisional, Meta melewati fase inkubasi yang umum untuk mengintegrasikan SAM 3 langsung ke dalam aplikasi andalannya.

Pengguna Facebook Marketplace kini akan menemukan fitur “Lihat dalam Ruangan”yang didukung oleh SAM 3D, yang memungkinkan calon pembeli memvisualisasikan tampilan item furnitur di dalam ruangan mereka sebelum melakukan pembelian.

Aplikasi ini memanfaatkan kemampuan model untuk merekonstruksi objek 3D dari satu objek Gambar 2D, mengatasi masalah umum dalam perdagangan online.

Secara bersamaan, aplikasi”Edit”Instagram dan fitur”Vibes”dalam Meta AI menggunakan SAM 3 untuk mengaktifkan efek video spesifik objek yang presisi. Kreator kini dapat menerapkan modifikasi seperti sorotan atau jejak gerakan pada subjek tertentu dalam bingkai video, tugas yang sebelumnya memerlukan masking rumit dalam perangkat lunak pengeditan profesional.

Lihat di Threads

Dengan mengotomatisasi proses ini, Meta bertujuan untuk mengkomoditisasi efek visual tingkat lanjut, menjadikannya dapat diakses sebagai utilitas standar untuk pengguna biasa.

Untuk memfasilitasi eksperimen yang lebih luas, perusahaan telah meluncurkan “Segment Anything Playground,” sebuah antarmuka berbasis web yang memungkinkan publik menguji model ini tanpa keahlian teknis.

Pengguna dapat mengunggah gambar atau video dan meminta sistem dengan deskripsi teks untuk melihat kemampuan segmentasi secara real-time. Strategi ini sangat kontras dengan peluncuran SAM 2, yang pada dasarnya masih merupakan alat bagi komunitas riset visi komputer.

Penerapan segera ke dalam aplikasi konsumen menunjukkan poros strategis untuk memanfaatkan kemajuan AI untuk retensi dan keterlibatan pengguna di seluruh ekosistem sosial Meta.

Lompatan Teknis: Segmentasi Konsep dan 3D

SAM 3 memperkenalkan kemampuan signifikan yang disebut “Promptable Concept Segmentation”(PCS). Tidak seperti pendahulunya, yang berfokus pada segmentasi objek tunggal berdasarkan perintah visual seperti klik atau kotak, SAM 3 dapat mengidentifikasi dan menutupi semua contoh konsep yang dijelaskan oleh teks.

Misalnya, pengguna dapat meminta model dengan “topi baseball merah”, dan itu akan menyegmentasikan setiap item yang cocok dalam bingkai. Pergeseran ini mengharuskan model untuk memiliki pemahaman semantik teks dan kemampuan pelokalan yang tepat.

Untuk mencapai hal ini, arsitektur memisahkan pengenalan dari pelokalan menggunakan “token kehadiran”. Mekanisme ini pertama-tama menentukan apakah suatu konsep ada dalam frame sebelum model mencoba melakukan segmentasi, sehingga mengurangi kesalahan positif dan meningkatkan akurasi deteksi secara keseluruhan.

Menurut Tim Meta Research, “SAM 3 menggandakan akurasi sistem yang ada pada PCS gambar dan video, serta meningkatkan kemampuan SAM sebelumnya pada tugas segmentasi visual.”

Pendekatan ganda ini memungkinkan model menangani kueri kompleks sambil mempertahankan performa tinggi pada tugas segmentasi standar.

Meta Sam 3 Segmentasikan Apa Pun dengan Konsep

Dalam pembuatan 3D, SAM 3D memungkinkan rekonstruksi objek dan pemandangan dari satu gambar 2D, sebuah tugas yang biasanya memerlukan banyak sudut pandang atau data kedalaman. Meta mengklaim model baru ini mengungguli metode yang ada secara signifikan.

Tim Meta AI mencatat bahwa “dalam pengujian preferensi manusia secara langsung, model ini mencapai setidaknya tingkat kemenangan 5:1 dibandingkan model terkemuka lainnya.”Hal ini sangat relevan untuk aplikasi dalam augmented reality dan game, yang memerlukan pembuatan aset secara cepat.

Lihat di Threads

Metrik performa yang dirilis oleh Meta menunjukkan bahwa SAM 3 sangat efisien. Tim Meta Research juga menyatakan bahwa “SAM 3 berjalan dalam 30 milidetik untuk satu gambar dengan lebih dari 100 objek terdeteksi pada GPU H200.” Kecepatan tersebut sangat penting untuk aplikasi real-time pada perangkat konsumen, di mana latensi dapat menurunkan pengalaman pengguna.

Untuk rekonstruksi manusia, SAM 3D Body menggunakan format sumber terbuka baru.

“SAM 3D Body… memanfaatkan format mesh 3D sumber terbuka baru yang disebut Meta Momentum Human Rig (MHR), yang menawarkan peningkatan interpretasi dengan memisahkan struktur kerangka dan bentuk jaringan lunak.”

Pemisahan ini memungkinkan model manusia yang lebih realistis dan dapat disesuaikan. yang dapat berdampak pada avatar virtual dan animasi.

Meskipun ada kemajuan, model ini bukannya tanpa keterbatasan. Tim Meta AI mengakui bahwa “SAM 3 kesulitan untuk melakukan generalisasi ke konsep-konsep di luar domain yang terperinci dengan cara yang mudah dilakukan, seperti mengidentifikasi istilah-istilah tertentu yang memerlukan pengetahuan domain seperti’platelet’.”

Hal ini menunjukkan bahwa meskipun model ini kuat untuk objek umum, model tersebut mungkin memerlukan penyesuaian atau data tambahan untuk menangani kategori khusus atau langka secara efektif.

Mesin Data dan Pembandingan

Dengan memanfaatkan data hibrid mesin, Meta mampu menskalakan data pelatihannya secara signifikan. Perusahaan ini mengembangkan sistem menggunakan “AI annotator”berbasis Llama untuk memverifikasi masker dan memeriksa kelengkapannya, sebuah tugas yang akan sangat lambat jika dilakukan oleh manusia saja.

Meta menjelaskan bahwa “dengan mendelegasikan tugas tertentu kepada anotator AI – model yang menyamai atau melampaui keakuratan manusia – kami memperoleh hasil dua kali lipat dibandingkan dengan pipeline anotasi khusus manusia.”

Pendekatan ini memungkinkan pembuatan kumpulan data SA-Co, yang berisi lebih dari 4 juta konsep unik dan 52 juta masker, menyediakan tempat pelatihan yang kaya untuk model-model baru.

Bersamaan dengan model-model tersebut, Meta telah merilis tolok ukur “Segmen Apa Pun dengan Konsep”(SA-Co). Kumpulan data ini menampilkan 207.000 konsep unik yang dirancang untuk menguji kemampuan pengenalan kosakata terbuka, sehingga mendorong standar industri untuk evaluasi.

Mesin data juga secara berulang menambang “negatif keras”– frasa yang tidak ada dalam gambar tetapi berlawanan dengan model – untuk meningkatkan ketahanan terhadap positif palsu.

Selain aplikasi konsumen, teknologi ini juga dapat diterapkan dalam penelitian ilmiah. Kemitraan dengan Conservation X Labs telah menerapkan SAM 3 pada kumpulan data SA-FARI, yang membantu pemantauan otomatis satwa liar melalui segmentasi video. Kasus penggunaan ini menunjukkan potensi kegunaan model dalam memproses data video yang tidak dikurasi dalam jumlah besar untuk tujuan penelitian.

Rilis ini mencakup bobot model, kode, dan kumpulan data evaluasi, yang melanjutkan strategi Meta dalam teknologi AI utama yang bersumber terbuka. Dengan menyediakan alat-alat ini, Meta bertujuan untuk menetapkan standar industri dan mendorong pengembangan lebih lanjut dalam komunitas AI.

Pekerjaan di masa depan akan fokus pada peningkatan kemampuan model untuk menangani pertanyaan penalaran yang kompleks dengan menggabungkan SAM 3 dengan Multimodal Large Language Models (MLLM), yang berpotensi memungkinkan interaksi yang lebih canggih.