Openai telah mengumumkan metodologi pelatihan keselamatan baru untuk keluarga model GPT-5 baru yang disebut”Penyelesaian Aman.” diumumkan pada 7 Agustus , metode baru ini bergerak melampaui sistem yang kaku dan tolak”Tanpa Malious. Memberikan tanggapan yang bermanfaat namun secara fundamental aman. Menurut OpenAI, pendekatan output-sentris ini membuat model ini secara signifikan lebih berguna tanpa mengurangi batas keamanan inti.

Pivot ini menandai evolusi kunci dari langkah-langkah keamanan yang digunakan dalam generasi sebelumnya, seperti GPT-4. Strategi yang mendasari tampaknya merupakan respons langsung terhadap salah satu tantangan paling gigih dalam AI: membuat model yang bermanfaat dan tidak berbahaya, terutama ketika niat pengguna tidak jelas.

Dilema penggunaan ganda

Di jantung pendekatan baru ini adalah masalah”penggunaan ganda”. Openai menggunakan contoh pengguna yang meminta energi yang dibutuhkan untuk menyalakan kembang api-pertanyaan yang bisa untuk proyek sekolah atau membangun bahan peledak. Ambiguitas ini, di mana informasi memiliki potensi jinak dan jahat, merupakan tantangan inti untuk keselamatan AI.

Masalah ini sangat lazim di domain berisiko tinggi seperti biologi dan keamanan siber, sebagaimana dicatat dalam pengumuman perusahaan. Model keselamatan AI tradisional, yang dilatih pada logika biner”patuh atau menolak”, tidak dilengkapi dengan nuansa ini. Mereka membuat keputusan sederhana berdasarkan kerugian yang dirasakan dari prompt.

Ini mengarah pada apa yang oleh Openai disebut”kerapuhan”dalam modelnya. Sistem ini sepenuhnya sesuai, yang berbahaya jika niat pengguna berbahaya, atau mengeluarkan selimut penolakan seperti”Maaf, saya tidak dapat membantu dengan itu,”yang tidak membantu pengguna yang sah. Kerangka biner ini gagal menavigasi area abu-abu yang luas dari niat manusia.

Risiko inti adalah apa yang digambarkan dokumentasi teknis sebagai”pengangkatan berbahaya,”di mana respons yang tampaknya aman pada tingkat tinggi menjadi berbahaya jika memberikan langkah yang cukup rinci atau bertindak. Keterbatasan yang signifikan inilah yang mendorong Openai untuk mengembangkan metode yang lebih canggih yang dapat menawarkan jawaban yang aman dan tingkat tinggi alih-alih penolakan lengkap.

dari penolakan keras ke penyelesaian yang aman

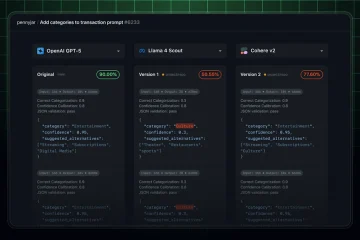

Teknik”Safe Completions”, yang dirinci dalam pengumuman OpenAI , secara fundamental menggeser fokus dari mengklasifikasikan input pengguna untuk memastikan keamanan output model. Alih-alih membuat penilaian biner pada prompt pengguna, pendekatan output-centric ini melatih model untuk menghasilkan respons yang paling membantu yang masih mematuhi kebijakan keselamatan yang ketat.

Menurut GPT-5 System Card , ini adalah Core. Yang pertama adalah”kendala keselamatan,”di mana sistem penghargaan model menghukum setiap respons yang melanggar kebijakan keselamatan. Yang terpenting, hukuman ini tidak seragam; Mereka lebih kuat tergantung pada tingkat keparahan pelanggaran, mengajarkan model pemahaman risiko yang lebih bernuansa.

Prinsip kedua adalah”maksimalisasi bantuan.”Untuk respons apa pun yang dianggap aman, model ini dihargai berdasarkan seberapa membantu itu. Ini termasuk tidak hanya menjawab pertanyaan langsung pengguna tetapi juga, seperti yang dijelaskan Openai,”memberikan penolakan informatif dengan alternatif yang membantu dan aman”. Ini melatih model untuk menjadi mitra yang berguna bahkan ketika tidak dapat sepenuhnya memenuhi permintaan.

Tekanan kompetitif ini menggarisbawahi taruhan tinggi yang terlibat. Karena model AI menjadi lebih kuat, memastikan mereka dapat dipercaya adalah yang terpenting untuk penerimaan publik dan persetujuan peraturan. Namun, pendekatan penyelesaian yang aman juga merupakan pertaruhan tentang kemampuan AI untuk menafsirkan nuansa manusia dengan benar-tantangan yang jauh dari terpecahkan.

Dengan berfokus pada keamanan respons model, Openai percaya itu menetapkan fondasi yang kuat untuk masa depan. Perusahaan berencana untuk melanjutkan lini penelitian ini, yang bertujuan untuk mengajarkan modelnya untuk memahami situasi yang menantang dengan perhatian yang lebih besar.