Kecerdasan buatan bergantung pada kemampuannya dalam menafsirkan data, beradaptasi dengan lingkungan yang dinamis, dan mengambil keputusan dengan informasi yang tidak lengkap. Inti dari proses ini terletak pada entropi—metrik yang mengukur ketidakpastian dan keacakan.

Awalnyaditemukan dalam termodinamika, entropi kini memainkan peran mendasar dalam AI, membimbing sistem untuk menyeimbangkan struktur dengan fleksibilitas dan meningkatkan kemampuannya untuk menangani tugas-tugas kompleks.

Claude Shannon mendefinisikan ulang entropi pada tahun 1948, mentransformasikannya menjadi ukuran ketidakpastian untuk sistem informasi. Karya Shannon memberikan kerangka matematis untuk mengoptimalkan transmisi data, dan wawasannya kini tertanam di seluruh disiplin ilmu AI.

Saat ini, entropi mendorong inovasi dalam pembelajaran mesin, pembuatan data sintetis, model generatif , pembelajaran penguatan, dan komputasi kuantum. Ketika AI menjadi lebih integral dengan teknologi modern, memahami penerapan entropi adalah kunci untuk sistem yang lebih cerdas dan adaptif.

Asal Usul Entropi

Entropi pertama kali diperkenalkan pada abad ke-19 ketika para ilmuwan berusaha memahami efisiensi energi dalam sistem termodinamika. Studi Sadi Carnot tentang panas mesin menginspirasi Rudolf Clausius untuk mendefinisikan entropi secara formal.

Clausius menggambarkannya sebagai bagian energi dalam suatu sistem yang tidak dapat diubah menjadi kerja, yang mencerminkan kecenderungan alam semesta menuju ketidakteraturan yang lebih besar. Konsep termodinamika ini meletakkan dasar untuk memahami keacakan dan ketidakterbalikan dalam sistem fisik.

Terobosan Claude Shannon

Claude Shannon merevolusi entropi dengan menerapkannya pada sistem informasi. Dalam makalah penting A Mathematical Theory of Communication, Shannon mendeskripsikan entropi sebagai ukuran ketidakpastian dalam kumpulan data. Ia menulis, “Masalah mendasar komunikasi adalah mereproduksi pesan yang dipilih pada titik lain secara tepat atau kira-kira pada satu titik.”

Entropi Shannon mengkuantifikasi ketidakpastian informasi, sehingga memungkinkan para insinyur menghitung efisiensi komunikasi. transmisi dan kompresi data. Rumusnya menetapkan entropi sebagai metrik universal untuk mengukur ketidakpastian, menghubungkannya dengan distribusi probabilitas, dan menciptakan landasan bagi teknologi modern berbasis data.

Entropi dalam Mesin. Pembelajaran

Dalam pembelajaran mesin, entropi mengevaluasi keacakan atau ketidakmurnian dalam kumpulan data, memandu algoritme untuk mengambil keputusan yang meminimalkan ketidakpastian

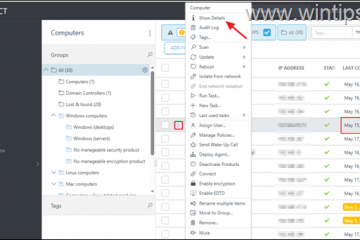

Pohon keputusan, misalnya, menggunakan entropi untuk menentukan pemisahan yang paling informatif. Atribut yang memaksimalkan perolehan informasi, atau pengurangan entropi, dipilih sebagai kriteria pemisahan, sehingga meningkatkan akurasi klasifikasi model.

Pertimbangkan kumpulan data dengan label kelas campuran: entropinya yang tinggi mencerminkan ketidakpastian. Dengan membagi data menjadi beberapa himpunan bagian berdasarkan atribut tertentu, entropi dikurangi, sehingga menghasilkan kelompok yang lebih homogen.

Proses berulang ini membangun pohon keputusan yang secara sistematis menurunkan ketidakpastian, menciptakan struktur yang dioptimalkan untuk prediksi yang akurat.

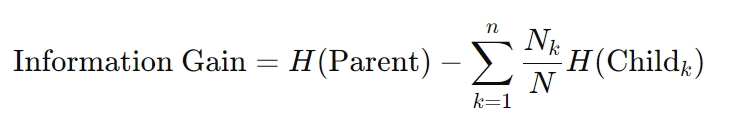

Rumus untuk perolehan informasi adalah sebagai berikut:

Di sini, H mewakili entropi, Nk adalah jumlah sampel di node anak ke-k, dan N adalah total jumlah sampel di node anak k-th simpul induk. Perhitungan ini memastikan bahwa setiap keputusan mengurangi ketidakpastian secara maksimal, sebuah prinsip yang mendasari algoritma pohon keputusan.

Kerugian Cross-Entropy di Jaringan Neural

Entropi juga mendasari pengoptimalan teknik dalam jaringan saraf. Kerugian cross-entropy, sebuah metrik yang banyak digunakan dalam tugas klasifikasi, mengukur perbedaan antara prediksi probabilitas dan label sebenarnya. Meminimalkan kerugian ini akan menyelaraskan prediksi model dengan hasil di dunia nyata, sehingga meningkatkan akurasi.

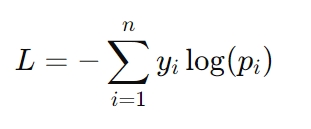

Rumus untuk kerugian lintas entropi adalah:

Di sini, yi mewakili label sebenarnya ( misalnya 0 atau 1), dan pi adalah prediksi probabilitas untuk label tersebut. Hilangnya entropi silang sangat penting dalam tugas-tugas seperti pengenalan gambar dan pemodelan bahasa, yang memerlukan prediksi probabilitas yang tepat agar berhasil.

Peran Entropi dalam Pembuatan Data Sintetis

Data sintetis telah menjadi sumber daya penting dalam pengembangan AI, menawarkan solusi terhadap tantangan seperti terbatasnya akses ke kumpulan data dunia nyata, masalah privasi, dan kendala biaya.

Namun, efektivitas kumpulan data sintetik sangat bergantung pada tingkat entropinya. Data sintetik dengan entropi tinggi memperkenalkan variabilitas yang diperlukan untuk meniru kondisi dunia nyata, sehingga memungkinkan model AI untuk menggeneralisasi skenario baru dengan lebih baik.

Namun, entropi yang berlebihan dapat menimbulkan kebisingan, yang menyebabkan overfitting—saat model menjadi terlalu disesuaikan dengan data pelatihan dan gagal memberikan performa yang baik pada contoh yang tidak terlihat.

Sebaliknya, kumpulan data dengan entropi rendah menyederhanakan pembelajaran tetapi mungkin kurang mewakili kompleksitas data di dunia nyata. Ketidakseimbangan ini berisiko terjadinya underfitting, yaitu model gagal menangkap pola yang berarti, sehingga menghasilkan generalisasi yang buruk. Mencapai keseimbangan yang tepat antara hal-hal ekstrem ini adalah kunci untuk menciptakan data sintetis berkualitas tinggi.

Teknik untuk Mengoptimalkan Data Sintetis dengan Entropi

Untuk mengatasi tantangan yang ditimbulkan melalui entropi dalam kumpulan data sintetik, peneliti menggunakan teknik canggih yang meningkatkan kualitas data sekaligus mempertahankan relevansi:

Seleksi Entropi dengan Maksimalisasi Kesamaan Sintetis Nyata (ESRM): ESRM mengidentifikasi sampel sintetis yang sangat mirip dengan data dunia nyata, memastikan bahwa kumpulan data pelatihan tetap beragam namun dapat dikelola. Menyeimbangkan entropi dalam kumpulan data sintetik memastikan model dilatih berdasarkan contoh yang beragam namun relevan, mengurangi kebisingan sekaligus menjaga utilitas. Pembersihan dan Normalisasi Data: Proses ini membantu menghilangkan keacakan yang berlebihan dengan menyelaraskan distribusi data sintetis dengan distribusi kumpulan data dunia nyata. Normalisasi memastikan bahwa kumpulan data kompatibel dengan algoritme pembelajaran mesin, sehingga memfasilitasi konvergensi model yang lebih lancar. Pemilihan Fitur: Dengan berfokus pada fitur kaya entropi yang memberikan wawasan paling informatif, pemilihan fitur mengurangi redundansi dan gangguan, sehingga menjadikan data sintetis lebih efektif untuk pelatihan model.

Metode ini meningkatkan keandalan data sintetik, membantu sistem AI mencapai generalisasi yang kuat tanpa overfitting atau underfitting.

AI Generatif: Kreativitas dan Kontrol Melalui Entropi

AI Generatif, yang mencakup sistem seperti generator teks, pembuat gambar, dan alat sintesis audio, mengandalkan entropi untuk mengontrol keseimbangan antara kreativitas dan koherensi.

Dengan menyesuaikan ambang batas entropi, pengembang dapat memengaruhi seberapa dapat diprediksi atau bervariasinya keluaran yang dihasilkan.

Misalnya, pengaturan entropi rendah memastikan respons terfokus dan relevan, ideal untuk aplikasi seperti chatbot layanan pelanggan atau asisten penulisan otomatis. Sebaliknya, entropi yang lebih tinggi memperkenalkan keragaman dan kebaruan, sehingga memungkinkan tugas-tugas kreatif seperti pembuatan karya seni atau bercerita.

Kontrol ini sangat penting untuk menyesuaikan AI generatif dengan kasus penggunaan tertentu. Dalam penerapan praktis, penyesuaian entropi membantu menjaga keseimbangan antara inovasi dan presisi, memastikan bahwa keluaran memenuhi tujuan yang diinginkan tanpa mengurangi kualitas.

Mengautentikasi Konten Buatan AI

Entropi juga memainkan peran penting dalam memverifikasi keaslian konten yang dihasilkan AI. Penelitian telah menunjukkan bahwa teks yang dihasilkan AI cenderung menunjukkan entropi yang lebih rendah dibandingkan dengan materi yang ditulis manusia, sehingga lebih mudah untuk dideteksi.

Kesenjangan yang terukur ini memberikan tolok ukur untuk membedakan konten sintetis dari ekspresi asli manusia.

Metrik tersebut memiliki aplikasi praktis dalam memerangi misinformasi dan memastikan integritas konten yang dihasilkan AI. Organisasi menggunakan analisis entropi untuk mengidentifikasi potensi penyalahgunaan AI generatif dalam deepfake, berita palsu, atau propaganda otomatis, sehingga menyoroti semakin pentingnya AI generatif dalam verifikasi konten.

Pembelajaran Penguatan: Menjelajahi Hal yang Tidak Diketahui dengan Entropi

Dalam pembelajaran penguatan (RL), entropi sangat penting untuk menjaga keseimbangan antara eksplorasi dan eksploitasi. Eksplorasi melibatkan percobaan tindakan baru untuk menemukan strategi yang lebih baik, sedangkan eksploitasi berfokus pada penyempurnaan tindakan yang diketahui untuk memaksimalkan imbalan. Kebijakan entropi tinggi mendorong pemilihan tindakan yang beragam, sehingga mencegah agen terjebak dalam solusi suboptimal.

Prinsip ini sangat berharga dalam lingkungan yang dinamis, seperti robot otonom, AI permainan, dan sistem logistik adaptif, di mana fleksibilitas dan kemampuan beradaptasi sangat penting.

Regulerisasi entropi—sebuah teknik yang memperkenalkan istilah penalti berdasarkan entropi kebijakan—memastikan bahwa agen mempertahankan keacakan yang cukup untuk mengeksplorasi strategi alternatif tanpa mengorbankan kinerja jangka panjang.

Menstabilkan Pembelajaran dengan Entropi

Metode gradien kebijakan, salah satu kelas algoritme RL, juga mendapat manfaat dari efek stabilisasi entropi. Dengan mempertahankan keacakan terkendali dalam proses pengambilan keputusan agen, entropi mencegah konvergensi dini dan mendorong eksplorasi yang lebih komprehensif.

Entropi memastikan bahwa agen pembelajaran penguatan tetap dapat beradaptasi, memungkinkan mereka untuk berkembang dalam lingkungan yang kompleks dan tidak dapat diprediksi.

Entropi dalam Komputasi Kuantum dan Kompresi Data

Dalam komputasi kuantum, entropi memainkan peran penting dalam mengevaluasi koherensi dan keterjeratan keadaan kuantum. Tidak seperti sistem klasik, di mana entropi mengkuantifikasi ketidakteraturan dalam distribusi data, entropi kuantum menangkap sifat probabilistik dari sistem kuantum.

Metrik seperti von Entropi Neumann banyak digunakan untuk mengukur ketidakpastian dan memandu optimalisasi teori kuantum hibrid. algoritma klasik.

Algoritma ini memanfaatkan entropi kuantum untuk memecahkan masalah yang secara komputasi tidak layak untuk sistem klasik, seperti tugas optimasi yang kompleks, kriptografi, dan simulasi struktur molekul.

Misalnya, entropi von Neumann berperan penting dalam menyempurnakan jaringan saraf kuantum, yang memadukan prinsip-prinsip probabilistik mekanika kuantum dengan kerangka pembelajaran mesin tradisional. Entropi pada dasarnya menjembatani ketidakpastian yang melekat dalam mekanika kuantum dengan prediktabilitas yang dituntut oleh sistem klasik.

Entropi kuantum juga membantu koreksi kesalahan, yang merupakan tantangan utama dalam komputasi kuantum. Dengan mengidentifikasi dan meminimalkan sumber entropi dalam sistem kuantum, developer dapat meningkatkan stabilitas dan keandalan qubit, sehingga membuka jalan bagi teknologi kuantum yang lebih tangguh.

Kompresi Data Berbasis Entropi

Entropi mendasari algoritme kompresi data, memungkinkan penyimpanan dan transmisi yang efisien dengan mengurangi redundansi sekaligus menjaga hal-hal penting informasi. Teknik kompresi menganalisis tingkat entropi dalam kumpulan data untuk mengoptimalkan skema pengkodean, mencapai keseimbangan antara meminimalkan ukuran file dan mempertahankan integritas data.

Pendekatan ini sangat berharga dalam lingkungan dengan bandwidth terbatas seperti jaringan IoT dan sistem komputasi edge.

Misalnya, metode kompresi berbasis entropi memungkinkan perangkat IoT mengirimkan data sensor dengan lebih efisien, mengurangi konsumsi daya dan penggunaan bandwidth. Dengan memanfaatkan entropi sebagai metrik panduan, sistem ini mencapai kinerja tinggi tanpa mengorbankan akurasi atau keandalan.

Pertimbangan Etis: Inklusivitas, Bias, dan Transparansi

Kumpulan data dengan entropi tinggi sering kali menyertakan contoh yang beragam dan kurang umum, seperti data yang mewakili kelompok yang kurang terwakili. Titik data ini penting untuk membangun sistem AI yang adil, namun data tersebut dapat secara tidak sengaja dikecualikan selama proses pengoptimalan entropi, sehingga menyebabkan hasil yang bias.

Pengembang harus memastikan bahwa teknik berbasis entropi memperhitungkan semua titik data yang relevan untuk mencegah pengecualian kelompok marginal.

Dalam AI, meskipun entropi mengukur ketidakpastian, tanggung jawab kita adalah untuk memastikannya bahwa cara kami menanganinya mencerminkan komitmen terhadap keadilan dan inklusivitas. Membangun sistem transparan yang memprioritaskan inklusivitas tidak hanya meningkatkan keadilan tetapi juga meningkatkan ketahanan model AI dengan memaparkannya pada skenario yang lebih luas.

Transparansi dalam Pengambilan Keputusan Berbasis Entropi

Seiring dengan semakin bergantungnya sistem AI pada entropi untuk memandu pengambilan keputusan, menjaga transparansi menjadi hal yang sangat penting. Hal ini terutama berlaku dalam aplikasi sensitif seperti layanan kesehatan dan pengambilan keputusan hukum, yang taruhannya tinggi.

Menjelaskan bagaimana metrik entropi memengaruhi prediksi atau keputusan model sangat penting untuk membangun kepercayaan dan memastikan akuntabilitas.

Misalnya, dalam AI medis, entropi sering digunakan untuk mengukur ketidakpastian dalam prediksi diagnostik. Dengan mengomunikasikan ketidakpastian ini kepada profesional kesehatan, sistem ini memungkinkan pengambilan keputusan yang lebih tepat, menjembatani kesenjangan antara keluaran algoritmik dan keahlian manusia.

Memperluas Peran Entropi dalam AI

Quantum AI mewakili konvergensi kecerdasan buatan dan komputasi kuantum, dan entropi adalah inti dari persimpangan ini. Para peneliti sedang mengeksplorasi bagaimana metrik entropi kuantum, seperti entropi von Neumann, dapat mengoptimalkan jaringan saraf kuantum dan sistem hibrida lainnya.

Kemajuan ini menjanjikan pemecahan masalah kompleks di berbagai bidang seperti logistik, penemuan obat, dan komunikasi yang aman.

Misalnya, sistem AI kuantum dapat memanfaatkan entropi untuk memodelkan interaksi molekuler yang rumit dengan teknologi yang belum pernah ada sebelumnya. presisi, mempercepat terobosan dalam bidang farmasi. Dengan menggabungkan kekuatan probabilistik sistem kuantum dan kemampuan beradaptasi AI, entropi terus memperluas pengaruhnya dalam teknologi mutakhir.

Integrasi di Seluruh Alur Kerja AI

Entropi semakin terintegrasi ke dalam setiap tahapan alur kerja AI, mulai dari prapemrosesan data hingga pengambilan keputusan secara real-time. Ini berfungsi sebagai metrik pemersatu untuk mengukur ketidakpastian, memungkinkan sistem beradaptasi secara dinamis terhadap perubahan kondisi.

Integrasi ini memastikan AI tetap fleksibel, andal, dan mampu mengatasi tantangan lingkungan yang kompleks.

Industri mulai dari kendaraan otonom hingga pemodelan keuangan mendapat manfaat dari pendekatan berbasis entropi, yang meningkatkan akurasi prediksi, kecepatan pengambilan keputusan, dan kemampuan beradaptasi. Dengan memasukkan entropi ke dalam inti pengembangan AI, para peneliti membangun sistem yang tidak hanya kuat secara teknis namun juga selaras dengan tujuan etika dan sosial.

Apa yang Ada di Depan

Entropi telah berevolusi dari konsep termodinamika menjadi landasan kecerdasan buatan. Dengan mengukur ketidakpastian, hal ini memungkinkan sistem AI untuk menyeimbangkan keacakan dan struktur, mendorong kemampuan beradaptasi, kreativitas, dan presisi. Baik memandu algoritme pembelajaran mesin, mengelola data sintetis, atau mendorong inovasi AI kuantum, kita dapat melihat dengan jelas bagaimana entropi mengubah cara kecerdasan buatan belajar dan beradaptasi.

Seiring dengan pertumbuhan AI yang semakin kompleks dan berdampak, pemahaman dan dampak penerapan entropi akan sangat penting untuk membangun sistem yang tidak hanya lebih cerdas namun juga lebih adil, lebih transparan, dan lebih siap untuk menghadapi ketidakpastian di dunia nyata.