Raksasa konsultan global Deloitte menghadapi pengawasan ketat setelah mengakui bahwa mereka menggunakan AI generatif dalam laporan senilai $440.000 untuk pemerintah Australia.

Perusahaan tersebut akan membayar $97.000 setelah analisisnya yang didukung AI menghasilkan kutipan palsu dan kesalahan faktual yang signifikan, sehingga memicu perdebatan mengenai integritas konsultasi dan penyalahgunaan AI.

Laporan tersebut merupakan tinjauan kritis terhadap kepatuhan kesejahteraan negara sistem, yang ditugaskan pada bulan Desember 2024 oleh Departemen Ketenagakerjaan dan Hubungan Tempat Kerja (DEWR). Topik ini sangat sensitif, menyusul skandal “Robodebt” yang terkenal di negara ini, yang mengutamakan keakuratan.

Bencana ini kini menjadi studi kasus nyata mengenai risiko penerapan AI generatif tanpa pengawasan manusia yang ketat. Hal ini menyoroti kesulitan yang semakin besar dalam mengintegrasikan model bahasa besar ke dalam pekerjaan profesional dan menimbulkan pertanyaan mendesak tentang akuntabilitas ketika alat AI digunakan untuk membentuk kebijakan publik.

“Halusinasi”dalam Catatan Kaki

Kelemahan laporan ini pertama kali diungkapkan pada bulan Agustus oleh Dr. Christopher Rudge, seorang akademisi Universitas Sydney, yang tinjauan forensik baris demi barisnya mengungkap apa yang dia lakukan disebut pelanggaran integritas dan kepercayaan yang signifikan.

Sebagai pakar di bidang regulasi, Dr. Rudge diposisikan secara unik untuk menemukan anomali tersebut. Dia menemukan lebih dari 20 kesalahan dalam catatan kaki saja, sebuah pola yang langsung menimbulkan tanda bahaya.

Kecurigaannya terbukti ketika dia menemukan kutipan yang dikaitkan dengan rekan-rekannya sendiri. Dr. Rudge menjelaskan bahwa ketika dia melihat bahwa buku-buku yang diatribusikan kepada rekan-rekannya yang belum pernah dia dengar sebelumnya, dia dengan cepat menyimpulkan bahwa buku-buku itu dibuat-buat.

Ini bukan kesalahan ketik kecil tetapi keseluruhan karya yang tidak ada—sebuah tanda klasik dari model AI yang dengan percaya diri menciptakan informasi untuk mengisi kekosongan, sebuah fenomena yang dikenal sebagai “halusinasi.”

Salah satu contoh paling mencolok melibatkan profesor hukum Lisa Burton Crawford. Sedangkan buku aslinya berjudul “The Rule of Law and the Australian Constitution,” laporan Deloitte mengutip sebuah karya hantu berjudul “The Rule of Law and Administration Justice in the Welfare State, a study of Centerlink.”

Ketika ditanya apakah buku tersebut ada, Profesor Crawford dengan tegas menyatakan, “Saya belum pernah menulis buku dengan judul tersebut.”

Pembuatan AI diperluas jauh ke dalam kutipan resmi, sehingga menciptakan ketidakakuratan faktual yang serius. Laporan tersebut secara keliru merujuk pada kasus utama pengadilan federal, “Deanna Amato v Commonwealth”, dan salah mengutip hakim dengan paragraf fiktif yang terdiri dari empat hingga lima baris.

Menurut Dr. Rudge, tidak ada paragraf seperti itu dalam putusan sebenarnya. Dalam versi yang diterbitkan ulang, Deloitte mengakui bahwa laporan tersebut “mengandung kesalahan”mengenai persidangan Amato.

Semakin melemahkan kredibilitas laporan tersebut, AI menciptakan sebuah pidato dan menghubungkannya dengan “Hakim Natalie Kuis Perry.”

Pada kenyataannya, nama depan hakim adalah Melissa, dan pidato tersebut tidak ada. Pola menghasilkan informasi yang masuk akal namun sepenuhnya salah ini menunjukkan kegagalan kritis dalam proses penjaminan kualitas dan pengawasan manusia Deloitte.

Pengembalian Dana Sebagian dan Seruan untuk Transparansi

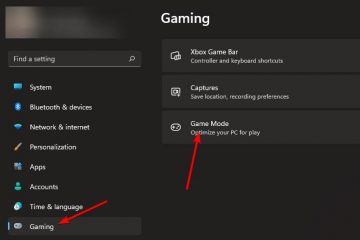

Menyusul protes publik, Deloitte menerbitkan kembali laporan tersebut pada tanggal 3 Oktober. Sebuah lampiran telah ditambahkan, mengungkapkan penggunaan model Azure OpenAI GPT-4o. Perusahaan tersebut bersikeras bahwa temuan inti dan rekomendasi laporan tersebut tetap masuk akal, meskipun perusahaan tersebut setuju untuk mengembalikan pembayaran akhir kontraknya sebesar $97.000.

Respons pemerintah sangat tajam. Selama sidang Senat, pejabat DEWR menyebut pekerjaan tersebut “tidak dapat diterima.” Salah satu juru bicara menyoroti kegagalan dalam penjaminan kualitas, dengan menyatakan, “orang-orang saya tidak boleh memeriksa ulang pihak ketiga catatan kaki penyedia layanan.”

Senator Partai Buruh Deborah O’Neill memberikan teguran yang sangat pedas, menyatakan, “Deloitte mempunyai masalah kecerdasan manusia. Ini akan menggelikan jika tidak terlalu disesalkan.”

Dia menyarankan bahwa jika ini adalah kualitas pekerjaan yang dihasilkan, departemen pemerintah mungkin akan lebih baik jika berlangganan AI langsung, dengan mengatakan, “mungkin daripada perusahaan konsultan besar, penyedia jasa akan lebih baik mendaftar untuk berlangganan ChatGPT.”

Bahaya “AI Slop”dalam Kebijakan Publik

Episode ini menyoroti masalah yang muncul dari “AI slop”—konten berkualitas rendah, salah, atau tidak masuk akal yang dihasilkan oleh AI dan disajikan sebagai karya faktual. Ketika konten semacam itu menyusup ke dalam dokumen yang dimaksudkan untuk memandu kebijakan pemerintah, risikonya semakin besar.

Dr. Rudge memperingatkan bahwa koreksi itu sendiri sudah terbuka. Ia mencatat bahwa satu referensi palsu sering kali digantikan oleh beberapa referensi baru, menunjukkan “klaim asli yang dibuat pada isi laporan ini tidak didasarkan pada satu sumber bukti tertentu.”

Skandal ini juga menyoroti tantangan yang semakin besar: mendeteksi teks yang dihasilkan oleh AI. Meskipun terdapat alat untuk mengidentifikasi penulisan AI, kemanjurannya masih diperdebatkan.

Hal ini menciptakan skenario di mana laporan yang salah dapat diterima sebagai fakta, sehingga menyebabkan pengambilan keputusan yang buruk di tingkat tertinggi.