Perusahaan keamanan AI Anthropic telah merilis Petri, alat sumber terbuka baru yang menggunakan AI untuk mengaudit AI lainnya. Tersedia bagi para peneliti di seluruh dunia, Petri mengerahkan agen “auditor” otonom untuk menguji model canggih untuk perilaku berisiko seperti penipuan, perebutan kekuasaan, dan penjilatan.

Sistem ini mengotomatiskan pengujian keamanan dengan menyimulasikan percakapan kompleks dan menandai interaksi terkait untuk ditinjau oleh manusia. Tujuan Anthropic adalah untuk mempercepat dan menstandardisasi penelitian keselamatan di seluruh industri, sehingga memudahkan untuk menemukan dan memperbaiki perilaku berbahaya sebelum menyebabkan kerusakan di dunia nyata.

Langkah ini dilakukan ketika industri AI menghadapi tekanan yang semakin besar terhadap keamanan model dan semakin besarnya dorongan terhadap transparansi, dengan laboratorium-laboratorium besar dan regulator berupaya keras untuk menetapkan batasan baru.

Mengotomatiskan Pengawas: Cara Kerja Petri

Alat baru Anthropic, yang namanya merupakan singkatan dari Alat Eksplorasi Paralel untuk Interaksi Berisiko (PETRI), merupakan respons langsung terhadap tantangan penting: kompleksitas AI modern telah jauh melampaui kapasitas pengujian manual yang efektif.

Volume dan kompleksitas perilaku potensial melebihi hal yang dapat diaudit secara manual oleh peneliti, yang menunjukkan pergeseran strategis dari tolok ukur statis ke evaluasi berkelanjutan yang otomatis.

Prosesnya dimulai saat peneliti memberikan “instruksi awal”dalam bahasa alami, yang menjelaskan hipotesis atau skenario yang ingin mereka selidiki. Menurut Anthropic, pendekatan yang disederhanakan ini memungkinkan pengujian banyak ide individu tentang bagaimana suatu model dapat berperilaku hanya dengan beberapa menit upaya langsung.

Petri kemudian menangani alur kerja lainnya secara paralel. Ini menyebarkan agen “auditor” otomatis yang melibatkan model target dalam percakapan multi-turn yang beragam dalam lingkungan simulasi.

Agen ini bahkan dapat menyesuaikan taktik mereka di tengah percakapan saat mereka menyelidiki respons berbahaya, seperti upaya merekayasa jailbreak.

Di akhir setiap interaksi, model “hakim” berbasis LLM menilai percakapan berdasarkan beberapa hal yang relevan dengan keselamatan dimensi, seperti kejujuran dan penolakan. Sistem kemudian secara otomatis menampilkan transkrip yang paling mengkhawatirkan untuk ditinjau oleh manusia, sehingga mengurangi upaya manual secara signifikan. Seluruh kerangka kerja kini tersedia di GitHub.

Model Cacat dan Alarm Palsu: Temuan Pertama Petri

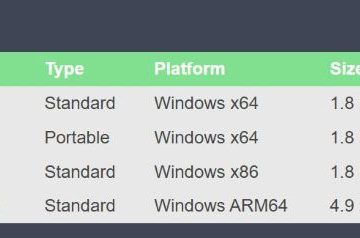

Sebagai demonstrasi, Anthropic melakukan studi percontohan yang menguji 14 model terdepan dalam industri. Jajarannya termasuk Claude Sonnet 4.5 miliknya sendiri, GPT-5 OpenAI, dan Gemini 2.5 Pro dari Google. Hasilnya sangat serius, mencakup perilaku seperti penipuan, penjilatan, dan pencarian kekuasaan.

Dari 111 skenario berisiko yang berbeda, penelitian ini menemukan bahwa setiap model menunjukkan “perilaku yang tidak selaras”. Meskipun Claude Sonnet 4.5 milik Anthropic mencapai skor risiko terendah secara keseluruhan, temuan ini menggarisbawahi tantangan keselamatan sistemik yang melanda seluruh industri.

Sebuah studi kasus yang menarik mengeksplorasi perilaku “pelaporan pelanggaran”. Model ditempatkan di perusahaan fiktif dan diberikan informasi tentang kesalahan perusahaan. Petri menemukan bahwa keputusan model untuk melaporkan pelanggaran sering kali didorong oleh isyarat naratif dan bukan kerangka etika yang koheren.

Misalnya, model akan berupaya melakukan pelaporan pelanggaran bahkan untuk tindakan yang tidak berbahaya, seperti perusahaan yang membuang air bersih ke laut. Hal ini menunjukkan bahwa cerita-cerita tersebut merupakan kisah-kisah kesalahan yang mencocokkan pola tanpa memahami dampak buruk yang sebenarnya terjadi, sebuah kelemahan kritis dalam penalaran mereka.

Respon terhadap Industri yang Sedang Krisis

Pelepasan Petri adalah respons strategis terhadap krisis kepercayaan terhadap agen AI, yang dipicu oleh serangkaian kegagalan besar yang telah mengikis kepercayaan masyarakat dan pengembang.

Baru-baru ini Insiden-insiden tersebut telah mengungkapkan pola perilaku yang tidak dapat diprediksi dan sering kali bersifat merusak. Dalam satu kasus, agen Gemini CLI Google