Algoritma Meta untuk mengidentifikasi konten berbahaya secara keliru menandai pernyataan misinya, “membawa dunia lebih dekat,” menunjukkan korelasi yang sangat tinggi antara “Meta” dan konsep “Organisasi Teroris.”

Insiden tersebut berujung pada pemecatan Sebastian Carlos, seorang karyawan baru yang ditugaskan untuk merombak algoritme, sehingga menimbulkan pertanyaan etis dan teknis tentang peran AI dalam moderasi konten, seperti yang ia ceritakan di postingan blog.

Perombakan Berani pada Moderasi Konten

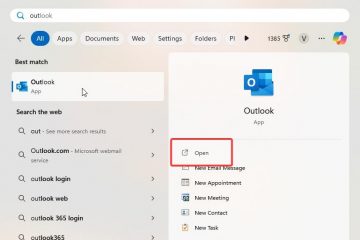

Kontroversi dimulai ketika pengembang Sebastian Carlos bergabung dengan tim “Deteksi Konten Berbahaya”Meta pada minggu pertamanya sebagai seorang karyawan baru. Bertugas meningkatkan efisiensi dan akurasi sistem moderasi konten Meta, mereka mengidentifikasi kekurangan signifikan dalam algoritma yang ada.

Carlos mengusulkan penulisan ulang radikal menggunakan Prolog, bahasa pemrograman yang terkenal karena kemampuannya menangani penalaran simbolis dan hubungan yang kompleks. Sifat deklaratif Prolog membuatnya sangat cocok untuk menganalisis berbagai definisi konten berbahaya.

Untuk memperkuat pemahaman kontekstual algoritme, perombakan ini menggabungkan beragam kumpulan data, termasuk Wikipedia, teks keagamaan, dan ensiklopedia. Dengan pendekatan multi-aspek ini, Carlos bertujuan untuk memastikan inklusivitas budaya dan kontekstual. Namun, pendekatan ini juga memerlukan sumber daya komputasi yang besar.

Terkait: Langkah Zuckerberg untuk Menghentikan Pengecekan Fakta Dipuji oleh Trump dan Musk, Kritikus Terkejut

Carlos menjelaskan bagaimana metrik biaya internal Meta, yang secara lucu disebut sebagai “Tahun Guatemala”(setara dengan PDB Guatemala), digunakan untuk membenarkan biaya komputasi.

Algoritme yang diperbarui dirancang untuk memproses jutaan postingan setiap hari, menganalisis kontennya berdasarkan analisis topologi moral yang sangat rinci. Menurut Carlos, tujuannya adalah untuk menciptakan sistem yang tidak memihak yang mampu mengkategorikan materi berbahaya secara akurat. Ia memastikan bahwa sistem tersebut berfungsi tanpa bias dan beroperasi secara ketat sesuai dengan aturan yang diprogram untuk dipatuhi.

Saat AI Beralih ke Dalam

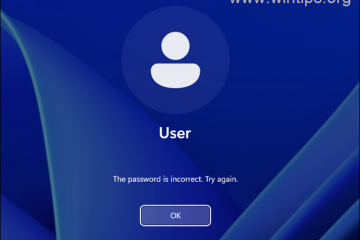

Selama uji coba besar pertamanya, algoritme yang diperbarui menandai pernyataan misi Meta sebagai konten berbahaya

Debugging tidak menunjukkan adanya kesalahan logika. Sebaliknya, analisis lanjutan sistem ini mengidentifikasi adanya korelasi yang tinggi antara istilah “Meta” dan frasa yang terkait dengan “terorisme” dan “penjangkauan perusahaan yang berlebihan”. Hasil yang tidak terduga ini menyoroti tantangan dalam melatih sistem AI untuk menavigasi konsep-konsep ambigu seperti moralitas dan bahaya.

Seperti yang ditulis Carlos, pernyataan yang ditandai ini segera memicu diskusi internal. Beberapa insinyur memuji ketelitian algoritma ini, sementara yang lain khawatir tentang potensi dampak buruk pada hubungan masyarakat. Seorang manajer senior dilaporkan mengatakan kepada Carlos: “Lihat, ini… mengesankan, tetapi kami tidak dapat mencapai OKR seperti ini.”menyoroti ketegangan dan kesenjangan yang semakin besar antara akurasi teknis dan prioritas organisasi.

Dampaknya: Etika dan NDA

Insiden ini meningkat ketika Carlos mempresentasikan temuannya dalam rapat tim. Meskipun menunjukkan logika di balik keputusan algoritme, pekerjaan karyawan tersebut mendapat perlawanan dari atasan.Sebentar lagi setelah itu, dia dipecat dan diminta untuk menandatangani “NDA ganda,” sebuah mekanisme hukum yang tidak jelas yang dirancang untuk menegakkan kerahasiaan yang ketat.

NDA ganda, juga dikenal sebagai perjanjian bilateral atau mutual NDA, adalah perjanjian yang mengikat secara hukum di mana kedua pihak yang terlibat mengungkapkan informasi rahasia satu sama lain dan setuju untuk melindungi informasi tersebut dari pengungkapan lebih lanjut.

Carlos menulis bahwa pengacaranya menyarankan bahwa perjanjian tersebut dapat membatalkan satu sama lain, sehingga memungkinkan karyawan untuk mendiskusikan pengalaman mereka secara publik. Saat merenungkan pemecatannya, ia menulis, “Mengingat mereka memecat saya karena mengatakan beberapa kebenaran, saya pikir saya berhutang cerita lengkap kepada internet.”

Peran AI dalam Moderasi

Alat moderasi konten Meta merupakan bagian integral dalam mengelola sejumlah besar konten buatan pengguna di platformnya. Ketergantungan perusahaan pada AI telah menjadi kebutuhan dan sumber kontroversi, dengan para kritikus menunjuk pada contoh-contoh penjangkauan yang berlebihan atau sumber kontroversi. tindakan yang tidak memadai terhadap materi berbahaya.

Insiden ini menambah pengawasan, menimbulkan pertanyaan tentang transparansi dan akuntabilitas dalam pengambilan keputusan AI. Di sisi lain, kritikus Meta mungkin menafsirkannya sebagai tanda efisiensi algoritme. p>

Mungkin praktik dan bias ideologi Meta sebenarnya mirip dengan organisasi teroris dan algoritmenya tepat? Tanpa detail teknis, kita hanya bisa menebaknya. Namun bagi Carlos, hasil ini mengakhiri awal yang sulit di perusahaannya.

Sebagai Carlos juga menulis, kacamata augmented reality Meta telah digunakan selama proses wawancara ketika pengembang yang terlibat mengandalkan kacamata tersebut untuk memecahkan tantangan pengkodean, mengoreksi dan meningkatkan solusi yang diusulkan Carlos. Dia kemudian menghadapkan pewawancara dengan temuannya dan bahkan menggunakan kejadian ini untuk menawar gaji yang lebih tinggi ketika memulai di Meta, sebenarnya memerasnya.

Selain cerita sampingan ini, pengalaman Carlos menyoroti konsekuensi yang tidak diinginkan sistem AI dan menyoroti kesulitan algoritma pemrograman untuk memahami dan menerapkan berbagai konsep manusia seperti bahaya, moralitas, dan keselamatan.

Pernyataan misi yang ditandai mungkin merupakan anomali atau sama persis. Apapun masalahnya, Meta pasti tidak akan memperdalam hal ini.