Apple mempercepat ambisi kecerdasan buatan (AI) dengan mengintegrasikan chip Trainium2 AWS ke dalam proses pra-pelatihan AI-nya.

Selama konferensi AWS re:Invent pada tanggal 4 Desember, Benoit Dupin, direktur senior mesin Apple pembelajaran dan AI, dibahas evaluasi awal perusahaan terhadap perangkat keras AWS. “Pada tahap awal evaluasi Trainium2, kami mengharapkan peningkatan efisiensi hingga 50% dengan pra-pelatihan,” kata Dupin kepada penonton dalam penampilan singkat di atas panggung.

Kemitraan ini menggarisbawahi hubungan yang lebih dalam antara Apple dan AWS, dengan raksasa teknologi ini mengandalkan UltraServers yang didukung Trainium2 untuk meningkatkan operasi AI-nya sekaligus mengoptimalkan efisiensi dan biaya.

Apple dan AWS bersifat Jangka Panjang Mitra

Penggunaan infrastruktur AWS oleh Apple bukanlah hal baru. Perusahaan ini telah memanfaatkan chip AWS seperti Graviton dan Inferentia selama lebih dari satu dekade untuk mendukung produk dan layanan utama, termasuk Siri, Apple Maps, dan Apple Music.

Kemampuan AWS untuk mendukung beban kerja AI berskala besar menjadikannya mitra penting bagi Apple. Seperti yang dikatakan Dupin, “Kami memiliki hubungan yang kuat, dan infrastrukturnya pun demikian keduanya dapat diandalkan dan mampu melayani pelanggan kami di seluruh dunia.”

Penambahan Trainium2 ke perangkat AI Apple mencerminkan komitmen kedua perusahaan untuk mendorong batasan efisiensi dan skalabilitas AI.

Chip Trainium2 dan UltraServers: Memenuhi Kebutuhan AI Modern

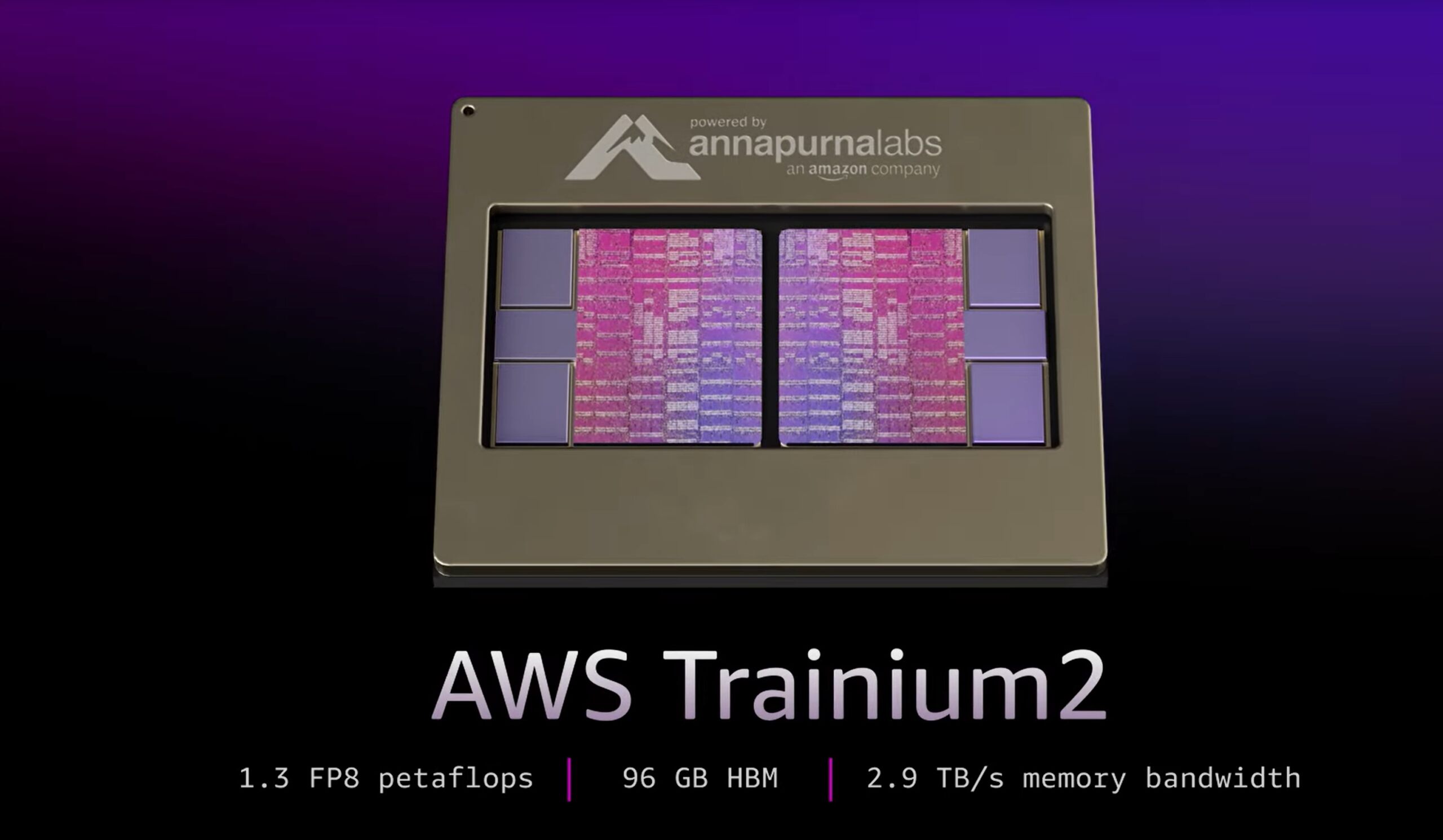

AWS meluncurkan chip Trainium2 dan Trn2 UltraServers kemarin, menandai tonggak penting dalam pengembangan perangkat keras AI. Chip Trainium2 menghadirkan komputasi FP8 padat hingga 20,8 petaflops per instans dan dirancang untuk menangani peningkatan permintaan komputasi model AI dengan triliun parameter.

Trn2 UltraServers, yang dilengkapi 64 chip Trainium2, dapat mencapai hingga 83,2 petaflops kinerja FP8 yang jarang. Hal ini dimungkinkan oleh interkoneksi NeuronLink milik AWS, yang memastikan komunikasi berlatensi rendah dan bandwidth tinggi di seluruh sistem terdistribusi.

David Brown, Wakil Presiden Komputasi dan Jaringan AWS, menekankan potensi transformatif Trainium2: “ Trainium2 adalah chip AWS dengan performa tertinggi yang pernah dibuat hingga saat ini. Dan dengan model yang mendekati triliunan parameter, kami tahu pelanggan memerlukan pendekatan baru untuk melatih dan menjalankan model besar tersebut.”

AWS mendemonstrasikan kemampuan Trainium2 dengan menjalankan model Llama 405B dari Meta, yang mencapai perolehan token tiga kali lebih tinggi throughput dibandingkan penawaran pesaing dari penyedia cloud lainnya. Terobosan ini menjawab kebutuhan penting akan pembuatan teks, ringkasan, dan inferensi real-time yang lebih cepat.

Apple Intelligence dan Multi-Cloud Pendekatan

Strategi AI Apple berkisar pada platform AI generatifnya, Apple Intelligence, yang mendukung fitur-fitur seperti pemrosesan bahasa alami di Siri, ringkasan notifikasi tingkat lanjut, dan alat kreatif seperti pembuatan emoji.

Apple Intelligence beroperasi pada model hibrid, memanfaatkan komputasi pada perangkat melalui chip seri M untuk privasi dan efisiensi, sekaligus mengandalkan infrastruktur cloud untuk beban kerja yang kompleks.

Pendekatan multi-cloud ini mencakup keduanya AWS dan Google Cloud. Awal tahun ini, Apple mengonfirmasi penggunaan chip Google TPU untuk melatih komponen Intelijen Apple. Strategi yang terdiversifikasi ini memungkinkan Apple mengoptimalkan beban kerja tertentu berdasarkan kekuatan masing-masing platform.

Dengan Trainium2, AWS memberikan alternatif hemat biaya dibandingkan GPU Nvidia, sehingga Apple dapat menskalakan operasi AI-nya tanpa mengorbankan performa.

Terkait: Perombakan AI Apple Siri Tergelincir hingga 2026 seiring Gemini dari Google yang Memimpin

Project Rainier: Kolaborasi AWS dengan Anthropic

Ambisi AI AWS yang lebih luas mencakup Project Rainier, kemitraan dengan Anthropic untuk mengembangkan salah satu klaster komputasi AI terbesar di dunia. Dilengkapi ribuan chip Trainium2, Project Rainier dirancang untuk memberikan skalabilitas yang belum pernah terjadi sebelumnya untuk AI generatif.

Anthropic, perusahaan di balik model bahasa Claude 3.5 Sonnet, berencana menggunakan cluster tersebut untuk menskalakan pelatihan modelnya hingga lima kali lipat. Investasi AWS di Anthropic, yang kini berjumlah $8 miliar, menegaskan komitmennya untuk mendorong inovasi dalam infrastruktur AI.

Dengan mendukung Apple dan Anthropic, AWS menunjukkan kemampuannya untuk memenuhi beragam beban kerja AI, mulai dari pra-pelatihan hingga nyata-inferensi waktu.

AWS Trainium3 dan Masa Depan Perangkat Keras AI

AWS sudah menantikan chip generasi berikutnya, Trainium3, dijadwalkan dirilis pada akhir tahun 2025. Dibangun dengan proses tiga nanometer, Trainium3 menjanjikan peningkatan kinerja empat kali lipat dibandingkan Trainium2. Pengembangan ini akan memungkinkan model AI yang lebih besar dan waktu pelatihan yang lebih cepat, sehingga memperkuat posisi AWS sebagai pemimpin dalam perangkat keras AI.

Ultracluster, superkomputer berbasis Trainium3, akan semakin meningkatkan kemampuan AWS. AWS menggambarkannya sebagai cluster komputasi AI terbesar di dunia, yang mampu menangani model triliunan parameter dengan efisiensi tak tertandingi.

Kemajuan ini mencerminkan visi strategis AWS untuk menantang dominasi Nvidia di pasar perangkat keras AI, yang ditawarkan kepada perusahaan seperti Apple dan Solusi antropik yang hemat biaya dan terukur yang disesuaikan dengan kebutuhan mereka.

Pergeseran Industri Menuju Silikon Khusus

Adopsi chip AWS Trainium2 oleh Apple adalah bagian dari upaya tren industri yang lebih luas terhadap silikon khusus untuk beban kerja AI. Perusahaan semakin beralih dari solusi tradisional berbasis GPU dan beralih ke perangkat keras yang dirancang khusus untuk aplikasi AI.

Pendekatan terintegrasi AWS, yang menggabungkan perangkat keras seperti Trainium2 dengan alat seperti Neuron SDK, memposisikannya sebagai alternatif yang layak ke Nvidia. Dengan berinvestasi pada silikon khusus, Apple dan AWS mendorong inovasi dalam infrastruktur AI, membuka jalan bagi solusi yang lebih efisien dan terukur.