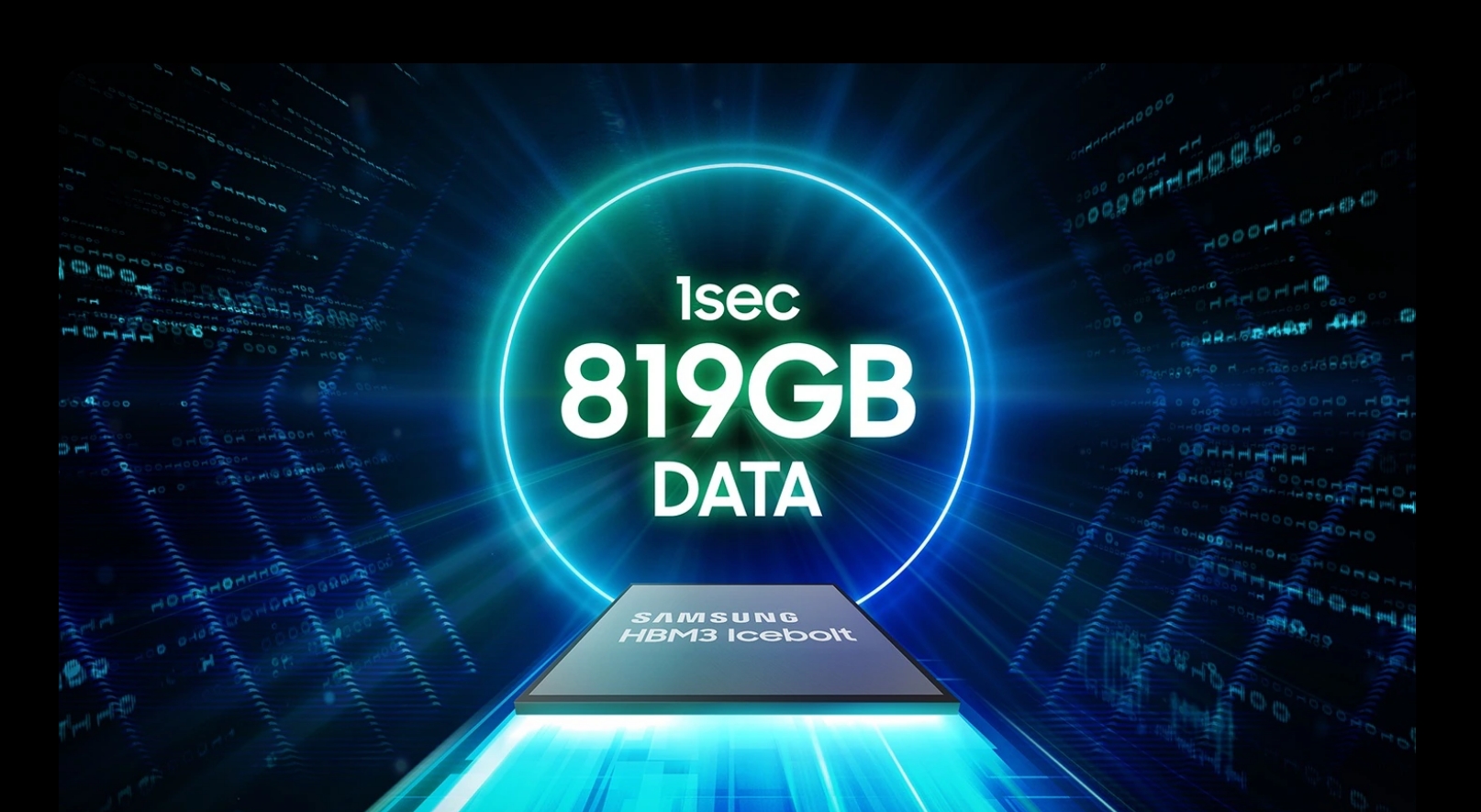

Chip DRAM HBM3 Samsung, dirancang untuk digunakan pada akselerator AI Nvidia, mengalami masalah kinerja selama pengujian. Kekhawatiran utama berkisar pada pembangkitan panas yang berlebihan dan konsumsi daya yang tinggi, yang menimbulkan keraguan tentang kesesuaiannya untuk kebutuhan komputasi performa tinggi Nvidia. HBM adalah singkatan dari High Bandwidth Memory, menggunakan desain chip yang menyediakan bandwidth lebih tinggi dibandingkan modul DDR4 atau GDDR5 namun menggunakan lebih sedikit daya dan dalam faktor bentuk yang jauh lebih kecil. Hal ini dicapai dengan menumpuk hingga delapan DRAM mati dan dadu dasar opsional yang dapat mencakup sirkuit penyangga dan logika pengujian.

Masalah Konsumsi Panas dan Daya

Masalah konsumsi panas dan daya yang dilaporkan tidak hanya terjadi pada chip HBM3 saja. Chip HBM3E Samsung yang dipamerkan beberapa bulan lalu juga mengalami masalah serupa. Masalah ini menjadi jelas ketika hasil chip HBM3E 8-lapisan dan 12-lapisan Samsung dirilis pada bulan April 2024.

Sebaliknya, SK Hynix mulai memasok chip HBM3E ke Nvidia pada bulan Maret 2024, memposisikan dirinya sebagai pemain kunci di pasar HBM. SK Hynix saat ini merupakan pemasok chip HBM terbesar bagi Nvidia, yang penting untuk berfungsinya akselerator AI. Dominasi Nvidia di pasar AI, dengan pangsa 80%, menjadikan sertifikasinya penting bagi produsen chip HBM mana pun.

Upaya Pengoptimalan Samsung

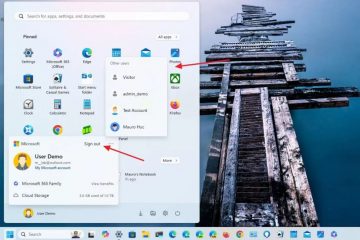

Samsung telah menyadari perlunya pengoptimalan seiring dengan kebutuhan pelanggan. Perusahaan telah bekerja sama dengan klien untuk mengatasi masalah ini dan telah berusaha selama lebih dari setahun untuk lulus pengujian ketat Nvidia. Perubahan kepemimpinan Samsung baru-baru ini, termasuk penunjukan mantan ahli dalam pengembangan DRAM dan NAND flash, menggarisbawahi komitmen Samsung untuk menyelesaikan tantangan-tantangan ini.

Sertifikasi dari Nvidia sangat penting untuk ambisi Samsung di pasar HBM. Masalah panas dan konsumsi daya yang belum terselesaikan telah membayangi prospek Samsung. Masih belum pasti apakah permasalahan ini dapat diatasi dengan segera. Dukungan CEO Nvidia Jensen Huang terhadap chip memori HBM3E 12H (12 lapis) Samsung pada konferensi GTX AI 2024, di mana ia menulis “Jensen Approved”pada chip tersebut, menyoroti pentingnya kemitraan ini.

Kemampuan Samsung untuk mengatasi tantangan-tantangan ini tidak hanya penting bagi bisnisnya tetapi juga bagi industri yang lebih luas. Baik AMD maupun Nvidia ingin agar Samsung menyelesaikan masalah ini guna memastikan pasokan chip HBM yang stabil dari berbagai vendor, yang akan membantu menjaga harga tetap kompetitif.. Samsung telah memasok chip HBM ke AMD, yang semakin menekankan perlunya solusi memori yang andal dan efisien.

Samsung berencana memulai produksi massal chip HBM3E sebelum akhir kuartal kedua tahun ini upaya untuk mengoptimalkan chip HBM melalui kolaborasi dengan pelanggan mencerminkan tekadnya untuk mengamankan pijakan di pasar perangkat keras AI yang kompetitif. Hasil dari upaya ini akan berdampak signifikan pada lanskap akselerator AI dan komputasi berkinerja tinggi di masa depan.