Perangkat lunak TensorRT-LLM sumber terbuka baru NVIDIA, yang dijadwalkan dirilis dalam beberapa minggu mendatang, telah menunjukkan peningkatan kinerja yang signifikan. Dalam pengujian menggunakan model GPT-J 6B, sistem yang diperbarui menunjukkan peningkatan kinerja delapan kali lipat dibandingkan A100, sebuah lompatan signifikan dari keunggulan empat kali lipat sebelumnya. Selain itu, ketika dievaluasi pada Llama2 LLM Meta, H100 yang disempurnakan dengan TensorRT-LLM melampaui A100 dengan faktor 4,6, peningkatan yang nyata dari 2,6 kali sebelum pembaruan.

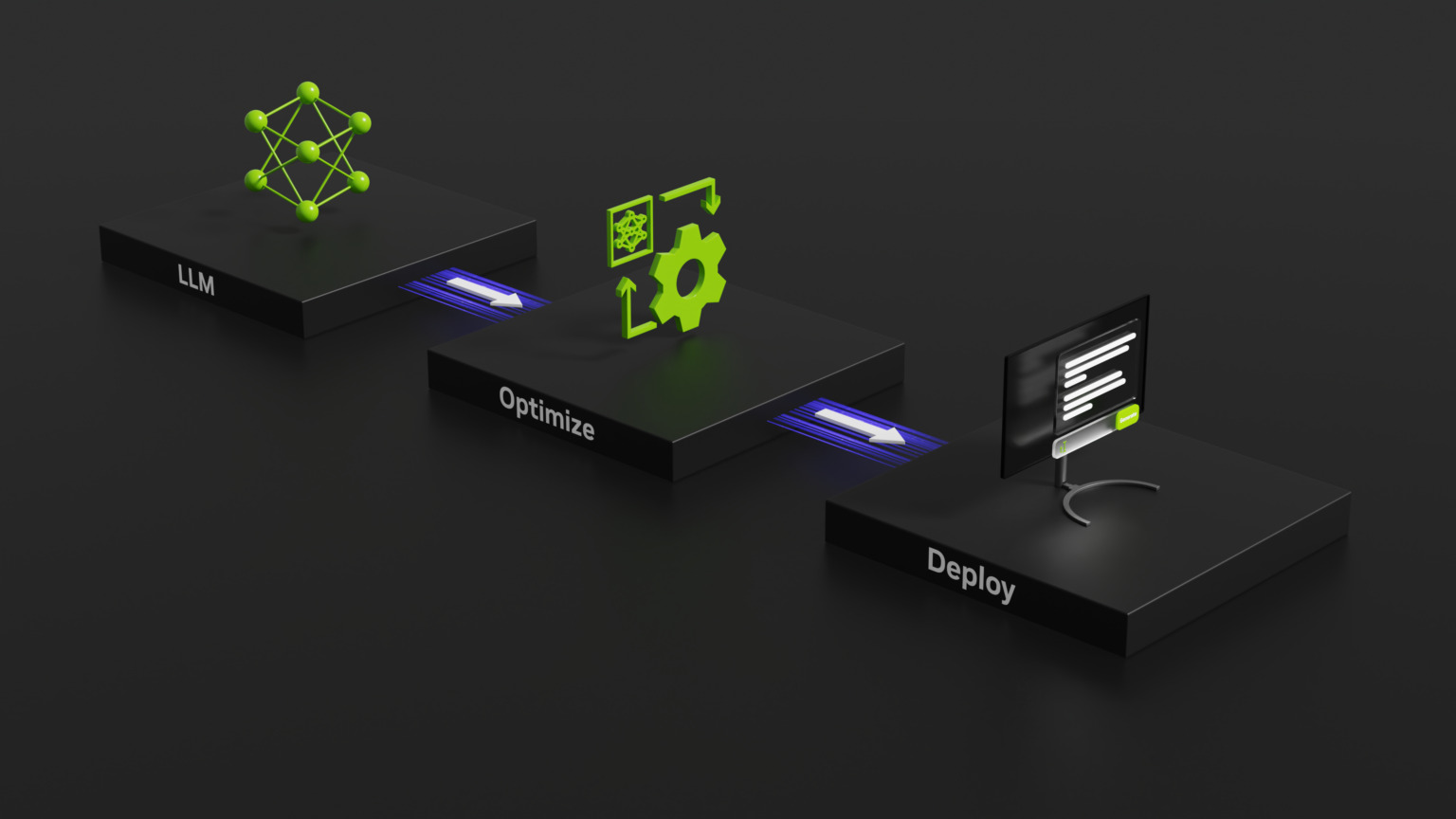

Dalam upaya untuk meningkatkan kinerja Model Bahasa Besar (LLM), NVIDIA baru-baru ini memperkenalkan TensorRT-LLM, sebuah perpustakaan sumber terbuka yang dirancang untuk meningkatkan kinerja Model Bahasa Besar (LLM) pada perangkat keras NVIDIA.

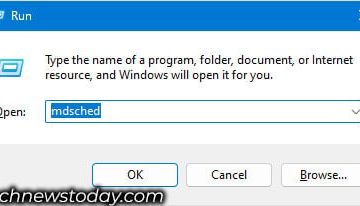

TensorRT-LLM adalah perpustakaan sumber terbuka yang beroperasi pada GPU NVIDIA Tensor Core. Fungsi utamanya adalah menawarkan lingkungan kepada pengembang untuk bereksperimen dan membangun model bahasa besar baru, yang menjadi landasan platform AI generatif seperti ChatGPT. Perangkat lunak ini berfokus pada inferensi, yang menyempurnakan proses pelatihan AI, membantu sistem memahami cara menghubungkan konsep dan membuat prediksi.

Baru saja diumumkan – NVIDIA TensorRT-LLM meningkatkan model bahasa besar #inference pada GPU NVIDIA H100 Tensor Core. #LLM https://t.co/jMX0EDxkXJ

— Pengembang AI NVIDIA (@NVIDIAAIDev) 8 September 2023

Teknik Inovatif di Balik Peningkatan

Tantangan model bahasa besar (LLM) terletak karena keserbagunaannya, sehingga sulit untuk mengelompokkan permintaan dan mengeksekusinya secara bersamaan. NVIDIA dan partnernya mengatasi tantangan ini dengan mengintegrasikan TensorRT-LLM dengan metode penjadwalan canggih yang disebut “in-flight batching”. Pendekatan inovatif ini memungkinkan pembuatan teks disegmentasi menjadi beberapa subtugas.

Pada dasarnya, sistem dapat memproses batch baru dari berbagai permintaan secara bersamaan, daripada menunggu satu batch selesai. TensorRT-LLM mencakup compiler deep learning TensorRT, kernel yang dioptimalkan, langkah pra dan pasca pemrosesan, serta memfasilitasi komunikasi di beberapa GPU dan node. Hal ini menghasilkan dalam performa tak tertandingi pada GPU NVIDIA, memungkinkan eksperimen model bahasa besar yang baru, penyesuaian cepat, dan performa puncak.

Membandingkan Keunggulan dan Prospek Masa Depan

Rahmat GH200 dari NVIDIA Hopper Superchip, yang menggabungkan GPU Hopper dengan Grace CPU, telah menunjukkan hasil yang mengesankan dalam tolok ukur industri MLPerf terbaru. Superchip tersebut, bersama dengan GPU H100, memimpin dalam semua pengujian pusat data MLPerf, termasuk visi komputer, pengenalan suara, medis pencitraan, dan tugas yang lebih menuntut dari sistem inferensi dan rekomendasi LLM. Selain itu, NVIDIA telah mengumumkan pembaruan perangkat lunak mendatang yang akan semakin meningkatkan kemampuan inferensi AI pada GH200 Grace Hopper Superchip miliknya.

AI adalah area pertumbuhan utama bagi Nvidia dan perusahaan sudah merasakan manfaatnya. peran utama di pasar. Analisis terbaru mengungkapkan bahwa Nvidia memperoleh keuntungan hampir 1.000% pada setiap GPU Tensor Core H100 yang dijualnya. Analisis keuangan dari Raymond James, sebuah perusahaan jasa keuangan terkemuka, dibagikan di Barron’s, memperkirakan biaya produksi salah satu GPU tersebut sekitar $3.320. Sebaliknya, harga jual Nvidia untuk GPU ini berfluktuasi antara $25.000 dan $30.000, bergantung pada volume pesanan.