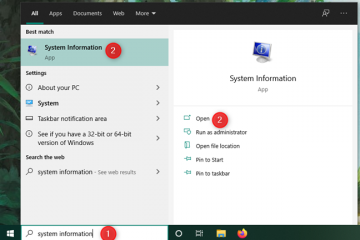

Kuaishou, platform video pendek terkemuka yang berbasis di Beijing, meluncurkan model bahasa besar yang dikembangkan sendiri bernama KwaiYii kepada publik minggu lalu, menurut laporan dari TechNode. Selain itu, perusahaan juga meluncurkan penelitiannya terhadap Spiking Neural Networks dan pengembangan SpikeGPT.

Rilis ini hadir setelah fase pengujian beta untuk layanan mirip ChatGPT untuk perangkat Android yang dimulai pada 18 Agustus. Layanan dialog, yang menawarkan 13 miliar parameter yang di-root di KwaiYii, menyaingi OpenAI GPT-3.5 dalam kapasitasnya untuk pembuatan konten, konsultasi, dan pemecahan masalah.

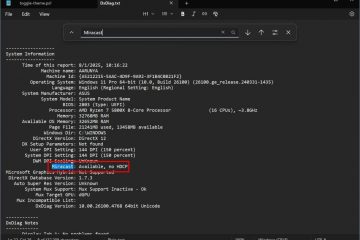

LLM dirinci di halaman GitHub KwaiYii. Aplikasi utama chatbot AI Kuaishou adalah pencarian, memanfaatkan konten asli dari platform untuk mengatasi “halusinasi” AI – ketidakakuratan akibat pelatihan data yang tidak memadai.

SpikeGPT: Lompatan dalam Efisiensi Energi

Kuaishou memposisikan dirinya sebagai kekuatan utama dalam Penelitian dan pengembangan AI, baik dalam produk arus utama publik maupun proyek R&D. KwaiYii adalah contoh AI publik arus utama, sementara Kuaishou juga minggu ini membahas SpikeGPT, contoh upaya penelitian AI-nya.

Tuntutan komputasi model bahasa besar kontemporer (LLM) sangat penting. Namun, Spiking Neural Networks (SNN) telah diidentifikasi sebagai lebih banyak energi-alternatif efisien untuk jaringan saraf tiruan konvensional, meskipun kemanjurannya dalam tugas pembuatan bahasa masih belum dipetakan.

Kolaborasi penelitian antara University of California dan Teknologi Kuaishou telah memperkenalkan SpikeGPT (melalui Ulasan yang Disinkronkan), pengukuhan model bahasa generatif spiking neural network (SNN). Model ini, dengan versi parameter 260M-nya, cocok dengan performa jaringan neural dalam (DNN ) dengan tetap mempertahankan manfaat hemat energi dari komputasi berbasis lonjakan.

SpikeGPT adalah model bahasa generatif yang dicirikan oleh unit aktivasi spiking berbasis biner murni. Ini mengintegrasikan perulangan ke dalam blok transformator, membuatnya kompatibel dengan SNN. Integrasi ini tidak hanya menghilangkan kompleksitas komputasi kuadratik tetapi juga memfasilitasi representasi kata sebagai lonjakan yang digerakkan oleh peristiwa.

Model ini dapat memproses streaming data kata demi kata, memulai komputasi bahkan sebelum pembentukan kalimat lengkap, sambil tetap menangkap dependensi jarak jauh dalam struktur sintaksis yang rumit. Tim peneliti juga menggabungkan berbagai teknik untuk meningkatkan performa SpikeGPT, seperti langkah penyematan biner, operator token shift, dan vanilla RWKV untuk menggantikan mekanisme perhatian diri tradisional.

Memahami Spiking Neural Networks

Spiking neural network (SNNs) adalah jenis jaringan saraf tiruan yang terinspirasi oleh cara kerja neuron biologis. Dalam SNN, neuron berkomunikasi satu sama lain dengan mengirimkan lonjakan, yang merupakan semburan singkat aktivitas listrik. Lonjakan tidak terus menerus, melainkan terjadi pada interval waktu diskrit. Hal ini berbeda dengan jaringan syaraf tiruan tradisional, yang menggunakan nilai kontinu untuk merepresentasikan aktivasi neuron.

SNN memiliki beberapa keunggulan potensial dibandingkan jaringan syaraf tiruan tradisional. Pertama, mereka lebih hemat energi. Ini karena paku hanya dikirim saat diperlukan, bukan terus menerus. Kedua, SNN lebih realistis secara biologis. Ini menjadikannya pilihan yang baik untuk aplikasi yang membutuhkan realisme tingkat tinggi, seperti robotika dan pencitraan medis.

Namun, SNN juga memiliki beberapa tantangan. Salah satu tantangannya adalah mereka lebih sulit untuk dilatih daripada jaringan syaraf tiruan tradisional. Ini karena lonjakan adalah peristiwa diskrit, yang membuatnya sulit untuk mem-backpropagate kesalahan melalui jaringan. Tantangan lain adalah bahwa SNN tidak dipahami sebaik jaringan syaraf tiruan tradisional. Hal ini mempersulit perancangan dan pengoptimalan SNN untuk tugas tertentu.

Kinerja SpikeGPT

Dalam studi empiris, SpikeGPT dilatih dengan tiga skala parameter yang berbeda (parameter 45M, 125M, dan 260M) dan dibandingkan dengan baseline transformator seperti Reformer, Synthesizer, Linear Transformer, dan Performer menggunakan dataset Enwik8. Hasilnya mengungkapkan bahwa SpikeGPT memberikan hasil yang sebanding dengan operasi sinaptik (SynOps) 22 kali lebih sedikit.

Penelitian ini menggarisbawahi potensi pelatihan SNN besar untuk memanfaatkan kemajuan dalam transformer, menunjukkan pengurangan yang signifikan dalam tuntutan komputasi LLM dengan menerapkan aktivasi spiking yang digerakkan oleh peristiwa ke pembuatan bahasa. Para peneliti telah menyatakan niat mereka untuk terus menyempurnakan model mereka dan akan memperbarui makalah pracetak mereka sesuai dengan itu. Kode untuk SpikeGPT tersedia di GitHub proyek, dan makalah yang merinci model dapat diakses di arXiv.