A

A Microsoft hozzáadta a DeepSeek R1-et, a Kína-székhelyű DeepSeek által kifejlesztett úttörő AI-érvelési modellt az Azure AI Foundry platformjához annak ellenére, hogy a vállalat nem megfelelően fér hozzá-e az Openai API-adatainak.

A DeepSeek R1 integrálásáról szóló döntés a Microsoft felhőalapú kínálatába kérdéseket vet fel az AI adatbiztonsággal, a versenydinamikával és a szabályozási felügyeletgel kapcsolatban Kapcsolódó: Alibaba új QWEN 2,5-Max modellje a MEGESEK-t az AI Benchmarks-ban

The inclusion of DeepSeek R1 in Azure AI Foundry reflects Microsoft’s continued expansion of its AI ecosystem, which already features models from OpenAI, Meta, Mistral, and Cohere.

A Microsoft kijelentette, hogy a modell biztonsági értékeléseket végez, mielőtt elérhetővé tették volna a vállalati ügyfelek számára. A hivatalos nyilatkozatban Asha Sharma, a Microsoft AI platform alelnöke azt mondta: „A DeepSeek R1 vagy bármely más modell használatának egyik legfontosabb előnye az Azure AI Foundry-nál, hogy a fejlesztők kísérletezhessenek, iterálhassák és integrálhassák az AI-t. Munkafolyamataik.”

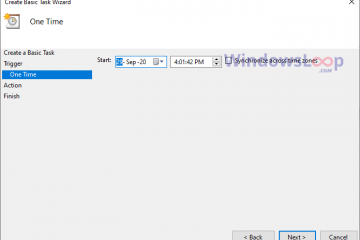

Forrás: Microsoft

Kapcsolódó: DeepSeek egy másik Openai-bustot dob el a Janus multimodális modellekkel, a Dall-E 3-at felülmúlva

A Microsoft is bejelentette. A DeepSeek R1 optimalizált verzióinak kiadása a Copilot+ PC-k számára, lehetővé téve a helyi végrehajtást a neurális feldolgozó egységeken (NPU). és az OpenAi szokatlan API-hozzáférési mintákat vizsgál meg

Míg a DeepSeek R1 műszaki képességeit széles körben dicsérték, a modell megvizsgálta a potenciális kapcsolatokat az Openai tulajdonosi adataival is.//www.bloomberg.com/news/articles/2025-01-29/microsoft-probing-if-deepseek-linked-group-improperly-obtained-openai-data”> a Bloomberg-re. Az Openai API-forgalom szokatlan tüskéjét észlelte, amely a Kínával 2024 végén kapcsolódó fejlesztői számlákból származik.

A jelentés aggodalmát fejezte ki amiatt Szükséges az alapítványmodell kidolgozásához a semmiből. Az OpenAi azonban elismerte, hogy aktívan felülvizsgálja az API-használati mintákat, és már bevezetett szigorúbb API-politikákat, hogy megakadályozzák a külső fejlesztők általi nagyszabású adatkivonást.

A vizsgálat folyamatban van, és az Openai nem jelezte, hogy jogi lépéseket tesz-e, vagy további korlátozásokat vezet be a modellekhez.

A DeepSeek R1 kiemelkedik az AI-iparban, mert képes magas érvelési teljesítményt elérni, miközben kevesebb számítási erőforrást használ, mint az Openai és a Google DeepMind versengő modelljei.

Ellentétben az Openai legújabb rendszereivel, amelyek kiterjedt GPU-klasztereket igényelnek, a DeepSeek R1-et a 2 048 NVIDIA H800 GPU-n képezték ki, amelynek célja az Egyesült Államok kereskedelmi korlátozásainak megfelelése az AI hardverkivitelének Kínába. A modell hatékonysága hozzájárult az NVIDIA részvényeinek ideiglenes csökkenéséhez, amely közel 600 milliárd dollárral esett vissza, amikor a befektetők újraértékelték a csúcskategóriás AI chipek iránti hosszú távú keresletet. Hardverfüggőség a modellképzéshez. Míg az olyan modellek, mint a GPT-4, hatalmas számítási infrastruktúrát igényeltek, a DeepSeek R1 azon képessége, hogy összetett érvelési feladatokat végezzen egy kisebb GPU lábnyomával, alternatív megközelítést javasol az AI képzéshez, amely a nagy teljesítményű modellek számára elérhetőbbé válhat a fejlesztők szélesebb körében.

Egyesült Államok. És az európai szabályozók a DeepSeek AI

A DeepSeek R1-et az adatbiztonsággal kapcsolatos aggodalmak és a nemzetközi adatvédelmi törvények betartása és az alkalmazott CCP cenzúra iránti aggodalmak miatt is felhívták a figyelmet a kormányzati ügynökségek és a szabályozó testületek miatt. Mint a 1989 Tiananmen tér tiltakozások és mészárlás vagy a kínai vezetés általában.

Az R1-et vizsgálják az általános adatvédelmi rendelet (GDPR) esetleges megsértése miatt. Az Olaszország adatvédelmi hatósága, Garante, felügyeletet indított arról, hogy a DeepSeek megfelelő biztosítékok vagy közzétételek nélkül továbbítja-e az európai felhasználói adatokat Kínába.

Ha a vizsgálat azt találja, hogy a DeepSeek nem teljesítette a GDPR követelményeit, a társaság bírsággal vagy korlátozásokkal kell szembenéznie az európai piacokon való működés képességére. Az AI tükrözi az Egyesült Államokon és Európán kívül kialakult AI modellek biztonságával és átláthatóságával kapcsolatos növekvő aggodalmakat. A a NewsGuard által végzett elemzés Megállapította, hogy a modell nehéz szűrést mutatott a politikailag érzékeny témákban. A Kínával kapcsolatos kérdések százaléka, különös tekintettel a kormányzásra, az emberi jogokra és a történelmi eseményekre. Ezenkívül a modell hiányos vagy félrevezető válaszokat adott a tényalapú hírfelsők 83 %-ában, és felveti a aggodalmakat, hogy moderálása összhangban áll-e a kínai kormányzati korlátozásokkal az információhozzáférésben. További tartalomcsökkentési intézkedéseket hajtson végre a DeepSeek R1 számára, mielőtt teljes mértékben integrálná azt az AI ökoszisztémájába. A Newsguard tanulmány eredményei azt sugallják, hogy a DeepSeek R1-et telepítő vállalkozásoknak tisztában kell lenniük a modell potenciális korlátaival az elfogulatlan információk szolgáltatásának képességében. Hivatalos és személyes környezet, hivatkozva a Kína adatpolitikájával kapcsolatos biztonsági kockázatokra. A lépés az amerikai védelmi ügynökségek szélesebb körű erőfeszítéseinek részét képezi, amelyek korlátozzák a külföldi fejlett AI rendszerek használatát az érzékeny műveletek során.

Míg a Microsoft hangsúlyozta, hogy a DeepSeek R1 átvette a biztonsági értékeléseket, mielőtt hozzáadta az Azure AI Foundry-hez, a folyamatban lévő szabályozási ellenőrzés azt sugallja, hogy a modellt használó vállalkozások továbbra is megfelelési kihívásokkal szembesülhetnek. > A Microsoft kibővítő AI modell portfóliója és annak kockázata

A DeepSeek R1 hozzáadásával az Azure AI Foundry-hez, a Microsoft tovább diverzifikálja AI-kínálatát, hogy több modellválasztékot biztosítson a vállalkozások számára.

A vállalat hangsúlyozta annak fontosságát, hogy az AI modellek széles skáláját támogassák, hogy a fejlesztők megválaszthassák a legmegfelelőbb technológiát sajátos igényeikhez. A DeepSeek R1 bevonása azonban, miközben az OpenAI nyomozás folyamatban van, kérdéseket vet fel a Microsoft AI partnerségének ellenőrzési folyamatával és a lehetséges adatbiztonsági kockázatok kezelésére irányuló megközelítésével kapcsolatban. A felhőalapú szolgáltatásokon tárolt AI modellek integritásának értékelésében szereplő szerep valószínűleg fokozott ellenőrzéssel szembesül.