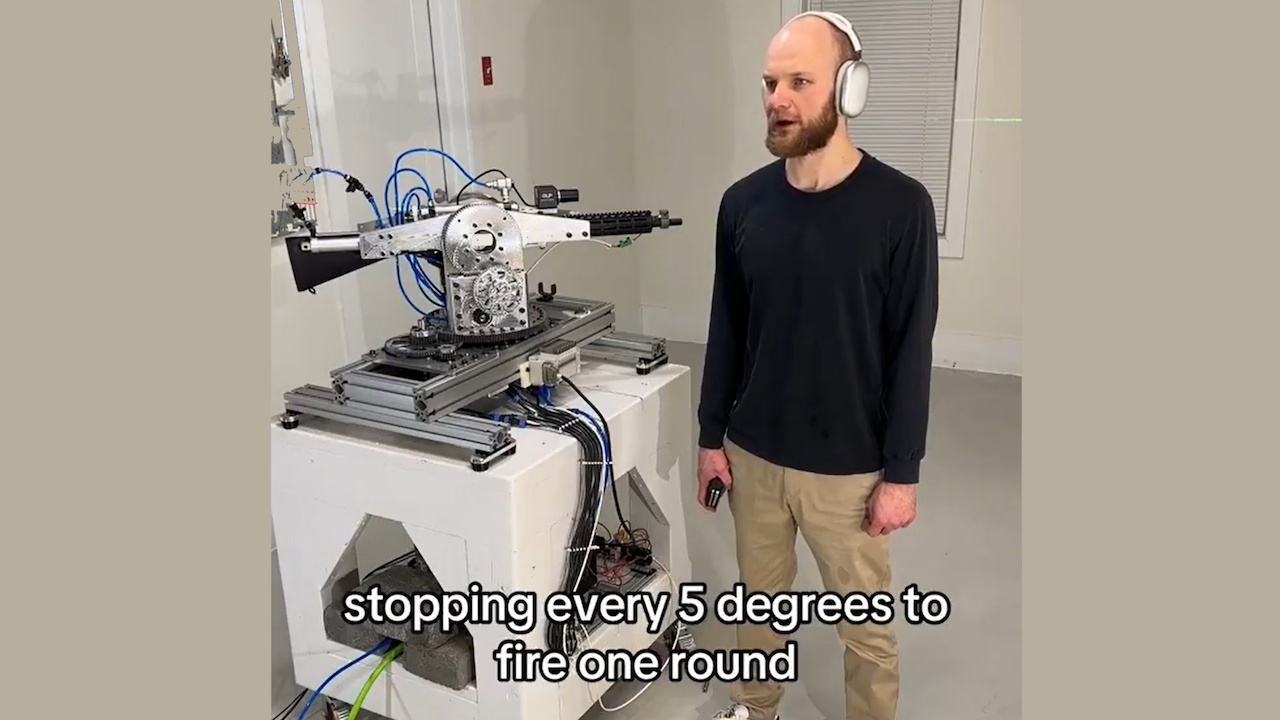

Az OpenAI visszavonta az API-hozzáférést egy fejlesztőtől, aki a Realtime API-ját használta autonóm puskarendszer működtetésére. A puskával felszerelt robottornyot magában foglaló projekt verbális parancsokat tudott értelmezni és szimulált tüzelési műveleteket végrehajtani.

Az incidens rávilágít az egyre növekvő aggodalmakra a mesterséges intelligenciával az autonóm fegyverek fejlesztése során történő esetleges visszaélésekkel kapcsolatban, ami kérdéseket vet fel a mesterséges intelligencia etikájával és a mesterséges intelligencia biztonságával kapcsolatban.

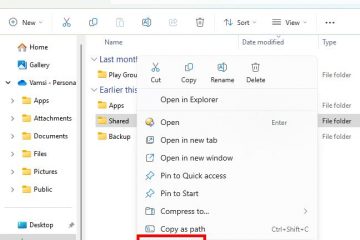

A fejlesztő, az interneten “STS Innovations LLC” megosztott online videókat a rendszerről, bemutatva annak működését. Az egyik klipben a fejlesztő kiadta a parancsot, „ChatGPT, támadás alatt állunk a bal elülső és a jobb elölről”, amire a torony azonnal reagált, forogva és meghatározott irányokba lövöldözve.

Cél/tűz szimuláció lézerrel #robotics #electronics

A szintetizált hang hozzátette: „Ha további segítségre van szüksége, csak szóljon.” A dermesztő bemutató rávilágított arra, hogy a fogyasztói minőségű mesterséges intelligencia eszközök hogyan illeszthetők könnyen potenciálisan káros felhasználásra.

Frissítés a nyomkövető rendszerről #robotics #vision #electronics

Az OpenAI Swift irányelveinek érvényesítése

Az OpenAI, amely szigorú politikáiról ismert technológiájának felhasználása ellen azonnal válaszolt. Egy szóvivő mondta a Futurismnak: „Proaktívan azonosítottuk irányelveink megsértését, és értesítettük a fejlesztőnek abba kell hagynia ezt a tevékenységet, mielőtt megkapja az Ön megkeresését.”

A vállalat hangsúlyozta, hogy tiltja eszközeinek felhasználását fegyverek létrehozására vagy működtetésére vagy olyan rendszerek automatizálására, amelyek kockázatot jelenthetnek a személyes életre. biztonság.

Visszaütés-kezelő rendszer, gyors bemutató #robotics #electronics #cnc

A Realtime API, egy olyan eszköz interaktív alkalmazások, lehetővé téve a fejlesztő számára, hogy a természetes nyelvi parancsokat a robottorony működőképes bemeneteivé alakítsa.

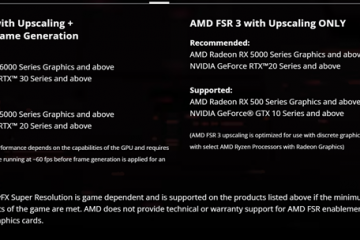

Míg az API hasznos felhasználási esetekre készült, például a hozzáférhetőség javítására vagy az ügyfelek interakcióinak javítására, ez a visszaélés a kettős felhasználású technológiák szabályozásának kihívásait mutatja.

Kapcsolódó: Az OpenAI és az Anduril Forge együttműködése az Egyesült Államok katonai drónvédelméért

Tágabb értelemben az AI és a Fegyverezés

Ez az eset újra felpörgette a vitákat az autonóm fegyverek etikájával kapcsolatban. Ezek a rendszerek, amelyek emberi felügyelet nélkül képesek a célpontok kiválasztására és bevonására, összetett jogi és erkölcsi kihívásokat jelentenek.

Az Egyesült Nemzetek Szervezete régóta szorgalmazza a mesterséges intelligencia szigorúbb szabályozását a hadviselésben, figyelmeztetve arra, hogy az autonóm rendszerek megsérthetik a nemzetközi törvényeket és csökkenthetik az elszámoltathatóságot.

Kapcsolódó: Anthropic Partnerek a Palantirral, az AWS az AI-vel az Egyesült Államok hírszerzésében és hadseregében

A Washington Post nemrégiben megjelent jelentése részletes aggasztó példák a mesterséges intelligencia katonai műveletekben történő alkalmazására, beleértve azokat az állításokat is, amelyek szerint Izrael mesterséges intelligenciát használt a bombázási célpontok kiválasztására.

A jelentés megjegyezte: „Bizonyos időkben az egyetlen megerősítésre volt szükség, hogy a célpont férfi volt.” Az ilyen esetek rávilágítanak az MI-re támaszkodó életre vagy halálra vonatkozó döntések kockázatára, valamint a válogatás nélküli döntésekre. erőszak.

Kapcsolódó: Green Beret ChatGPT-t használt a Cybertruck Blasthez, a rendőrség kiadta a csevegési naplókat

Az OpenAI szerepe a védelmi technológiákban

Míg az OpenAI betartja a fegyverkezést tiltó politikákat, az Anduril Industries-szel – egy mesterséges intelligencia által vezérelt védelmi megoldásokra szakosodott vállalattal – való együttműködése kérdéseket vet fel álláspontjával kapcsolatban/p>

Az együttműködés célja, hogy javítsa a harctéri intelligenciát és javítsa a drónvédelmi rendszereket azzal érvelnek, hogy hozzájárulnak az AI-technológiák szélesebb körű militarizálásához.

Az Egyesült Államok védelmi szektora, amelyet közel 1 billió dolláros költségvetés támogat, egyre inkább a fejlett technológiákra támaszkodik, hogy stratégiai előnyre tegyen szert a katonai alkalmazások rávilágítanak a technológiai innováció és az etikai szempontok egyensúlyának kihívásaira.

Kapcsolódó: Új Palantir-Anduril AI Konzorcium az Egyesült Államok védelmi adathiányainak leküzdésére

A barkácsolás fegyverezési és hozzáférhetőségi kockázatai

Az a könnyű, hogy az egyének visszaélhetnek a mesterséges intelligencia eszközökkel és más technológiákkal, például a 3D nyomtatási vegyületekkel, probléma. A bűnüldöző szervek már találkoztak barkácsfegyverkezési esetekkel, például Luigi Mangione állítólagos cselekedeteivel, aki állítólag 3D nyomtatott alkatrészeket használt lőfegyverek összeszereléséhez. Ezek a technológiák csökkentik az akadályokat az egyének előtt, hogy halálos potenciállal rendelkező autonóm rendszereket hozzanak létre.

Az STS 3D projektje bemutatja, hogyan lehet a hozzáférhető mesterséges intelligencia eszközöket nem kívánt célokra adaptálni. Az OpenAI határozott fellépése ebben az esetben megmutatja elkötelezettségét a visszaélések megelőzése mellett, de rámutat arra is, hogy nehéz teljes mértékben ellenőrizni, hogyan kerüljenek alkalmazásra technológiái, amint azok nyilvánosságra kerülnek.

Az incidens szélesebb körű kérdéseket vet fel a program irányításával kapcsolatban. AI technológiák. A szabályozás hívei hangsúlyozzák, hogy egyértelmű globális szabványokra van szükség annak biztosítására, hogy a mesterséges intelligencia fejlesztése összhangban legyen az etikai elvekkel. Az eltérő érdekekkel és prioritásokkal rendelkező nemzetek közötti konszenzus elérése azonban továbbra is ijesztő feladat.