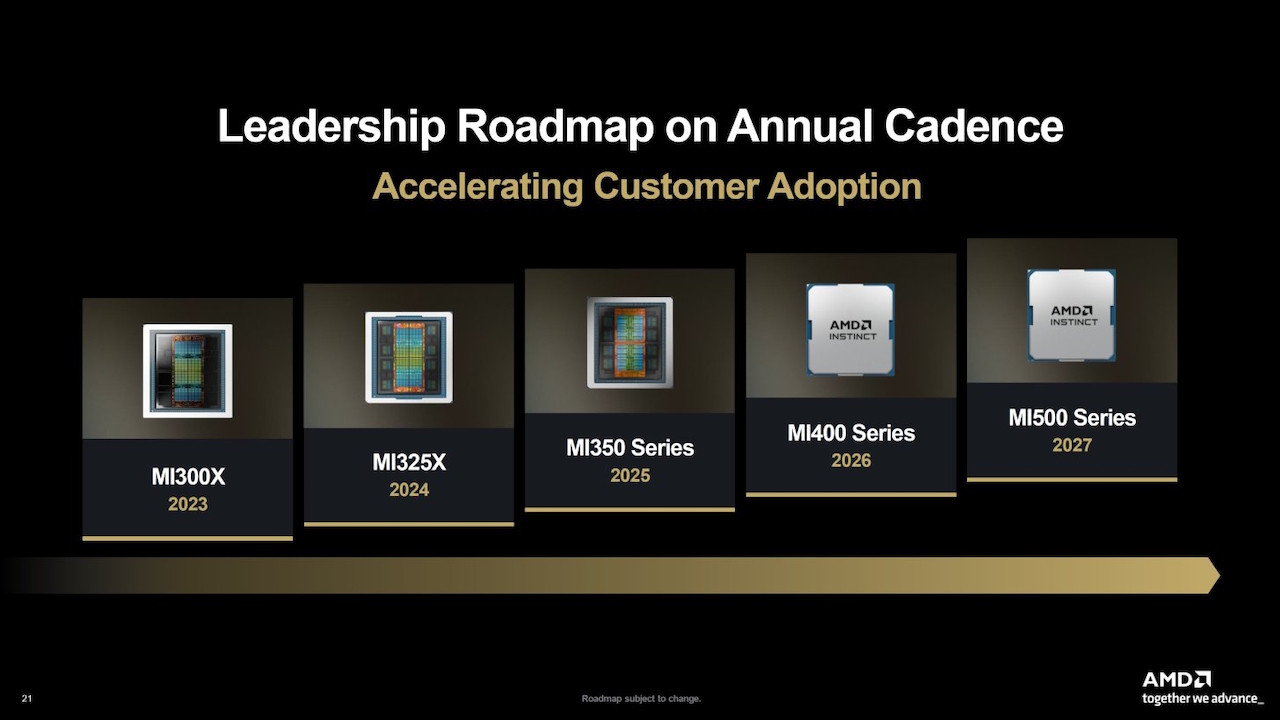

Dans la bataille pour la domination du calcul haute performance, AMD a officiellement dévoilé son accélérateur Instinct MI430X, un système de 432 Go conçu pour ancrer la prochaine génération de supercalculateurs occidentaux.

Révélée cette semaine, la nouvelle puce exploite l’énorme bande passante mémoire HBM4 pour cibler l’infrastructure « d’IA souveraine », sécurisant ainsi les déploiements clés aux États-Unis et en Europe. En donnant la priorité aux systèmes exascale soutenus par le gouvernement plutôt qu’aux ventes aux entreprises en général, AMD ouvre un front stratégique contre le leader du marché Nvidia, dont la propre feuille de route est confrontée à des vents contraires géopolitiques en Chine.

L’industrie s’efforce de briser l’emprise de Nvidia, avec Microsoft développant des outils pour combler le fossé logiciel CUDA. La dernière initiative d’AMD formalise sa réponse matérielle à ce défi, en offrant une alternative architecturale distincte aux pays cherchant à contrôler leur propre destin en matière d’IA.

HBM4 et la bande passante de 19,6 To/s Leap

AMD a officiellement détaillé l’Instinct MI430X cette semaine, le positionnant comme le produit phare de sa prochaine série MI400. Au cœur de la nouvelle architecture se trouve l’intégration de la mémoire HBM4, augmentant la capacité jusqu’à un énorme 432 Go par accélérateur.

Cette augmentation massive du débit est due à une explosion générationnelle de la bande passante mémoire, atteignant 19,6 To/s. Un tel chiffre représente une augmentation de plus de 3,2 fois par rapport aux 6,0 To/s du MI325X actuel, résolvant le principal goulot d’étranglement pour la formation de grands modèles de langage.

Mahesh Balasubramanian, directeur principal du marketing des produits GPU pour centres de données d’AMD, a déclaré dans un communiqué article de blog officiel selon lequel la nouvelle puce « inaugure une nouvelle ère de performances et d’efficacité pour l’IA à grande échelle et le calcul haute performance (HPC). »

Construit sur le « CDNA nouvelle génération » Architecture, largement appelée CDNA 5, le silicium est optimisé spécifiquement pour la convergence des charges de travail de calcul haute performance (HPC) et d’IA. Contrairement aux puces purement axées sur l’IA qui sacrifient la précision au profit de la vitesse, le MI430X conserve « un véritable support matériel FP64 », une exigence essentielle pour les simulations scientifiques qui exigent une précision double précision.

Balasubramanian a noté que « construits sur l’architecture AMD CDNA de nouvelle génération et prenant en charge 432 Go de mémoire HBM4 et 19,6 To/s de bande passante mémoire, ces GPU offrent des capacités de calcul extraordinaires », soulignant le double usage. nature de la conception.

AMD positionne l’appareil comme un moteur unifié pour les « usines d’IA », capable de gérer simultanément la formation, l’inférence et la modélisation traditionnelle sans nécessiter de clusters séparés.

L’efficacité énergétique reste un pilier central de la conception, bien que les chiffres spécifiques du TDP (Thermal Design Power) soient notamment absents de la divulgation. Le passage à HBM4 signale un pic de complexité de fabrication, nécessitant probablement des techniques d’emballage avancées pour gérer la densité thermique des piles de mémoire.

Le pivot de « l’IA souveraine »: sécuriser les superordinateurs occidentaux

En commercialisant la puce sous la bannière de « l’IA souveraine », AMD cible explicitement les projets d’infrastructure financés par le gouvernement aux États-Unis et en Europe. Une telle approche ciblée a déjà assuré au MI430X une place dans « Discovery », le prochain supercalculateur du Laboratoire national d’Oak Ridge (ORNL).

Selon l’annonce ORNL, Discovery est prévu pour livraison en 2028, soulignant les longs délais de livraison inhérents aux marchés publics à l’échelle gouvernementale. Balasubramanian a expliqué que « Discovery permettra aux chercheurs américains de former, d’affiner et de déployer des modèles d’IA à grande échelle tout en faisant progresser le calcul scientifique dans la recherche énergétique, la science des matériaux et l’IA générative. »

En Europe, la puce alimentera « Alice Recoque », le premier système de classe exascale français, construit en partenariat avec Eviden. Une annonce de partenariat stratégique a confirmé que le système utilisera la plate-forme BullSequana XH3500, combinant le MI430X avec les processeurs EPYC « Venice » de nouvelle génération d’AMD.

La concentration sur les contrats des gouvernements occidentaux fournit un plancher de revenus stable, isolant AMD de la volatilité du marché spot des entreprises. Géopolitiquement, cela contraste fortement avec la situation en Chine, où Pékin a interdit les puces étrangères des projets d’État, excluant ainsi AMD et Nvidia de ce marché souverain.

Simultanément, le gouvernement américain a récemment approuvé des approbations pour le Moyen-Orient, créant une carte géopolitique complexe où les marchés « souverains » sont strictement délimités par des alliances.

Réalité du marché : l’écart temporel et la CUDA. Moat

Bien que les spécifications soient impressionnantes, la fenêtre de lancement de 2026 place la série MI400 sur une trajectoire de collision avec la future architecture « Rubin » de Nvidia plutôt qu’avec la Blackwell d’aujourd’hui. A

Les dates de livraison du supercalculateur Discovery indiquent 2028, ce qui suggère un décalage important entre la disponibilité du silicium et le déploiement opérationnel à grande échelle. Les logiciels restent le principal obstacle, l’écosystème CUDA de Nvidia servant toujours de fossé défensif de l’industrie.

Les rapports suggèrent que Microsoft développe des outils de traduction pour combler cette lacune, permettant au code CUDA de s’exécuter de manière native sur le matériel AMD sans réécriture. Cependant, le géant de Redmond couvre également ses paris en octroyant une licence pour l’IP de silicium personnalisée d’OpenAI, signalant qu’il ne comptera pas uniquement sur AMD pour briser l’emprise de Nvidia.

Les marchés marchands du silicium sont également comprimés par Google, qui a récemment rendu son TPU Ironwood généralement disponible pour les clients du cloud.

La montée en puissance d’acteurs non traditionnels complique le paysage concurrentiel. Le PDG de Nvidia, Jensen Huang, a averti qu'”il est insensé de sous-estimer la puissance de la Chine et l’incroyable esprit de compétition de Huawei. Il s’agit d’une entreprise dotée d’une technologie extraordinaire”, reconnaissant que le marché se divise en fiefs régionaux.

Pour les entreprises clientes, le choix entre l’écosystème ouvert d’AMD et la pile intégrée de Nvidia se résume souvent à la « flexibilité de l’infrastructure » par rapport à la facilité d’utilisation immédiate. Avec le MI430X, AMD parie que la bande passante brute et la validation gouvernementale suffiront à faire pencher la balance.