Le développeur chinois d’IA DeepSeek a publié DeepSeek-V3.2-Exp, un modèle expérimental qu’il appelle une « étape intermédiaire » vers son architecture de nouvelle génération. La société basée à Hangzhou a annoncé lundi le modèle open source, révélant qu’il a été conçu pour tester une nouvelle méthode plus efficace pour traiter de longues séquences de texte.

La sortie est un moment charnière pour l’entreprise. ferme. Son modèle R2 très attendu a été retardé indéfiniment plus tôt cette année en raison de pénuries de matériel. Parallèlement, qui intensifie la guerre des prix de l’IA en Chine, DeepSeek a également annoncé qu’il réduira les prix de ses API. de plus de 50 %, exerçant une pression directe sur les concurrents nationaux.

Un saut expérimental avec l’attention éparse de DeepSeek

L’innovation principale de la V3.2-Exp est un mécanisme que la société appelle DeepSeek Sparse Attention (DSA).

En tant que version expérimentale, le nouveau modèle s’appuie sur son prédécesseur, V3.1-Terminus, dans le but spécifique d’explorer et de valider les optimisations pour l’efficacité de la formation et de l’inférence dans des scénarios à contexte long.

Selon la société, DSA atteint pour la première fois une attention clairsemée à granularité fine. Cette nouvelle architecture est conçue pour apporter des améliorations substantielles en termes d’efficacité informatique lors du traitement de séquences de texte étendues, un goulot d’étranglement majeur pour de nombreuses applications d’IA à grande échelle, tout en conservant une qualité de sortie de modèle pratiquement identique.

Pour prouver rigoureusement l’impact de la nouvelle architecture, DeepSeek a fait un choix stratégique pour éviter de courir après les scores des classements.

Au lieu de cela, l’équipe a délibérément aligné les configurations de formation de V3.2-Exp avec V3.1-Terminus. Les données de référence montrent que les deux modèles fonctionnent de manière presque identique lors des tests de raisonnement et de codage, isolant les gains d’efficacité comme seule variable.

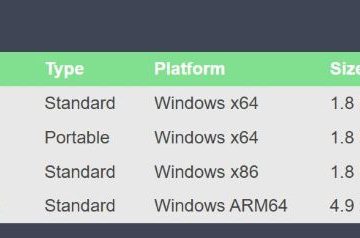

Le modèle est disponible sur la plateforme Hugging Face sous une licence permissive du MIT, encourageant une large diffusion adoption. DeepSeek a également publié des noyaux open source destinés à la fois à la recherche et à une utilisation hautes performances, ce qui témoigne d’un engagement fort à impliquer la communauté des développeurs dans ses innovations architecturales.

Un pivot stratégique après le blocage du modèle R2

Cette version expérimentale fait suite à une période de turbulences pour DeepSeek, marquant un pivot stratégique après le lancement de son modèle R2 de nouvelle génération. indéfiniment bloqué à la mi-2025.

Le retard était une conséquence directe de la guerre technologique entre les États-Unis et la Chine, qui a sévèrement restreint l’accès aux puces Nvidia hautes performances essentielles à la formation de l’IA avancée.

Le retard indéfini a marqué un renversement stupéfiant. Quelques mois auparavant, DeepSeek aurait accéléré la sortie de R2 pour déjouer ses concurrents. Cependant, cet élan s’est heurté à ce qui a été initialement décrit comme une crise à deux fronts : l’insatisfaction interne du PDG concernant les performances et le goulot d’étranglement matériel paralysant.

Des rapports ultérieurs en août ont confirmé que le problème principal était une défaillance technique persistante. La société n’a pas été en mesure de mener à bien une phase de formation utilisant les puces Ascend nationales de Huawei, ce qui a obligé un retour difficile au matériel Nvidia éprouvé pour la phase de formation intensive en calcul.

Ce revers met en évidence l’immense défi auquel les entreprises chinoises sont confrontées pour construire une pile logicielle sur du matériel national émergent et non éprouvé.

La crise matérielle a créé une ouverture significative permettant aux concurrents de gagner du terrain tandis que DeepSeek lutté. Le travail de l’entreprise reste également soumis à un examen géopolitique intense.

Un rapport cinglant du comité de la Chambre des représentants des États-Unis d’avril a qualifié l’entreprise de menace pour la sécurité, le président John Moolenaar déclarant: « DeepSeek n’est pas simplement une autre application d’IA, c’est une arme dans l’arsenal du Parti communiste chinois… »

La féroce guerre des prix de l’IA en Chine

Parallèlement Dans le communiqué technique, DeepSeek a annoncé une réduction spectaculaire des prix de ses API de « 50 %+ ». Ces prix agressifs visent directement les concurrents nationaux qui érodent leur part de marché. Cette décision intensifie une guerre des prix féroce qui a ébranlé le secteur chinois de l’IA.

La société répond à la pression de concurrents comme Z.ai (anciennement Zhipu), qui a lancé son puissant modèle GLM-4.5 en juillet avec une stratégie explicite visant à réduire les prix de DeepSeek.

Alibaba a également adopté une base plus commerciale avec son récent Qwen3-Max à source fermée. modèle.

Malgré ses récents obstacles de développement, la technologie de DeepSeek reste très recherchée. Dans le cadre d’une victoire importante, Tesla a annoncé en août qu’elle intégrerait l’IA de DeepSeek et Bytedance pour ses assistants vocaux embarqués sur le marché chinois critique, snobant ainsi l’IA Grok d’Elon Musk.

En open source un modèle axé sur l’efficacité tout en réduisant les prix, DeepSeek exécute une stratégie à plusieurs volets. Son objectif est de réengager la communauté des développeurs, de récupérer son avantage concurrentiel en termes de coûts et de signaler que son pipeline d’innovation est actif, même s’il fait face aux dures réalités de la guerre mondiale des puces.