En 2016, Geoffrey Hinton, pionnier de l’IA, a fait une prédiction audacieuse, déclarant que”les gens devraient arrêter de former des radiologues maintenant”. C’est un moment décisif qui semble annoncer la fin d’une spécialité médicale. Pourtant, près d’une décennie plus tard, la réalité sur le terrain raconte une tout autre histoire – du moins jusqu’à présent.

La demande de radiologues humains est en plein essor. En 2025, les programmes de résidence offraient un nombre record de postes, et moyenne les salaires ont grimpé de près de 50 % depuis 2015.

La profession même que l’IA était censée éliminer est plus vitale que jamais, avec des taux de postes vacants à des niveaux sans précédent.

Ce paradoxe révèle une leçon cruciale sur l’impact réel de la technologie. Même si les modèles d’IA de géants comme Microsoft peuvent atteindre une précision surhumaine dans des conditions de laboratoire stériles, ils ont du mal à naviguer dans les complexités de la pratique clinique réelle. Le chemin qui mène de l’algorithme à l’adoption est pavé d’obstacles pratiques, juridiques et éthiques.

Des benchmarks au chevet : la réalité de l’IA

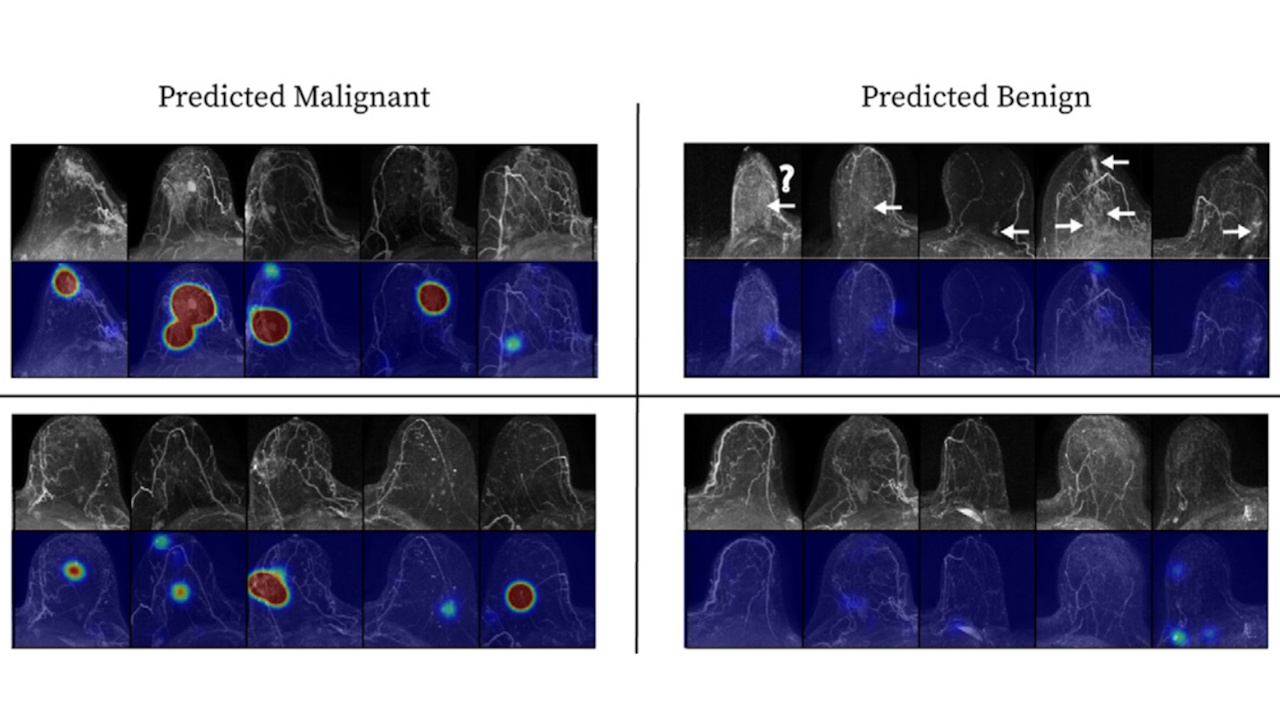

L’écart entre les performances d’une IA dans des benchmarks contrôlés et son efficacité dans le monde réel est le premier obstacle majeur. Les modèles sont souvent formés sur des images très soignées et sans ambiguïté, ce qui oriente leurs performances vers les cas les plus simples.

Ils échouent souvent lorsqu’ils sont confrontés à des présentations subtiles de maladies, à des scans flous ou à des images floues. variations dans les équipements d’imagerie-un problème connu sous le nom de défaillance hors distribution.

Cette fragilité est bien documentée. La précision d’une IA peut chuter jusqu’à 20 points de pourcentage lorsqu’elle est testée sur les données d’un nouvel hôpital.

Le processus de validation lui-même est souvent étroit ; une analyse de 2024 a révélé que 38 % des modèles examinés ont été testés sur les données d’un seul hôpital. établissement. Ce manque de contexte réel peut conduire à des erreurs absurdes, comme par exemple un modèle identifiant à plusieurs reprises à tort les agrafes chirurgicales comme des hémorragies cérébrales.

Ce n’est pas un problème nouveau. Dans les années 1990, les les premiers systèmes de diagnostic assisté par ordinateur (CAD) pour les mammographies ont été largement adoptés après avoir reçu l’approbation de la FDA en 1998 et le remboursement de Medicare en 2001.

En 2010, ils ont été utilisés dans près des trois quarts de toutes les projections. En pratique, cependant, ils ont échoué de façon spectaculaire. Une étude historique a révélé que les cliniques assistées par CAD effectuaient 20 % de biopsies en plus sans découvrir d’autres cancers.

L’une des principales raisons de cet échec était le biais d’automatisation : les médecins trop reporté à la machine. Un essai clinique de 2004 a révélé que, guidés par la coronaropathie, les spécialistes identifiaient à peine la moitié des tumeurs malignes, tandis que leurs pairs non assistés en détectaient 68 %. Cette expérience a conduit Medicare à retirer le remboursement supplémentaire pour la CAD en 2018, une leçon historique qui plane sur l’IA plus avancée d’aujourd’hui.

Une méta-analyse récente de l’Université métropolitaine d’Osaka confirme que cet écart de performance persiste. Après avoir examiné 83 études, les chercheurs ont découvert que même si l’IA générative est à égalité avec celle des non-spécialistes, elle est en retard de 15,8 % par rapport aux experts humains.

Comme l’a noté un médecin impliqué dans l’étude: « Cette recherche montre que les capacités de diagnostic de l’IA générative sont comparables à celles des médecins non spécialistes. » L’étude a également averti que 76 % des articles analysés présentaient un risque élevé de biais, souvent dû à des données de formation opaques.

Le pare-feu humain : réglementation, responsabilité et limites de l’autonomie

Même si l’IA pouvait atteindre une précision parfaite, elle se heurterait à un mur d’obstacles réglementaires et juridiques. La FDA maintient une norme d’approbation beaucoup plus élevée pour l’IA entièrement autonome par rapport aux outils d’assistance qui maintiennent un humain au courant. Cela permet d’éviter qu’une seule faille logicielle ne nuise à des milliers de patients à la fois.

Il est incroyablement difficile de respecter cette norme. Par exemple, IDx-DR, l’un des rares outils autonomes approuvés par la FDA, est doté de garde-fous stricts : il ne peut être utilisé que sur des adultes présentant une qualité d’image spécifique et sans diagnostic préalable de la maladie.

Si une condition n’est pas optimale, le logiciel doit abandonner et renvoyer le cas à un professionnel humain.

L’assurance contre la faute professionnelle est un autre obstacle important. Les assureurs, se méfiant des paiements catastrophiques causés par un algorithme défectueux, inscrivent de plus en plus de clauses d’exclusion absolue de l’IA dans leurs polices.

Cela oblige les hôpitaux à s’appuyer sur un médecin agréé pour assumer la responsabilité ultime d’un diagnostic, en gardant l’humain fermement aux commandes.

Sans une voie claire à travers ces champs de mines juridiques et financiers, le rôle de l’IA reste résolument assistant. Comme le note un analyste de Signify Research, les modèles de confiance et de remboursement continuent de limiter l’adoption autonome.

Plus que de simples pixels : le paradoxe de la demande basée sur l’IA

Un troisième facteur critique est la véritable portée du travail d’un radiologue. L’interprétation des images ne représente qu’une partie de leur rôle. Une étude de 2012 a révélé que les les diagnostics ne représentaient que 36 % de leur temps, le reste étant consacré aux consultations des patients, à la surveillance des procédures et à l’enseignement.

L’automatisation d’une tâche n’élimine pas la profession. Au lieu de cela, cela pourrait déclencher un paradoxe de Jevons, dans lequel rendre un service moins cher et plus rapide augmente considérablement la demande.

Tout comme la numérisation dans les années 2000 a réduit les délais de traitement des rapports et a conduit à une augmentation de 60 % du volume d’imagerie, L’IA pourrait rendre les radiologues plus occupés que jamais.

Cette dynamique est déjà discutée au sein de la communauté médicale, avec certains radiologues considérer l’IA comme une « arme à double tranchant » qui pourrait atténuer ou exacerber l’épuisement professionnel en fonction de sa mise en œuvre.

L’obstacle fondamental : la confidentialité des données et la confiance du public

À la base de tous ces défis se trouve le dilemme éthique non résolu des données des patients. La formation d’une IA médicale efficace nécessite de vastes ensembles de données, ce qui soulève de profondes préoccupations en matière de confidentialité.

La récente controverse sur le modèle « Foresight » du NHS britannique, formé sur 57 millions de dossiers de patients, en est un bon exemple.

Les experts et les défenseurs de la vie privée préviennent que même les données « anonymisées » comportent un risque persistant de ré-identification. Comme l’a soutenu un défenseur de la vie privée de medConfidential, « cette IA réservée aux covid contient presque certainement des données de patients intégrées, qui ne peuvent pas sortir du laboratoire. »

Ce sentiment est repris par les chercheurs qui soulignent que « les gens veulent généralement garder le contrôle de leurs données et savoir où elles vont. »

Construire la confiance du public est aussi essentiel que de démontrer l’efficacité clinique. Comme l’a déclaré Vin Diwakar du NHS England, « L’IA a le potentiel de changer la façon dont nous prévenons et traitons les maladies, en particulier lorsqu’elle est formée sur de grands ensembles de données », mais le chemin vers l’utilisation de ces données est semé d’embûches éthiques.

Malgré les obstacles, la technologie continue son progrès incessant. Le PDG de Microsoft AI, Mustafa Suleyman, a salué le système MAI-DxO de son entreprise, le qualifiant de « Microsoft a fait un véritable pas vers la superintelligence médicale ».

Entre-temps, des chercheurs européens ont développé Delphi-2M, une IA capable de prévoir le risque de plus de 1 000 maladies des décennies à l’avance.

La question n’est pas de savoir si l’IA sera utilisée, mais comment. Comme l’a si bien dit le professeur Savannah Partridge de l’Université de Washington :”La question n’est pas de savoir si vous utilisez [l’IA] ou non, mais comment l’utiliser ? Comment l’utiliser de manière appropriée et sûre ?”

Le cas de la radiologie montre que pour des professions complexes et à enjeux élevés, le rôle de l’IA évolue vers celui d’un assistant puissant et indispensable, et non d’un remplaçant.