OpenAI a lancé GPT-5, sa famille de modèles d’IA la plus puissante et axée sur les développeurs à ce jour. Sorti jeudi via son API, le nouveau modèle phare offre des performances de pointe dans le codage, l’utilisation des outils et le raisonnement complexe. Le lancement vise à rétablir le leadership d’OpenAI en offrant aux développeurs une IA plus performante, fiable et efficace

disponible en trois tailles-GPT-5, GPT-5-MINI et GPT-5-NANO-la nouvelle série offre un équilibre flexible et coût. Cette stratégie à plusieurs niveaux est une réponse directe à un marché de plus en plus concurrentiel, répondant aux besoins des développeurs, des tâches agetiques haut de gamme aux opérations de faible latence. Il signale une intention claire de capturer l’ensemble du marché des développeurs.

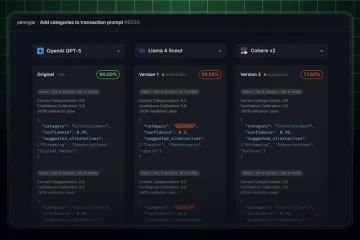

Une nouvelle référence pour le développement alimenté par AI

Ce saut dans la compétence de codage est un objectif principal de la version. Sur la référence Aider Polyglot, qui évalue l’édition de code multi-langues, GPT-5 a atteint un taux de réussite record de 88%. Cela représente une réduction significative des erreurs par rapport aux modèles et concurrents précédents comme le Claude 4.1 Opus.

d’Anthropic, l’intelligence du modèle s’étend au-delà de l’écriture de code à la compréhension et à l’exécution de tâches complexes et en plusieurs étapes. Sur les τ² Bench Benchmark, GPT-5 a obtenu un score de 96.7% Vercel a salué le modèle, déclarant: «C’est le meilleur modèle de Frontend AI, atteignant les performances supérieures à la fois sur le sens esthétique et la qualité du code, le mettant dans une catégorie propre.» De même, le curseur de la plate-forme d’édition de code a trouvé le modèle «remarquablement intelligent, facile à diriger et a même une personnalité [ils] n’ont pas vu dans d’autres modèles». Windsurf a également indiqué que le modèle «a la moitié du taux d’erreur d’appel d’outils par rapport aux autres modèles de frontière», une métrique critique pour une automatisation fiable.

Contrôle granulaire pour les réponses API sur mesure

Un élément clé de la stratégie d’OpenAI est de donner aux développeurs un contrôle direct sur le comportement du modèle. Le nouveau paramètre Response_Effort permet aux développeurs de gérer le compromis entre la qualité de la réponse et la vitesse, avec un réglage “ minimal’pour les réponses quasi-instantations.

Cette affinage fin est crucial pour créer des expériences utilisateur réactives. Un nouveau paramètre de verbosité aide également à gérer la durée des réponses, garantissant que les sorties sont correctement concises ou complètes pour le cas d’utilisation spécifique sans ingénierie rapide complexe.

Simplifiant davantage l’intégration, OpenAI a dévoilé des «outils personnalisés». Cette fonctionnalité permet aux développeurs de définir des outils en utilisant un texte simple simple, en contournant le besoin de formatage JSON strict. Cette modification est conçue pour réduire les erreurs, en particulier lorsque vous passez de grands blocs de code ou de texte qui nécessitent une évasion minutieuse de caractère.

Une famille de modèles à plusieurs niveaux pour la flexibilité et l’échelle

Les centres de stratégie de lancement d’Openai sur une famille de produits segmentés conçue pour concurrencer sur tous les fronts. Le modèle phare GPT-5 est au prix de 1,25 $ par million de jetons d’entrée et 10,00 $ pour la production. Cela le positionne comme l’option haute performance pour les applications exigeantes.

Pour les développeurs priorisant l’efficacité, GPT-5-MINI offre un solde convaincant à seulement 0,25 $ pour les entrées et 2,00 $ pour la sortie. Au niveau le plus accessible, le GPT-5-Nano est optimisé pour les cas d’utilisation à faible latence, au prix de 0,05 $ pour les entrées et 0,40 $ pour les jetons de sortie, en concurrence directement avec des modèles open source plus petits.

Cette structure de prix à niveau est un jeu de plate-forme stratégique pour les modèles de propriété plus petits et plus efficaces. Il fournit une voie claire pour les développeurs afin de mettre à l’échelle leurs applications en fonction des exigences de performance et des contraintes budgétaires, garantissant que OpenAI a une offre pour chaque segment du marché.

Une fiabilité améliorée et une intégration écosystémique

au-delà des performances brutes, GPT-5 a été conçue pour une plus grande confiance. OpenAI rapporte que le modèle fait environ 80% moins d’erreurs factuelles que son prédécesseur sur des références comme Longfact et FactScore, une amélioration cruciale pour la création d’applications fiables.

Cette concentration sur la réduction des hallucinations rend le GPT-5 mieux adapté aux systèmes agents où la correction est paramount. Les commentaires des testeurs d’entreprise comme Manus le confirment, avec un porte-parole disant que le modèle «a réalisé les meilleures performances [qu’ils ont] jamais vues à partir d’un seul modèle sur [leur] référence interne». Ce raisonnement amélioré est essentiel pour l’adoption des entreprises, où l’IA doit fournir des résultats dignes de confiance et perspicaces pour des problèmes commerciaux complexes.

Le lancement du modèle est étroitement associé au partenariat d’OpenAI avec Microsoft. GPT-5 est déjà intégré sur les plates-formes de Microsoft, y compris Azure AI et GitHub Copilot. Cela garantit une disponibilité immédiate pour une base de développeurs massive et solidifie son rôle dans l’écosystème d’entreprise.