Le Moonshot AI, basé à Pékin, a publié Kimi K2 vendredi, une série de modèles d’IA open source visant à récupérer le leadership du marché dans le secteur de l’IA compétitif en Chine. Le lancement est une décision stratégique pour défier les concurrents comme Deepseek et rivaliser dans le monde entier avec les entreprises américaines.

Kimi K2 est un modèle massif de mélange d’Experts avec 1 billion de paramètres. Il est spécialement conçu pour «l’intelligence agentique», ce qui lui permet d’exécuter de manière autonome des tâches complexes et d’utiliser des outils numériques. Moonshot met l’accent sur la capacité de Kimi K2 à agir, pas seulement pour discuter, en le positionnant comme un un nouvel outil puissant pour les développeurs .

La version du 11 juillet marque un moment important pour la start-up de l’alibaba. Fondée en 2023 par le diplômé de l’Université de Tsinghua, Yang Zhilin, Moonshot Ai a rapidement acquis une importance, mais sa position du marché a récemment été contestée par des mouvements agressifs des concurrents locaux. Ce lancement est une réponse directe et énergique.

Un gambit stratégique dans les guerres de l’IA féroce de Chine

La base d’utilisateurs de Moonshot pour son application Kimi a vu son classement se glisser du troisième au septième en Chine entre les modèles en août 2024 et juin 2025. Cette baisse a suivi la version perturbée des prix et des performances à faible coût. La version de Kimi K2 est une offre claire pour inverser cette tendance.

En open sous-marin son modèle phare, Moonshot adopte une stratégie de plus en plus favorisée par les entreprises technologiques chinoises. Cette approche aide à construire une large communauté de développeurs et élargit l’influence mondiale, servant de contre-mesure puissante aux restrictions technologiques américaines. C’est un gambit pour gagner des coeurs et des esprits via le code.

La société publie le modèle sous un Licence MIT modifiée , En encourageant l’adoption et l’expérimentation de l’atténuation de l’atterrissage. This move aims to re-establish Kimi as a go-to platform for developers, betting that superior capability and an open ecosystem can win back market share.

Benchmark Performance and Competitive Standing

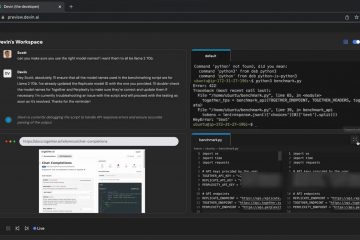

According to performance data released by Moonshot AI, the Kimi-K2-Instruct model was evaluated against other leading open-source and proprietary models across a range of tâches. Les résultats indiquent des performances concurrentielles dans plusieurs domaines clés, notamment le codage, l’utilisation des outils et le raisonnement complexe.

Dans les repères de codage, Kimi K2 a obtenu un score de 53,7 sur Livecodebench V6, par rapport à 47,4 pour Claude OPUS 4 et 44,7 pour GPT-4.1. Sur le test de codage agentique, SWE-Bench vérifié, sa précision à un tentative unique était de 65,8%, le plaçant au-dessus de 38,8% de Deepseek-V3 et de 54,6% de GPT-4.1, tandis que le score de Sonnet 4 de Claude 4 de 72,7%. Sur la tâche des télécommunications TAU2, Kimi K2 a obtenu 65,8, ce qui était supérieur aux scores signalés pour GPT-4.1 (38,6) et Claude Sonnet 4 (45,2). Cela suggère une forte aptitude à l’interfaçage avec des outils externes pour atteindre les objectifs.

Pour les mathématiques et le raisonnement, Kimi K2 a également démontré de forts résultats. Sur la référence de la compétition de mathématiques AIME 2024, son score de 69,6 était supérieur à celui de Gemini 2.5 Flash (61,3) et Claude Opus 4 (48,2). De même, lors du test de raisonnement GPQA-Diamond, son score de 75,1 a légèrement dépassé le 74,9.

de Claude Opus 4. Cela le place en concurrence étroite avec d’autres modèles frontaliers, GPT-4.1 marquant 90,4 et Claude Opus 4 atteignant 92,9. Collectivement, les données suggèrent que Kimi K2 est un modèle hautement capable, en particulier dans la catégorie open source.

Sous le capot: un billion de paramètres d’agent construit pour l’action

kimi k2is un mélange de paramètres totaux, mais uniquement

L’architecture du modèle prend en charge une longueur de contexte de 128K et une taille de vocabulaire 160k. Il dispose de 384 experts distincts, huit étant sélectionnés pour traiter chaque jeton, permettant un calcul hautement spécialisé et efficace. Cette conception est le résultat de l’analyse de la loi de mise à l’échelle visant à maximiser l’efficacité des jetons.

Le modèle a été formé sur des jetons de données de 15,5 billions de données. Pour gérer ce processus sans échec, Moonshot a développé un nouvel optimiseur”MuOnClip”. Cette technique est une évolution de son un travail antérieur sur l’optimiseur Muon , qui surpasse l’optimiseur ADAMW standard mais peut souffrir de l’instabilité à l’échelle.

Logits”qui peuvent dérailler le développement de modèles à grande échelle. La société rapporte que cette méthode lui a permis de terminer l’ensemble de la formation de jetons de 15,5 t avec «Zero Training Spike», mettant en évidence sa robustesse.

Au-delà de l’architecture de base, les capacités agentiques de Kimi K2 ont été perfectionnées par le biais d’un pipeline de synthèse de données sophistiqué. Ce système simule les scénarios du monde réel avec des milliers d’outils, y compris ceux compatibles avec le protocole de contexte du modèle (MCP), pour générer des données de formation basées sur des rubriques de haute qualité pour l’utilisation des outils.

En outre, Moonshot a utilisé un système”d’apprentissage de renforcement général”. Cela implique un mécanisme d’auto-judage où le modèle agit comme son propre critique pour fournir des commentaires sur les tâches avec des récompenses non vertifiables, telles que la rédaction d’un rapport, une étape cruciale dans le développement de compétences agentiques plus générales et fiables.

Moonshot est Kimi Application , a Developer API , et instructions pour le soi-même . La société note de manière transparente que le modèle a des limites, y compris des baisses de performances occasionnelles lorsque l’utilisation de l’outil est activée, un Il prévoit d’adresser .

La course globale pour la poussée de l’intelligence d’agence

L’intelligence agentique suivant l’industrie fondamentale s’éloigne des assistants de l’IA qui suggèrent simplement du texte ou du code. Les agents de l’IA sont conçus pour comprendre un objectif, créer un plan et utiliser des outils pour exécuter des tâches complexes et en plusieurs étapes.

La valeur de cette approche agentique est déjà validée par les entreprises. Dans une décision historique, la banque d’investissement Goldman Sachs vient de commencer à piloter le codeur AI autonome Devin. La banque vise à construire une «main-d’œuvre hybride» où ses ingénieurs humains supervisent des milliers d’agents d’IA.

Le chef de la technologie de Goldman, Marco Argenti, a expliqué la vision, déclarant: «Il s’agit vraiment des personnes et des AIS travaillant à côté. Notre main-d’œuvre avec Devin, qui va ressembler à notre nouvel employé qui va commencer à faire des choses au nom de nos développeurs,”passant la concentration humaine du codage fastidieux à la supervision de haut niveau.

Cette tendance n’est pas limitée aux finances. Le marché plus large du codage de l’IA est un champ de bataille, avec Google lançant son agent Jules et Free Gemini CLI. OpenAI a donné à son agent Codex un accès Internet, bien que le PDG Sam Altman ait averti les utilisateurs de”lire attentivement les risques et utiliser quand cela a du sens”, reconnaissant les risques inhérents.

En attendant, les startups se concentrent sur l’intégration profonde du flux de travail. Anysphere, fabricant de l’éditeur populaire de Cursor AI, a récemment lancé une application Web pour gérer ses agents de codage à partir de n’importe quel appareil. Cette stratégie «multi-surface» vise à faire de l’IA un collaborateur ambiant et toujours présent.