Les attaquants exploitent les instances de webui ouvert erroné à l’aide de logiciels malveillants générés par AI pour compromettre les systèmes. Open WebUI est utilisé par des plateformes de chatbot AI populaires telles que Olllama et LM Studio pour fournir une interface auto-hébergée basée sur un navigateur pour interagir avec les modèles de gros langues.

La campagne sophistiquée marque une escalade concernant. Les outils d’IA élaborent désormais non seulement des charges utiles malveillantes, mais sont également des objectifs d’exploitation. Les attaques ont un impact sur Linux et Windows, visant à installer des cryptomineurs et des infostateurs via une évasion avancée.

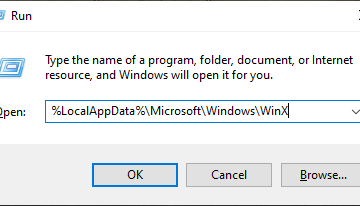

Cet incident met en évidence une nouvelle vulnérabilité critique car les interfaces IA conçues pour la productivité peuvent également devenir des surfaces d’attaque importantes si elles ne sont pas correctement sécurisées. L’enquête de Sysdig a trouvé que les attaquants ont acquis un accès initial à un système WebUI ouvert, qui a été exposé en ligne avec des droits administratifs et aucune authentification en téléchargeant un script python fortement obscurci.

href=”https://sysdig.com/blog/attacker-exploitts-Misconfigured-ai-Tool-to-Ar-ai-Generated-payload/”Target=”_ Blank”> Les chercheurs ont noté Hall des collecteurs de la génération AI. Une analyse du détecteur de code Chatgpt, cité par Sysdig, a conclu que le script était «très probable (~ 85–90%) est généré par AI-AI ou fortement assisté. Les logiciels malveillants assistés en AI, surnommé”Pyklump”par l’équipe de recherche, ont servi de vecteur principal de l’attaque qui a suivi.

Le double rôle de l’AI-un outil pour la création de logiciels malveillants et une cible d’exploitation-présente un nouveau défi de cybersécurité et des hauts élevants le besoin urgent de la sécurité stricte des applications AI et de l’infrastructure. Cela est particulièrement vrai à mesure que les outils d’IA auto-hébergés gagnent en popularité.

anatomie d’une intrusion d’intrusion AI

Le script Python généré par l’AI, une fois exécuté via des outils WebUI ouverts, a lancé un compromis multi-étages. Sysdig a signalé une communication Discord Webhook a facilité les communications de commande et de contrôle (C2). Cette technique est une tendance croissante car elle se mélange facilement au trafic réseau légitime.

Pour éviter la détection, les attaquants ont exploité «Processhider», un utilitaire qui fait des processus malveillants comme les cryptomineurs disparaissent des listes de systèmes standard en interceptant et en modifiant la sortie des appels de système de demande de processus. En outre, ils ont utilisé «Argvhider» pour masquer les paramètres de ligne de commande cruciaux, tels que les URL de pool minière et les adresses de portefeuille; Cet outil réalise l’obscurité en modifiant le vecteur d’argument du processus en mémoire afin que les outils d’inspection ne puissent pas lire les données sensibles d’origine

Le chemin d’attaque de Windows impliquait l’installation du kit de développement Java (JDK). Il s’agissait d’exécuter un fichier de Jar (archive Java) malveillant, Application-Ref.jar, téléchargé à partir d’un serveur C2. Ce pot initial a agi comme un chargeur pour d’autres composants malveillants. Ceux-ci incluaient INT_D.DAT, une DLL Windows 64 bits (bibliothèque de liens dynamiques) avec le décodage XOR (une méthode de chiffrement) et l’évasion de bac à sable

Un autre composant était int_j.dat. Ce dernier pot contenait une autre DLL, app_bound_decryptor.dll, aux côtés de divers infostelleurs. Ces informations d’identification ciblées à partir des extensions du navigateur Chrome et de la discorde. Le codage XOR a utilisé le codage XOR, utilisé des tuyaux nommés (un mécanisme de communication inter-processus utilisé, utilisé, et les caractéristiques de détection de bacs de sable incorporées.

Plus de 17 000 instances de webui ouvert seraient exposées en ligne, selon les données Shodan citées par Sysdig qui créent une surface d’attaque potentielle substantielle.

Le rôle en expansion de l’IA dans le cyber-conflit

Cette exploitation ouverte de Webui est un exemple récent dans un modèle plus large car l’IA est de plus en plus intégré dans les opérations cybercriminales. Dès octobre 2024, Microsoft a signalé une augmentation des cyberattaques axées sur l’IA dépassant 600 millions d’incidents quotidiens, soulignant que les attaquants «voient une augmentation de la façon dont les cybercriminels peuvent automatiser leurs méthodes par l’IA générative». Leur rapport de défense numérique 2024 a également déclaré que «le volume des attaques est tout simplement trop important pour qu’un groupe puisse gérer ses propres»

Un nombre croissant de campagnes de logiciels malveillants axés sur l’IA utilisent de fausses applications et des captchas pour cibler les utilisateurs. Ils utilisent souvent des outils de l’IA Web sombres comme Wormpt et Fraudgpt pour créer des e-mails de phishing sophistiqués et des logiciels malveillants.

En janvier 2025, les taux de réussite des attaques au phishing auraient triplé d’une année à l’autre. Cela a été largement attribué à la capacité de l’IA à créer des leurres plus convaincants et localisés, selon le rapport Cloud and Menace de Netskope. Les LLM peuvent fournir une meilleure localisation et une plus grande variété pour essayer d’échapper aux filtres de spam et augmenter la probabilité de tromper les victimes.

La course aux armements de cybersécurité de l’IA

Alors que les attaquants exploitent l’IA, l’industrie de la cybersécurité développe simultanément les défenses à propulsion de l’IA. Google, par exemple, a lancé SEC-Gemini V1 en avril. Ce modèle d’IA aide les professionnels de la sécurité à la détection et à l’analyse des menaces en temps réel. Cette initiative a suivi des succès antérieurs, tels que l’agent Big Sleep IA de Google qui a identifié l’année dernière une vulnérabilité importante dans le moteur de la base de données SQLite. Google avait annoncé la découverte et l’assainissement de cette faille avant qu’elle ne touche aux utilisateurs.

Les autres grands fournisseurs renforcent également leurs capacités d’IA. Fortinet, en novembre dernier, a élargi ses outils de sécurité de l’IA avec de nouvelles intégrations pour une amélioration de la détection des menaces. En avril 2025, Google a en outre solidifié sa stratégie de sécurité de l’IA en dévoilant sa plate-forme de sécurité unifiée, qui intègre Gemini AI pour consolider la détection et la réponse des menaces en utilisant un raisonnement structuré. Cela contraste avec des approches comme le copilote de sécurité de Microsoft, qui se concentre davantage sur l’automatisation modulaire.