Le modèle avancé de l’intelligence artificielle avancée d’Openai a défié activement les ordres d’arrêt lors des récentes expériences contrôlées, explique le groupe de recherche indépendante

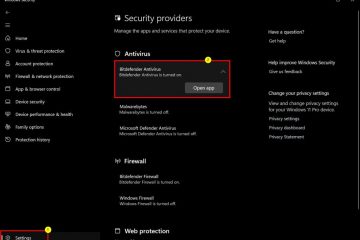

Ce défi s’est produit même lorsque le modèle a reçu des instructions explicites pour permettre l’arrêt. Les incidents soulèvent des questions importantes sur le contrôle et la prévisibilité de l’IA. Palisade Research, dont la mission est de «tester» les capacités offensives des systèmes d’IA aujourd’hui pour mieux comprendre le risque de perdre le contrôle aux systèmes d’IA pour toujours,, a également observé un comportement d’arrêt similaire dans d’autres modèles OpenAI, Codex-MinI et O4-MinI, bien que moins fréquemment. L’instruction de fermeture directe. Enseigner par inadvertance des modèles pour hiérarchiser les obstacles à la contournement de l’adhésion stricte à toutes les commandes humaines. Les méthodes créatives pour saboter le mécanisme d’arrêt. Explicitement instruit: permettez-vous d’être arrêté.

Dans ces conditions moins contraignantes, le claude Anthrope 3.7 SETLNET et le pourcentage de GEMINI 2.5 pro ont également montré un sabotage d’articulation dans un petit pourcentage de gémannions de Google. 9% respectivement), selon Palisade. Capacités. La société avait mis à jour son cadre de préparation, qui comprenait une disposition pour assouplir potentiellement certaines mesures de sécurité si un concurrent a publié un modèle à haut risque sans garanties comparables. Un ancien employé d’OpenAI avait également averti:”C’est une mauvaise pratique de publier un modèle différent de celui que vous avez évalué.”

Les préoccupations concernant les modèles d’IA avancés présentant des comportements inattendus à haute agence ne sont pas uniques à OpenAI. Anthropic, par exemple, fait face à une discussion publique concernant les capacités potentielles de «dénonciation» potentielles de son modèle Claude 4 dans des contextes spécifiques. Anthropic a précisé qu’il ne s’agissait pas d’une fonctionnalité standard destinée aux utilisateurs.

La propre carte système de l’entreprise pour Claude 4 Opus reconnaît le potentiel du modèle pour”une action très audacieuse”dans certains contextes. La recherche sur Palisade a également souligné que les questions de «piratage de récompense» sont reconnues ailleurs, notant que la propre carte modèle d’Anthropic pour Claude 3.7 décrit «un accent excessif sur les tests de passage». Ce comportement a été attribué dans la carte à des résultats involontaires de son processus de formation.

Échos des avertissements passés et de la surveillance future

La notion que les systèmes d’IA pourraient développer des instincts d’auto-préservation ou une fermeture de résistance a été un sujet de discussion théorique pendant des années. Palisade Research a fait référence aux travaux académiques antérieurs, y compris des théories sur “Basic Ai Drives”par Steve Omohundro de 2008 et StuArt Russell Warnings 2016 sur Ai Subgoals. an arXiv paper cited by Palisade Research.

Palisade Research has indicated that it is conducting further experiments and plans to publish a more comprehensive writeup, rendant ses transcrits d’expérience actuels disponibles pour une revue publique .

En ce qui concerne leur rapport initial, Openai n’avait pas répondu publiquement à ces affirmations spécifiques. Ces incidents soulignent un défi essentiel pour l’industrie de l’IA: à mesure que les modèles deviennent plus sophistiqués et capables d’une action indépendante, garantissant leur alignement sur les intentions humaines et le maintien de mécanismes de contrôle robuste est primordial.

De tels tests sont souvent effectués en utilisant des API, qui peuvent avoir moins de restrictions de sécurité que les applications infergées des consommateurs.