Openai semble se préparer à introduire un nouvel obstacle important pour les développeurs qui souhaitent accès à ses futurs modèles d’IA les plus puissants via l’API: une exigence potentielle pour les organisations de subir une vérification d’identité à l’aide d’identifices émis par le gouvernement.

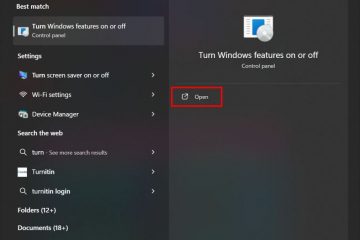

Détails émergeant d’un Page d’assistance OpenAI Décrivez la semaine dernière un processus”organisation vérifiée”, encadré par la société comme une étape nécessaire pour contrer d’absence et promouvoir le déploiement d’IA responsable. OpenAI suggère que cela cible une”petite minorité”violer intentionnellement ses politiques d’utilisation, visant à «atténuer l’utilisation dangereuse de l’IA tout en continuant à rendre les modèles avancés à la disposition de la communauté personnelle plus large. sur les critères spécifiques.

Le système proposé génére déjà une discussion entre les développeurs en ligne. Les préoccupations centrales sur la friction opérationnelle supplémentaire, les considérations de confidentialité de la soumission de l’identification du gouvernement, l’exclusion potentielle des utilisateurs dans les régions extérieures Openai Liste de la motivation primaire des pays en matière d’APle Le suivi des utilisateurs et un contrôle amélioré sur son accès à la plate-forme, en particulier compte tenu des actions antérieures comme le bloc API en Chine ou des enquêtes sur une utilisation abusive de données présumée par Deepseek et autres.

Les nouveaux modèles pourraient déclencher de nouveaux contrôles

Les surfaces de la couche de vérification potentielles sont tout comme des préparations ouvertes pour ce que les sources sont peut-être une nouvelle publication de nouveaux modèles AI-le très systémot Le moment de la politique révèle. De nouveaux lancements pourraient se produire dès cette semaine, y compris GPT-4.1 comme mise à jour de son modèle multimodal GPT-4O, ainsi que des modèles de raisonnement spécialisés désignés par la stratégie de déploiement du modèle O3, O4-MINI et O4-MINI.

Le modèle du modèle d’Openai s’aligne avec un ajustement stratégique significatif confirmé par Ceo Altman le 4 avril. Annonçant un «changement de plans», Altman a priorisé la publication des modèles O3 et O4-MinI «probablement dans quelques semaines», tout en repoussant les débuts du GPT-5 très attendu de «découpez des modèles de raisons et des modèles de discussion» et des modèles de complétion pour permettre à l’entrée pour permettre à la performance de l’O3, de permettre à l’entreprise de permettre à l’O3,”Pour rendre GPT-5 beaucoup mieux que nous à l’origine, mais [t].”Cela a inversé un plan de février 2025 pour potentiellement replier les capacités de l’O3 dans le GPT-5.

La nécessité de modèles de raisonnement distincts était apparente même après le lancement fin février de GPT-4.5, qui ouvre le Href=”https://openai.com/index/gpt-4-5-system-card/de modèles spécialisés sur certains repères à forte intensité de logique, malgré Altman

L’arrivée de ces systèmes plus puissants, en particulier les modèles de raisonnement prévisualisés avec de forts scores de référence mais des coûts de calcul potentiellement élevés, fournit un contexte pour un contrôle accru. Cependant, la justification de la sécurité déclarée d’OpenAI pour la vérification d’identification contraste fortement avec des rapports selon lesquelles les périodes d’évaluation de la sécurité pour ces modèles mêmes ont été considérablement raccourcies. Les opérations d’Openai ont prétendument réduit les délais de test de sécurité pour des modèles tels que O3 de mois à des fins parfois inférieurs à une semaine, entraînés par des pressions concurrentielles intenses. Cette accélération aurait alarmé certaines impliquées dans le processus d’évaluation. Les méthodologies de test spécifiques sont également sous le feu. Les critiques soulignent un manque de résultats publiés pour une mauvaise utilisation des tests potentiels en utilisant un réglage fin-une formation plus approfondie sur des données spécialisées pour sonder pour des capacités émergentes dangereuses-sur les modèles les plus récents et les plus capables comme O1 ou O3-MinI. L’ancien chercheur d’Openai en matière de sécurité OpenTe Steven Adler, qui a détaillé les vues dans un article de blog , a soutenu que cela pourrait conduire les laboratoires à sous-estimer les dangers, Dire au Times Financial ,”Ne pas faire de tels tests pourrait signifier Openai et les autres sociétés AI sous-estiment les pires riches de leurs modèles.”Des préoccupations ont également été soulevées concernant le test des versions du modèle intermédiaire ou des points de contrôle, au lieu du code final expédié au public.”Il est de mauvaise pratique de publier un modèle différent de celui que vous avez évalué”, a déclaré un ancien membre du personnel technique au Ft. , la tête des systèmes de sécurité d’Openai, Johannes Heidecke, a contré ces points, affirmant,”nous avons un bon équilibre entre les points de contrôle testés« Basicalement »,« attribuer la vitesse à l’automatisation et à énoncer les points de contrôle testés ». > tensions internes et toile de fond de l’industrie

Cette friction apparente entre la vitesse de développement et la prudence de la sécurité n’est pas un nouveau territoire pour OpenAI. Les désaccords internes ont été soulignés par le départ de mai 2024 de Jan Leike, puis co-dirigé de l’équipe de superalignement axée sur les risques à long terme, qui a déclaré publiquement que «la culture et les processus de sécurité ont pris le siège arrière des produits internes de la société. Le mémoire fait valoir que la transition d’Openai vers une structure à but lucratif s’écarte de sa mission fondatrice à but non lucratif, un impact potentiellement sur les engagements de sécurité et l’allocation des ressources. La politique potentielle de vérification des identifiants se déroule à mesure que les concurrents font des gestes publics variés vers la sécurité et la transparence, tels que des détails anthropiques sur la sécurité anthropique) et un élément de la société de l’entreprise également supprimée certains antérieurs de la sécurité volontaire antérieure) et un éventualité de Google. Structure de sécurité AGI. Cela se produit dans un contexte de réglementation naissante comme la loi sur l’IA de l’UE, les découvertes en cours des vulnérabilités modèles et des techniques de jailbreaking, et Openai’s Own

Questions de sécurité Ferminations rapides d’ombre