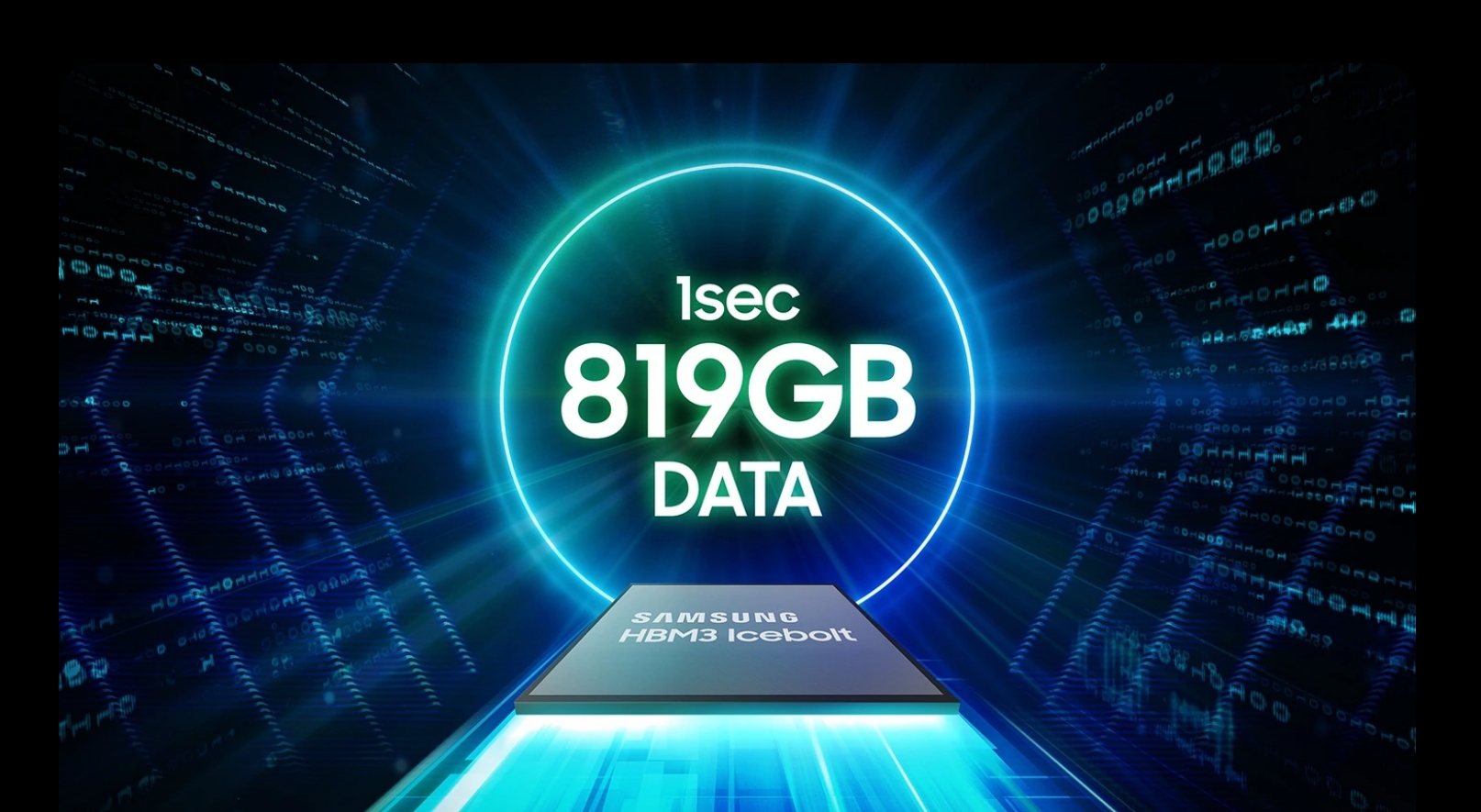

Les puces DRAM HBM3 de Samsung, conçues pour être utilisées dans les accélérateurs d’IA de Nvidia, ont rencontré des problèmes de performances lors essai. Les principales préoccupations concernent la génération excessive de chaleur et la consommation d’énergie élevée, qui ont soulevé des doutes quant à leur adéquation aux besoins informatiques hautes performances de Nvidia. HBM signifie High Bandwidth Memory, utilisant une conception de puce qui offre une bande passante plus élevée que les modules DDR4 ou GDDR5 tout en utilisant moins d’énergie et dans un facteur de forme nettement plus petit. Ceci est obtenu en empilant jusqu’à huit DRAM dies et une puce de base en option qui peut inclure un circuit tampon et une logique de test.

Problèmes de consommation de chaleur et d’énergie

Les problèmes de consommation de chaleur et d’énergie signalés ne sont pas limités aux seules puces HBM3. Les puces HBM3E de Samsung, présentées il y a quelques mois, connaissent également des problèmes similaires. Ces problèmes sont devenus évidents lorsque les résultats des puces HBM3E à 8 et 12 couches de Samsung ont été publiés en avril 2024.

En revanche, SK Hynix a commencé à fournir des puces HBM3E à Nvidia en mars 2024, se positionnant ainsi comme un acteur clé du marché HBM. SK Hynix est actuellement le plus grand fournisseur de puces HBM de Nvidia, essentielles au fonctionnement des accélérateurs d’IA. La domination de Nvidia sur le marché de l’IA, avec une part de 80 %, rend sa certification cruciale pour tout fabricant de puces HBM.

Efforts d’optimisation de Samsung

Samsung a reconnu la nécessité d’une optimisation en tandem avec les exigences des clients. La société travaille en étroite collaboration avec ses clients pour résoudre ces problèmes et s’efforce depuis plus d’un an de passer les tests rigoureux de Nvidia. Les récents changements de direction de Samsung, notamment la nomination d’un ancien expert en développement de DRAM et de flash NAND, soulignent son engagement à résoudre ces défis.

La certification de Nvidia est vitale pour les ambitions de Samsung sur le marché HBM. Les problèmes non résolus de consommation de chaleur et d’énergie jettent une ombre sur les perspectives de Samsung. Il n’est pas certain que ces problèmes puissent être résolus rapidement. L’approbation par le PDG de Nvidia, Jensen Huang, de la puce mémoire HBM3E 12H (12 couches) de Samsung lors de la conférence GTX AI 2024, où il a écrit « Jensen Approved » sur la puce, souligne l’importance de ce partenariat.

La capacité de Samsung à surmonter ces défis est non seulement essentielle pour son activité, mais également pour l’ensemble du secteur. AMD et Nvidia souhaitent que Samsung résolve ces problèmes afin de garantir un approvisionnement stable en puces HBM auprès de plusieurs fournisseurs, ce qui contribuerait à maintenir des prix compétitifs. Samsung fournit déjà des puces HBM à AMD, soulignant encore davantage la nécessité de solutions de mémoire fiables et efficaces.

Samsung vise à démarrer la production en série de puces HBM3E avant la fin du deuxième trimestre de l’année. les efforts visant à optimiser ses puces HBM en collaboration avec les clients reflètent sa détermination à s’implanter sur le marché concurrentiel du matériel d’IA. Le résultat de ces efforts aura un impact significatif sur le futur paysage des accélérateurs d’IA et du calcul haute performance.