Hugging Face a dévoilé SafeCoder, un assistant de code conçu pour les entreprises. Ce nouvel outil est conçu pour renforcer l’efficacité du développement logiciel en fournissant une solution de programmation en binôme sécurisée et auto-hébergée. SafeCoder met l’accent sur la sécurité, en garantissant que le code reste dans le cloud privé virtuel (VPC) pendant les étapes de formation et d’inférence. La conception de SafeCoder permet un déploiement sur site, donnant aux entreprises la propriété de leur code, semblable à un copilote GitHub personnalisé.

De plus, Hugging Face a conclu un partenariat avec VMware, permettant à SafeCoder d’être disponible sur la plateforme VMware Cloud. VMware propose non seulement SafeCoder sur sa plate-forme, mais l’utilise également en interne. Ils ont partagé un plan qui facilite un déploiement rapide sur leur infrastructure.

Les assistants de code, tels que GitHub Copilot, qui repose sur OpenAI Codex, ont joué un rôle déterminant dans l’amélioration de la productivité. En personnalisant les grands modèles linguistiques (LLM) avec leur code, les entreprises peuvent encore amplifier cette productivité. Cependant, l’utilisation de LLM à source fermée présente des problèmes de sécurité potentiels, en particulier pendant les phases de formation et d’inférence. SafeCoder répond à ces préoccupations en permettant la création de LLM propriétaires construits sur des modèles ouverts, affinés sur le code interne, le tout sans partage externe.

SafeCoder prend en charge plus de 80 langages de programmation et adapte les suggestions de code grâce à une formation collaborative avec Hugging Face. Les données propriétaires des entreprises restent sécurisées, ce qui conduit à un modèle de génération de code personnalisé. La capacité d’inférence de SafeCoder est polyvalente et prend en charge une gamme d’options matérielles, des GPU NVIDIA Ampere aux processeurs Intel Xeon Sapphire Rapids.

Débuts dans VMware pour les utilisateurs d’entreprise

Selon l’annonce officielle de Hugging Face, SafeCoder n’est pas seulement un modèle mais une solution commerciale complète. Il a été construit en mettant l’accent sur la sécurité et la confidentialité. Le code ne quitte jamais le VPC pendant la formation ou l’inférence, et il est conçu pour être auto-hébergé par les clients sur leur infrastructure.

Chris Wolf, vice-président de VMware AI Labs, a exprimé son point de vue sur la collaboration, déclarant « Notre collaboration avec Hugging Face autour de SafeCoder s’aligne pleinement sur l’objectif de VMware de permettre aux clients de choisir des solutions tout en préservant la confidentialité et le contrôle de leurs données commerciales. En fait, nous utilisons SafeCoder en interne depuis des mois et avons constaté d’excellents résultats. Mieux encore, notre collaboration avec Hugging Face ne fait que commencer et je suis ravi de proposer notre solution à nos centaines de milliers de clients dans le monde entier.”

SafeCoder est désormais disponible pour les entreprises clientes de VMware, et VMware a également publié une architecture de référence pour garantir une expérience de déploiement transparente sur son infrastructure.

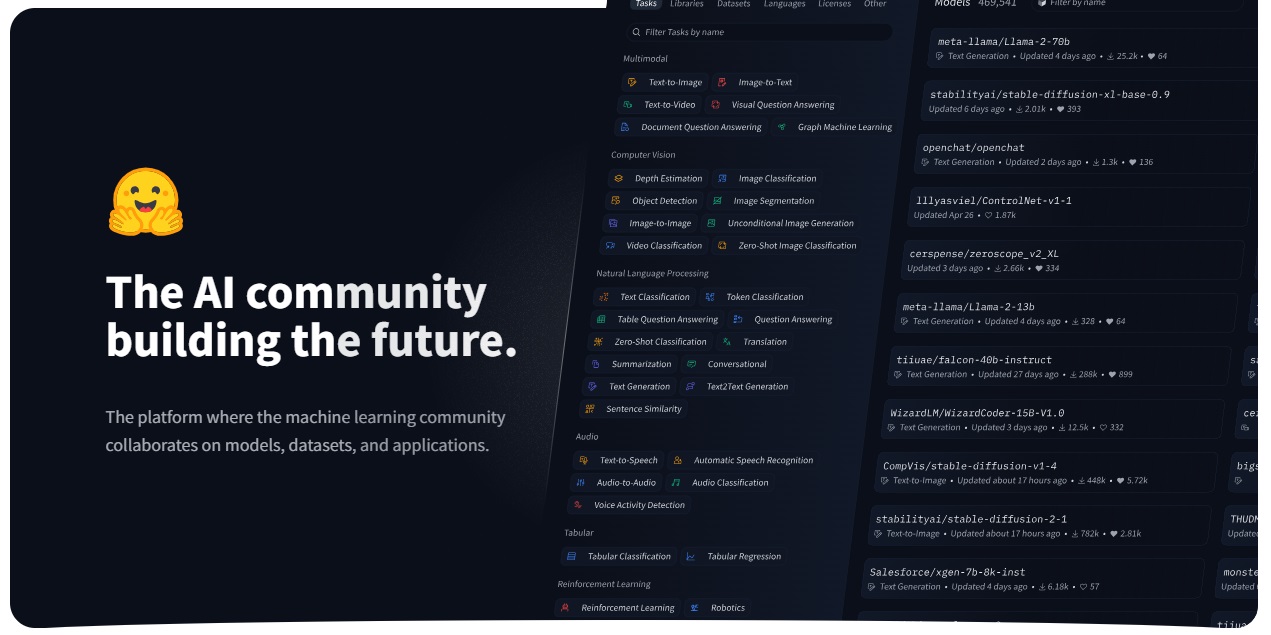

Hugging Face se développe en tant que leader de l’IA

Hugging Face devient un acteur de plus en plus important sur le marché en pleine croissance de l’IA. En février, la société a annoncé un partenariat stratégique avec Amazon Web Services (AWS), sélectionnant Amazon comme son fournisseur cloud préféré pour l’avenir.

Grâce à ce partenariat, les développeurs et les entreprises peuvent exploiter la puissance des modèles d’apprentissage automatique et proposer des fonctionnalités NLP plus rapidement. La communauté Hugging Face peut exploiter les offres et l’infrastructure d’apprentissage automatique d’AWS. Elles peuvent utiliser Amazon SageMaker, la plateforme cloud d’apprentissage automatique, AWS Trainium, le processeur d’apprentissage automatique personnalisé, et AWS Inferentia, l’accélérateur d’apprentissage automatique, pour entraîner, affiner et déployer leurs modèles.

En mars, Microsoft a annoncé qu’Azure Machine Learning propose désormais des modèles de fondation Hugging Face. Microsoft et Hugging Face sont en partenariat depuis l’année dernière. Cette collaboration initiale s’est concentrée sur la création de Hugging Face Endpoints, un service d’inférence d’apprentissage automatique soutenu par Azure ML Managed Endpoint.

Le mois dernier, Hugging Face a également conclu un partenariat avec le géant des puces AMD. Le partenariat permettra aux développeurs de former et de déployer des grands modèles de langage (LLM) sur le matériel AMD, ce qui améliorera considérablement les performances et réduira les coûts.