TL;DR

L’essentiel : Meta a signé des accords de licence pluriannuels avec CNN, Fox News et USA Today pour intégrer les informations en temps réel dans Meta AI. Détails clés: L’accord annule le retrait de Meta de l’actualité en 2024 et coïncide avec un procès très médiatisé contre divers fournisseurs d’IA. Pourquoi c’est important : cela divise le marché de l’IA entre les entreprises qui paient pour les données et celles qui font l’objet de poursuites pour grattage. Contexte: Cloudflare rapporte avoir bloqué 416 milliards de requêtes de robots IA depuis juillet, soulignant l’escalade de la guerre technique pour l’accès aux données.

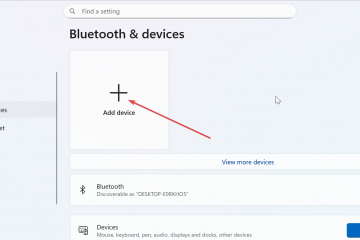

Dans un brusque renversement de son retrait du contenu d’actualité, Meta a signé des accords de licence pluriannuels avec un certain nombre d’éditeurs majeurs, dont CNN, Fox News et USA Today. L’accord, annoncé vendredi, intégrera le reporting en temps réel dans Meta AI, positionnant le géant social comme partenaire payant au moment même où la guerre de l’industrie contre le grattage de données s’intensifie.

Ce pivot stratégique arrive à un moment déterminant de « l’écran partagé » pour le secteur des médias. Le même jour où Meta confirmait ses partenariats, le New York Times a intenté une action en justice pour atteinte aux droits d’auteur contre Perplexity AI, accusant la startup de « freeriding » en matière de journalisme.

En garantissant un accès légitime aux archives et aux dernières nouvelles, Meta tente de s’isoler de la vague de litige frappant des rivaux comme Google et Perplexity. Cette décision divise effectivement le paysage de l’IA entre les entreprises prêtes à payer pour les données et celles qui font face à des milliards de responsabilités potentielles pour les prendre.

Promo

Le pivot stratégique : Meta achète son retour dans l’actualité

Meta a conclu des accords de contenu commercial pluriannuels avec un groupe diversifié d’éditeurs majeurs, notamment CNN, Fox News, Fox Sports, USA Today, Le Monde Group, People Inc., The Daily Caller et The Washington Examiner.

Marquant un changement significatif, cet accord inverse la stratégie de l’entreprise pour 2024, qui l’avait vu supprimer Facebook News Tab et cesser de payer les éditeurs aux États-Unis et en Australie.

Dans le cadre du nouvel accord, l’annonce officielle confirme que Meta AI intégrera des résumés d’actualités « en temps réel » et des liens directs vers des articles originaux.

L’intégration vise à remédier à une faiblesse importante des grands modèles de langage actuels : leur incapacité à accéder de manière fiable à de nouvelles informations.

Expliqueant la nécessité technique de cette démarche, la société a noté que « les événements en temps réel peuvent être difficiles à suivre pour les systèmes d’IA actuels, mais en intégrant davantage et différents types de sources d’information, notre objectif est pour améliorer la capacité de Meta AI à fournir un contenu opportun et pertinent.”

Pour les LLM, le problème de la”fraîcheur”est aigu. Sans accès direct aux flux d’actualités en direct, les modèles hallucinent souvent ou s’appuient sur des données d’entraînement obsolètes lorsqu’ils répondent à des questions sur l’actualité.

Les conditions financières restent confidentielles, mais la structure de l’accord reflète l’approche d’OpenAI consistant à payer pour un accès légitime plutôt que de s’appuyer sur des arguments d’utilisation équitable pour le scraping.

La liste des partenariats comprend notamment à la fois des médias imprimés traditionnels comme USA Today et des géants de la radiodiffusion tels que CNN et Fox, signalant une vaste tentative de capturer des informations diverses. verticaux.

La pression monte sur Meta pour améliorer ses modèles Llama, qui auraient été confrontés à des défis internes concernant la qualité des données et aux « hallucinations ».

La défense du « bon acteur » : isoler les grattoirs

Le timing est essentiel dans la stratégie d’entreprise. L’annonce de Meta coïncide avec une récente ordonnance de transfert de chatlog dans le cadre du procès du New York Times contre OpenAI, créant un contraste frappant sur le marché. Tout en étant impliqué dans ce procès très médiatisé, OpenAI lui-même a déjà conclu de nombreux accords avec des éditeurs de presse.

Les éditeurs divisent de plus en plus les sociétés d’IA en deux camps : les « partenaires » qui paient et les « adversaires » qui grattent, comme Google et Perplexity.

En obligeant les éditeurs à choisir entre la visibilité dans les recherches et la protection du contenu, Google s’est aliéné les créateurs mêmes sur lesquels il s’appuie.

Ce « bon acteur » Le positionnement est une stratégie juridique et de relations publiques clé, conçue pour protéger Meta des poursuites en matière de droits d’auteur qui ciblent actuellement de nombreux concurrents.

L’obtention de licences admet effectivement que le journalisme de haute qualité est un apport nécessaire à l’IA, sapant la défense de « l’utilisation équitable » utilisée par d’autres.

Steven Lieberman, avocat du New York Times, a souligné les enjeux de cette division dans des commentaires précédents sur le procès en matière de droits d’auteur contre OpenAI et Microsoft.

Définissant le problème comme un problème de vol plutôt que d’innovation, Lieberman a déclaré que « nous apprécions l’opportunité de présenter à un jury les faits sur la manière dont OpenAI et Microsoft profitent énormément du vol du contenu original des journaux à travers le pays. »

Si les tribunaux acceptent cette interprétation, les entreprises sans licence pourraient faire face à des responsabilités financières catastrophiques.

La guerre du scraping : 416 milliards de robots bloqués

Alors que des accords sont signés dans les salles de réunion, la guerre technique pour l’accès aux données a atteint des niveaux sans précédent à la périphérie du réseau.

Le PDG de Cloudflare, Matthew Prince, a récemment annoncé que sa société avait bloqué 416 milliards de requêtes bloquées provenant de robots IA depuis le 1er juillet 2025, soit une moyenne de près de 3 milliards de refus par jour.

Reflétant la transition du secteur vers la défense active, les éditeurs utilisent de plus en plus d’outils comme « AI Labyrinth » pour piéger les scrapers non autorisés dans des boucles sans fin de faux contenus.

Prince a présenté ce conflit comme une bataille contre les excès monopolistiques.

Caractérisant le changement de perception de l’industrie, Prince a observé que”c’est presque comme dans un film Marvel, le héros du dernier film devient le méchant du suivant. Google est le problème ici. C’est l’entreprise qui nous empêche d’avancer sur Internet.”

Les données révèlent une disparité significative dans la visibilité des robots d’exploration, Google accède à 3,2 fois plus de pages Web qu’OpenAI en raison de sa domination en matière de recherche.

Ce « regroupement » de la recherche et de l’exploration de l’IA est le principal grief à l’origine de l’hostilité des éditeurs et des contre-mesures techniques.

Les retombées économiques : trafic contre conversion

Au cœur du conflit reste l’effondrement du traditionnel échange de valeur « trafic contre contenu » qui a construit le Web ouvert.

Confirmant les craintes des éditeurs, une étude universitaire récente a quantifié dans quelle mesure les résultats générés par l’IA s’écartent des classements de recherche traditionnels. La recherche a révélé que les algorithmes qui alimentent ces nouveaux résumés donnent la priorité à un ensemble de sources très différent de celui des moteurs de recherche standards.

Plus précisément, l’étude a révélé que 53 % des sites Web cités dans les aperçus de l’IA de Google n’apparaissaient pas dans les 10 premiers résultats de recherche organiques pour la même requête. Cela indique une rupture fondamentale avec les signaux de classement établis, remaniant efficacement la visibilité du contenu Web et rendant les stratégies de référencement traditionnelles de plus en plus obsolètes.

Ce changement structurel signifie que les moteurs de recherche IA ne se contentent pas de résumer le contenu mais redirigent activement les utilisateurs loin des sources originales.

Danielle Coffey de News/Media Alliance a qualifié ce changement non seulement de perturbation, mais de vol systémique qui démantèle les fondements économiques du journalisme. Elle affirme que le « grand marché » historique du Web ouvert, selon lequel les éditeurs autorisaient l’indexation en échange de trafic de référencement, a été rompu unilatéralement.

De son point de vue, les géants de la technologie extraient désormais de force la valeur du reporting pour former leurs modèles tout en supprimant les liens qui fournissaient le seul retour financier pour les éditeurs, laissant aux organisations médiatiques tous les coûts de production et aucun des avantages de distribution.

Microsoft a récemment tenté de contrer ce récit avec des données sur les référencements de recherche par l’IA. affirmant qu’ils convertissent à un taux 3 fois supérieur à celui du trafic traditionnel.

Fabrice Canel, chef de produit principal chez Bing, pense que”pour les spécialistes du marketing, la visibilité elle-même devient une forme de monnaie. Si vous définissez vos préférences avant qu’un clic ne se produise.”

La question de savoir si la « mise en forme des préférences » peut réellement payer les salaires des rédactions reste une proposition profondément sceptique pour une industrie qui voit son trafic s’évaporer.