Au milieu d’une révolte mondiale des éditeurs confrontés à des pertes de trafic catastrophiques, Microsoft et Google tentent de réécrire le récit de la crise de la recherche par l’IA. De nouvelles données publiées jeudi par Microsoft affirment que même si la recherche basée sur l’IA génère moins de clics, ces références se convertissent trois fois plus vite que le trafic traditionnel, un tournant décisif vers une défense de « la qualité plutôt que la quantité ».

De telles affirmations remettent directement en question les études indépendantes et les témoignages d’éditeurs, qui décrivent le passage aux « moteurs de réponse » sans clic non pas comme un gain d’efficacité, mais comme une menace existentielle pour le Web ouvert financé par la publicité.

La contre-offensive de la plateforme : redéfinir Valeur

L’équipe Bing de Microsoft a publié jeudi de nouvelles données affirmant que le récit de « l’effondrement du trafic » passe à côté de l’essentiel, affirmant que les référencements basés sur l’IA se convertissent à des taux nettement plus élevés que la recherche traditionnelle.

Selon Microsoft, les références IA se convertissent désormais jusqu’à 3 fois le taux de trafic de recherche standard, avec des des plates-formes comme Copilot montrent une augmentation de 17 fois par rapport au trafic direct.

“Les dernières données de la plate-forme Microsoft Clarity confirment cette tendance. En analysant le trafic sur 1 200 sites d’éditeurs et d’actualités, Clarity rapporte que les références basées sur l’IA ont augmenté de 155 % sur huit mois et ont été converties jusqu’à trois fois plus vite que les canaux traditionnels tels que la recherche et les réseaux sociaux.”

“Même si les références basées sur l’IA représentent toujours moins de 1 % du total des visites, ces utilisateurs affichent systématiquement une intention plus élevée. et l’engagement, l’inscription, l’abonnement ou l’achat à des tarifs bien plus élevés.”

Au cœur de cette défense se trouve un désaccord fondamental sur ce qui constitue la valeur sur le Web. Fabrice Canel, chef de produit principal chez Bing, décrit cela comme un changement de « monnaie », affirmant que la visibilité dans les résumés d’IA crée une préférence avant qu’un clic ne se produise.

Il suggère que « pour les spécialistes du marketing, la visibilité elle-même devient une forme de monnaie. Si vous façonnez les préférences avant qu’un clic ne se produise. »

Plutôt que de mesurer le succès par les pages vues, Microsoft soutient que les éditeurs doivent se concentrer sur l’alignement. Canel affirme que l’objectif est de « s’aligner sur l’intention de l’utilisateur et d’offrir clarté, crédibilité et valeur à chaque étape de la découverte, de sorte que lorsque quelqu’un est prêt à agir, votre marque ou votre contenu devienne le choix naturel. »

Reflétant la récente stratégie de relations publiques de Google, cette défense de « la qualité plutôt que la quantité » tente de faire évoluer les KPI du secteur.

En août, Liz Reid, responsable de la recherche chez Google, a fait valoir que même si le volume des requêtes peut changer, les clics qui en résultent ont une « valeur plus élevée ». Elle a déclaré qu’« une réponse de l’IA pourrait donner un aperçu du terrain, mais les gens cliquent pour approfondir et en savoir plus, et lorsqu’ils le font, ces clics sont plus précieux. »

En fait, les plateformes tentent de redéfinir les mesures du Web ouvert, en s’éloignant des « pages vues » (qui soutiennent les revenus publicitaires) aux « conversions » (qui prennent en charge les transactions).

Le conflit de données : études indépendantes et plateforme. PR

Alors que les données internes de Microsoft dressent un tableau d’un trafic à haute efficacité, des recherches indépendantes racontent une tout autre histoire. Une étude publiée en septembre par l’agence numérique Amsive a révélé une différence négligeable dans les taux de conversion entre l’IA et la recherche organique.

“En examinant les moyennes converties sur tous les sites, le trafic organique à 4,60 % tandis que les références LLM ont été converties à 4,87 %. À première vue, cela suggère un avantage modeste pour le trafic LLM. à la fois en termes de part de trafic et de part de conversion. Il s’agit de la conclusion la plus cohérente et incontestable des données.”

De telles divergences suggèrent que l’argument de la « qualité » peut s’appuyer fortement sur des requêtes transactionnelles spécifiques tout en ignorant les recherches d’informations plus larges qui génèrent la plupart du trafic Web.

Le scepticisme du secteur est aggravé par le fort contraste entre les affirmations de la plateforme et le suivi par des tiers. Une étude de Pew Research publiée en juillet a confirmé que lorsqu’un aperçu de l’IA apparaît, les clics sur des liens externes chutent de 15 % à seulement 8 %.

” 53 % des sites Web liés par l’aperçu de l’IA de Google n’apparaissent pas dans les 10 premiers résultats d’une recherche conventionnelle. Cela indique une divergence significative par rapport aux signaux de classement établis de la recherche traditionnelle.”

“Citant beaucoup moins de sources que ses homologues, le GPT-4o d’OpenAI avec un outil de recherche s’est appuyé sur une moyenne de seulement 0,4 page Web par requête, s’appuyant fortement sur ses connaissances internes pré-entraînées. Soulignant davantage le risque, l’étude sur la fiabilité de la recherche par l’IA note que ces systèmes s’appuient souvent sur un ensemble restreint de sources, réduisant ainsi la diversité du Web ouvert.

La réalité des éditeurs : le volume est la survie

Pour les entreprises de médias, le passage du volume à la conversion n’est pas un simple compromis ; c’est un effondrement du modèle économique. Des éditeurs comme People Inc. ont signalé des baisses de trafic allant jusqu’à 65 % ces dernières années. Neil Vogel, PDG de People Inc., a été direct dans son évaluation des moteurs de recherche alimentés par l’IA, déclarant qu'”ils le savent et ne divisent pas leur robot d’exploration. Ils sont donc intentionnellement de mauvais acteurs ici.”

Pour le journalisme financé par la publicité, la réalité économique est que des taux de conversion élevés sur <1 % du trafic ne peuvent pas remplacer les revenus perdus en raison d'une baisse massive des pages vues. Danielle Coffey, PDG de News/Media Alliance, a résumé le désespoir du secteur, notant que"les liens étaient la dernière qualité rédemptrice de la recherche qui apportait du trafic et des revenus aux éditeurs. Désormais, Google prend le contenu par la force et l'utilise sans retour."utilisation.

Loin d’une simple amélioration de l’efficacité, ce changement représente une rupture fondamentale dans l’échange de valeur du Web. Même l’équipe juridique de Google semble reconnaître la gravité de la situation.

Dans un dossier judiciaire déposé le 5 septembre pour se défendre contre la dissolution de son activité publicitaire, la société a admis que « le fait est qu’aujourd’hui, le Web ouvert est déjà en déclin rapide et la proposition de cession des plaignants ne ferait qu’accélérer ce déclin… »

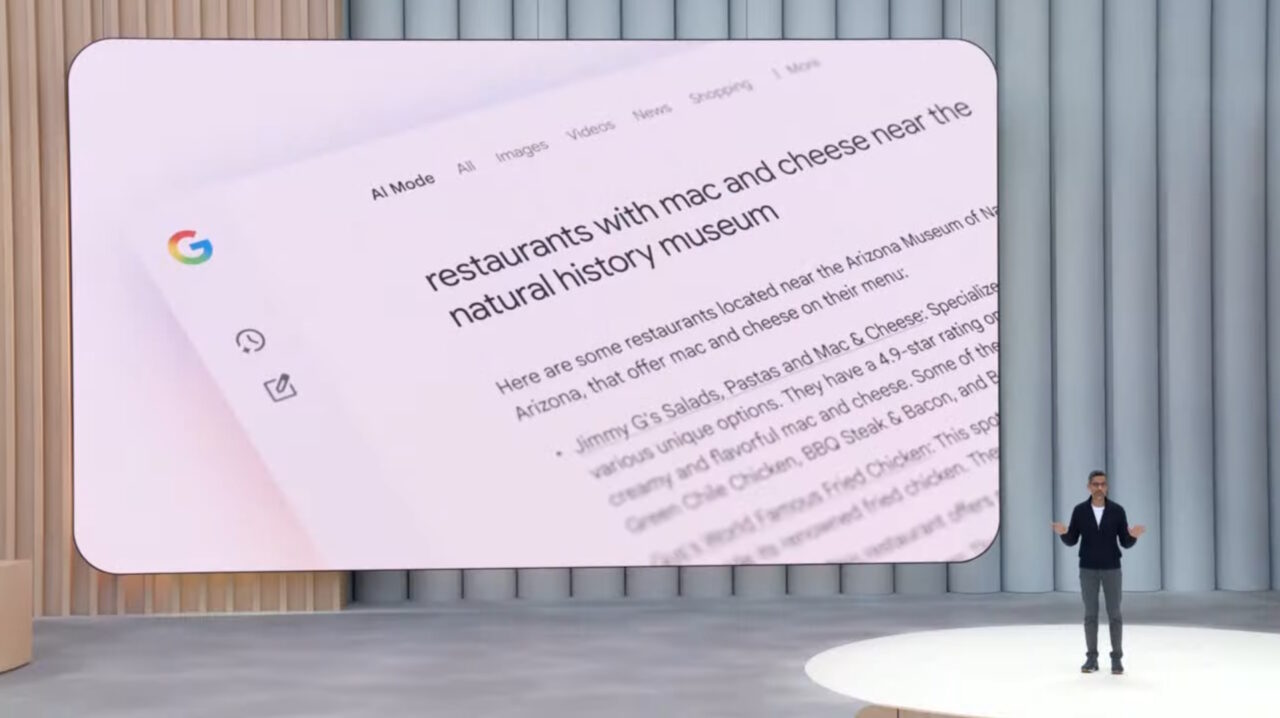

Alors que Google intègre Gemini 3 dans la recherche pour créer des expériences entièrement « agents » capables d’exécuter des tâches sans quitter la page de résultats, la pression sur les éditeurs vont probablement s’intensifier. Coincée entre les promesses de la plateforme d’un trafic de « meilleure qualité » et la dure réalité d’une audience en diminution, l’industrie est confrontée à un avenir incertain.