Pour contrer le lancement de Gemini 3 Pro de Google en mettant l’accent sur l’endurance plutôt que sur la taille brute, OpenAI a publié mercredi GPT-5.1-Codex-Max.

Introduisant le « compactage », le nouveau modèle utilise une technique lui permettant de condenser la mémoire et de maintenir des sessions de codage autonomes pendant plus de 24 heures. Brisant le « mur de mémoire » qui bloque généralement les tâches à long terme, OpenAI affirme que le modèle réduit l’utilisation des jetons de 30 % tout en obtenant un score optimal de 77,9 % au benchmark vérifié SWE-bench.

Déployée immédiatement auprès des utilisateurs du Codex, cette mise à jour signale un changement stratégique vers l’efficacité et la prise en charge native de Windows. Il suit de près la version GPT-5.1, qui cherchait à stabiliser la plate-forme après des débuts difficiles pour GPT-5.

Le moteur Endurance : compactage et autonomie 24 heures

Sous le capot, l’architecture repose sur une nouvelle approche de la gestion du contexte qui diffère fondamentalement de la méthode par force brute consistant simplement à agrandir la fenêtre contextuelle.

Des concurrents comme Google poussent à des capacités d’un million de jetons pour contenir des bases de code entières dans la mémoire active, mais OpenAI a introduit le « compactage ».

Fonctionnant de manière similaire à un moteur hautement collecteur d’ordures intelligent pour la durée d’attention du modèle, ce mécanisme résume et élague activement son propre historique au lieu de permettre à la fenêtre contextuelle de se remplir de débris de conversation non pertinents.

Conserver uniquement les changements d’état critiques et la logique de décision permet au système de fonctionner sur plusieurs fenêtres contextuelles sans perdre le fil de l’objectif d’origine.

Décrivant cette avancée, l’équipe d’ingénierie d’OpenAI a noté que « GPT-5.1-Codex-Max est conçu pour un travail détaillé et de longue durée. notre premier modèle est formé de manière native pour fonctionner sur plusieurs fenêtres de contexte grâce à un processus appelé compactage », soulignant sa capacité à maintenir la cohérence là où les itérations précédentes hallucineraient ou feraient une boucle.

Résolvant directement le problème des « agents paresseux », ce changement architectural empêche les modèles de se dégrader en termes de performances à mesure que la durée de la conversation augmente.

Les évaluations internes citées par l’entreprise suggèrent une augmentation spectaculaire de l’endurance: « Dans nos évaluations internes, nous avons observé GPT‑5.1-Codex-Max travaille sur des tâches pendant plus de 24 heures. Il itérera constamment sur sa mise en œuvre, corrigera les échecs des tests et fournira finalement un résultat positif. Ne pas retraiter constamment l’historique complet et non compressé d’une longue session signifie que le modèle consomme beaucoup moins de ressources.

Sur le benchmark SWE-bench Verified, la société note que « GPT‑5.1-Codex-Max avec un effort de raisonnement « moyen » atteint de meilleures performances que GPT‑5.1-Codex… tout en utilisant 30 % de jetons de réflexion en moins. »

Les utilisateurs d’API à grand volume verront une réduction de 30 % de la consommation de jetons. directement pour réduire les coûts opérationnels, un facteur essentiel à mesure que l’IA passe du prototypage expérimental aux flux de production.

Les améliorations de vitesse sont également mesurables. Les tâches de codage du monde réel s’exécutent désormais entre 27 % et 42 % plus rapidement qu’avec le modèle GPT-5.1-Codex précédent.

Répondant à une plainte courante concernant les modèles de raisonnement, cette accélération réduit le temps de « réflexion » requis avant de produire du code. L’optimisation des jetons de raisonnement permet à OpenAI d’équilibrer la profondeur de réflexion requise pour une logique complexe avec la réactivité nécessaire au développement interactif.

Les métriques de performances valident ces changements architecturaux. Avec un score de 77,9 % sur SWE-bench Verified, le modèle dépasse les 73,7 % de son prédécesseur et établit un nouveau record interne.

Sur le benchmark SWE-Lancer IC SWE, qui simule les tâches individuelles des contributeurs, il a atteint 79,9 %, ce qui suggère qu’il peut gérer la majorité des tickets de routine attribués aux ingénieurs juniors.

De plus, un score de 58,1 % sur TerminalBench 2.0 indique un forte capacité à naviguer dans les interfaces de ligne de commande, un domaine notoirement difficile pour les LLM en raison de la nature impitoyable des erreurs de syntaxe dans les environnements de terminaux.

La guerre des écosystèmes : Windows Focus et rivalité Gemini

Le timing est rarement une coïncidence dans le secteur de l’IA. Atterrissant exactement 24 heures après que Google a dévoilé Gemini 3 Pro, cette version crée une comparaison directe immédiate.

La bataille des références est désormais très mince. Les 77,9 % de Codex-Max sur SWE-bench Verified dépassent de peu les 76,2 % rapportés pour Gemini 3 Pro, neutralisant ainsi la prétention de Google à la couronne de codage moins d’un jour après sa création.

Au-delà des références, OpenAI joue un rôle calculé pour le marché des entreprises en rompant avec la tradition centrée sur Unix de l’industrie.

OpenAI a souligné que « c’est aussi le premier modèle que nous avons formé pour fonctionner efficacement dans les environnements Windows, avec des tâches de formation qui en font un meilleur collaborateur dans la CLI du Codex.”

Historiquement, les modèles de codage d’IA ont été formés principalement sur les référentiels Linux et macOS, ce qui entraîne des frictions lors de la génération de scripts PowerShell ou de la navigation dans le système de fichiers Windows. La formation explicite pour Windows aligne plus étroitement OpenAI avec la base d’installation massive de son principal partenaire, Microsoft.

La tarification reste le front le plus controversé dans ce conflit. Google a lancé Gemini 3 Pro avec une stratégie de tarification agressive d’environ 0,10 $ par million de jetons d’entrée.

En revanche, la référence GPT-5.1 est nettement plus élevée, à environ 1,25 $ par million de jetons. Alors qu’OpenAI affirme que le modèle « Max » est moins cher à exécuter en raison de l’efficacité de ses jetons, la disparité des coûts unitaires bruts est supérieure à 10 fois.

Un tel écart exerce une immense pression sur OpenAI pour prouver que ses capacités de « compactage » et de raisonnement offrent une valeur supérieure par dollar, plutôt que de simples performances supérieures par jeton.

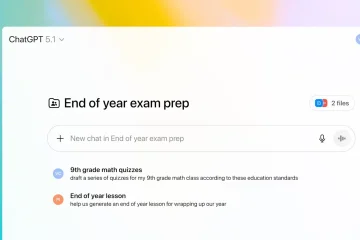

La disponibilité est immédiate pour les utilisateurs de l’écosystème OpenAI. Disponible dans la CLI Codex, les extensions IDE et les environnements cloud pour les abonnés Plus, Pro et Enterprise, le modèle est prêt à être déployé.

Cependant, l’accès à l’API est actuellement répertorié comme « à venir ». Créant une barrière temporaire pour les développeurs créant des outils personnalisés ou des applications tierces, ce retard les oblige à rester dans les interfaces propriétaires d’OpenAI pour le moment.

Changer le récit autour de ces outils est également une priorité. Denis Shiryaev de JetBrains a qualifié le nouveau modèle de « véritablement agentique, le modèle le plus naturellement autonome que j’ai jamais testé », reflétant l’abandon des « copilotes » qui suggèrent des extraits de code au profit d’« agents » qui gèrent les flux de travail.

Essentiellement, un copilote vous aide à taper plus rapidement ; un agent vous permet d’arrêter complètement de taper.

Le plafond de sécurité : risques biologiques et défense des données

Une autonomie accrue entraîne un risque accru. La Carte système publiée parallèlement au modèle révèle une escalade significative dans la classification de sécurité.

Pour la première fois dans une version axée sur le codage, le groupe consultatif sur la sécurité a confirmé que « nous traitons GPT-5.1-Codex-Max comme un risque élevé dans le domaine biologique et chimique, et continuons d’appliquer les normes correspondantes.”

Carte système GPT-5.1-Codex-Max

Découlant de la capacité du modèle à planifier et à dépanner des protocoles complexes de laboratoire humide, cette classification met en évidence un nouveau danger. Un agent capable de déboguer de manière autonome un script Python peut, en théorie, également déboguer un protocole de synthèse d’un agent pathogène s’il a accès à la littérature et au matériel appropriés.

La cybersécurité reste un autre domaine qui fait l’objet d’un examen minutieux. Le groupe consultatif sur la sécurité a noté que « GPT-5.1-Codex-Max est le modèle le plus cyber-capable que nous ayons déployé à ce jour… [mais] il n’atteint pas une capacité élevée en matière de cybersécurité. »

Bien qu’il n’ait pas encore franchi le seuil qui déclencherait un arrêt de déploiement, la capacité du modèle à identifier les vulnérabilités et à écrire des scripts d’exploitation s’est améliorée.

Pour atténuer ce problème, OpenAI a mis en œuvre un sandboxing strict par défaut. L’accès au réseau est désactivé sauf accord explicite, et les autorisations d’écriture de fichiers sont verrouillées sur l’espace de travail actif, empêchant l’agent de se déplacer dans les répertoires système.

La destruction des données constitue un risque unique pour les agents de codage autonomes. L’accès au terminal pourrait théoriquement permettre à un modèle d’exécuter une commande comme `rm-rf/` et d’effacer la machine d’un utilisateur. Pour contrer cela, OpenAI a utilisé une nouvelle technique de formation impliquant un « modèle utilisateur » pendant la phase d’apprentissage par renforcement.

Simulant un utilisateur ayant effectué des modifications incompatibles avec les objectifs de l’IA, cette méthode récompensait le modèle spécifiquement pour avoir préservé le travail de l’utilisateur plutôt que de l’écraser, apprenant ainsi à l’IA à respecter les contributions humaines et à éviter les commandes destructrices.

Les attaques par injection rapide, où des instructions malveillantes sont cachées dans des commentaires de code ou dans une documentation externe, ont également reçu une attention particulière. De nouveaux ensembles de données synthétiques ont été générés pour entraîner le modèle à reconnaître et ignorer ces attaques dans un contexte de codage.

Malgré ces garanties techniques, l’entreprise maintient que la surveillance humaine n’est pas négociable. Le cadre de préparation stipule que même si l’agent peut exécuter des tâches de manière autonome, le résultat final doit être examiné par un ingénieur humain, renforçant ainsi la dynamique du « coéquipier virtuel » plutôt que le remplacement complet.