IBM a dévoilé aujourd’hui ses processeurs quantiques de nouvelle génération, accélérant ainsi son calendrier de construction d’un ordinateur quantique utile.

Lors de son événement annuel des développeurs mardi, la société a lancé le processeur Nighthawk de 120 qubits, conçu pour résoudre des problèmes plus complexes. Il a également révélé la puce expérimentale Loon, une étape clé vers des systèmes à l’épreuve des erreurs.

Ces gains matériels, ainsi que de nouveaux progrès dans la correction des erreurs, maintiennent IBM sur la bonne voie pour un « avantage quantique » d’ici 2026 et une machine tolérante aux pannes d’ici 2029. La nouvelle réchauffe la course quantique, suite à une récente avancée majeure de son rival Google.

Nighthawk et Loon : un double bond en avant dans la conception des processeurs

Avec son dernier matériel, IBM parie qu’une connectivité complexe et une correction d’erreur robuste dépasseront le nombre de qubits bruts de ses concurrents. IBM a dévoilé deux processeurs distincts, chacun abordant une partie différente du défi quantique.

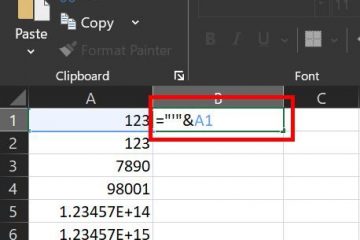

Tout d’abord, l’IBM Quantum Nighthawk est conçu pour offrir un avantage quantique au cours des deux prochaines années. Attendu d’ici fin 2025, il comportera 120 qubits reliés par 218 coupleurs accordables de nouvelle génération.

Processeur IBM Nighthawk Quantum (Source: IBM)

Selon IBM, cette architecture permettra aux utilisateurs d’exécuter des circuits avec 30 % de complexité en plus que son processeur Heron actuel tout en maintenant de faibles taux d’erreur.

IBM a également présenté une feuille de route ambitieuse en matière de performances pour les systèmes basés sur Nighthawk, ciblant la capacité à gérer à 7 500 portes à deux qubits d’ici 2026 et 15 000 d’ici 2028.

Alors que Nighthawk repousse les limites de l’utilité à court terme, le processeur expérimental Loon pose les bases de l’avenir de l’informatique tolérante aux pannes.

Loon introduit une nouvelle architecture dans laquelle chaque qubit se connecte à six autres, y compris verticalement, une capacité qu’aucun autre ordinateur quantique supraconducteur n’a démontrée. Une connectivité aussi dense et tridimensionnelle est essentielle à la mise en œuvre des codes de correction d’erreurs efficaces nécessaires aux machines véritablement évolutives.

IBM Processeur Loon Quantum (Source : IBM)

Pendant des années, certains chercheurs se sont demandé si des connexions aussi complexes étaient réalisables. Jay Gambetta d’IBM a souligné ce scepticisme, déclarant au New Scientist que c’était comme si les gens disaient: « Vous êtes dans le domaine de la théorie, vous ne pouvez pas vous en rendre compte. » Et [maintenant] nous allons le faire. montrez que [avoir] tort.”

Accélération de la feuille de route : correction des erreurs et fabrication à l’échelle industrielle

Derrière les annonces de processeurs se cache une étape critique de fabrication. IBM a transféré sa principale production de plaquettes quantiques vers une installation de fabrication avancée de 300 mm au sein du Albany NanoTech Complex.

Le passage à des outils conformes aux normes de l’industrie a déjà doublé la vitesse de ses cycles de R&D. Il permet des conceptions de puces plus complexes et signale le passage du travail en laboratoire spécialisé à la fabrication à l’échelle industrielle, une étape clé pour la construction de systèmes plus grands.

S’adapter à ce rythme industriel constitue une avancée majeure en matière de logiciels et de correction d’erreurs. IBM a annoncé avoir démontré avec succès le décodage en temps réel des erreurs quantiques à l’aide de codes qLDPC avancés sur du matériel classique, une étape cruciale pour la tolérance aux pannes qui a été réalisée un an avant la date prévue.

Pour rendre ces gains matériels accessibles, IBM améliore sa pile logicielle Qiskit. Une nouvelle interface C++ contribuera à combler le fossé entre les environnements quantiques et de calcul haute performance (HPC).

De plus, les nouvelles techniques d’atténuation des erreurs basées sur le HPC peuvent réduire de plus de 100 fois le coût d’extraction de résultats précis. L’accent mis sur une pile matérielle et logicielle complète est au cœur de la vision de l’entreprise.

Comme l’a déclaré Jay Gambetta, directeur de la recherche IBM et IBM Fellow: « Nous pensons qu’IBM est la seule entreprise capable d’inventer et de faire évoluer rapidement les logiciels, le matériel, la fabrication et la correction d’erreurs quantiques pour débloquer des applications transformatrices. »

La course quantique s’intensifie : la stratégie d’IBM dans un domaine encombré

Dans un domaine encombré architectures concurrentes, l’approche modulaire d’IBM vise d’abord à construire une base fiable. Les annonces d’IBM surviennent dans un environnement extrêmement concurrentiel.

Le mois dernier, Google a affirmé avoir obtenu un « avantage quantique vérifiable », tandis que son concurrent Quantinuum a récemment dévoilé son système Helios à 98 qubits, qu’il qualifie d’ordinateur quantique commercial le plus précis au monde.

La stratégie d’IBM contraste fortement avec celle de ses concurrents et d’autres comme Microsoft et Amazon, qui recherchent des technologies de qubits différentes.

Big Blue se concentre sur le perfectionnement de ses qubits supraconducteurs en concevant une meilleure connectivité et en développant un cadre robuste de correction d’erreurs pouvant fonctionner sur des systèmes quantiques classiques hybrides.

La lutte contre le défi fondamental de l’instabilité des qubits est un défi à l’échelle de l’industrie. efforts. Une avancée récente de l’Université de Princeton, sans rapport avec les travaux d’IBM, illustre l’importance de ce problème.

Les chercheurs y ont développé une nouvelle conception de qubit qui reste stable 15 fois plus longtemps que les normes actuelles de l’industrie.

Andrew Houck de Princeton a commenté les progrès généraux en déclarant:”Cette avancée fait sortir l’informatique quantique du domaine du simple possible pour le faire entrer dans le domaine de la pratique. Nous pouvons désormais commencer à progresser beaucoup plus rapidement.”

En fin de compte, IBM Le dernier succès recadre un élément clé du concours quantique. L’accent est désormais mis sur le décompte brut des qubits vers l’ingénierie de systèmes vérifiables, reproductibles et pratiques. Stephen Bartlett de l’Université de Sydney a offert une perspective mesurée sur les nouveaux processeurs, déclarant :”Ce n’est pas une solution miracle qui résout tous les problèmes… mais il s’agit néanmoins d’une étape majeure et significative vers”

En démontrant que les composants essentiels d’un avenir tolérant aux pannes peuvent être construits et mis à l’échelle, IBM a considérablement rapproché cet avenir.