Microsoft développe apparemment de nouveaux outils logiciels pour exécuter le logiciel d’IA de NVIDIA sur des puces AMD moins chères, selon les commentaires d’un employé présumé qui ont fait surface cette semaine.

Réduire le coût élevé des charges de travail d’IA, également connu sous le nom d’inférence, remettrait directement en question la domination de longue date de NVIDIA.

De tels outils fonctionneraient en convertissant le code de la plate-forme CUDA propriétaire de NVIDIA au format open source ROCm d’AMD. Si cela est vrai, la stratégie refléterait une tendance plus large du secteur, alors que des géants de la technologie comme Oracle et OpenAI augmentent leur dépendance au matériel AMD pour favoriser la concurrence.

Une arme secrète contre la domination de l’IA de NVIDIA ?

Les allégations concernant la nouvelle boîte à outils proviennent d’une transcription circulant en ligne qui, bien que non confirmée par Microsoft, semble provenir du Third Bridge Forum, un réseau d’experts réputé qui propose des entretiens payants aux institutionnels. clients.

Dans ce document, un individu anonyme considéré comme un expert Microsoft affirme que l’entreprise travaille activement à combler le fossé entre les logiciels propriétaires de NVIDIA et le matériel de ses concurrents.

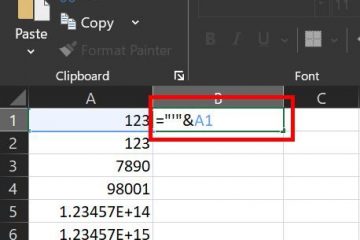

Dans la transcription partagée via une capture d’écran sur X, l’orateur a affirmé l’existence de projets conçus pour relever ce défi de front.

“Au cours des trois ou quatre derniers mois, il y a eu beaucoup plus d’intérêt pour les économies de coûts grâce à l’inférence. Nous avons créé des boîtes à outils pour vous aider à convertir des modèles CUDA en ROCm afin que vous puissiez les utiliser sur un AMD, comme un 300X.

Nous avons eu de nombreuses demandes sur notre chemin avec AMD, le 400X et le 450X. Nous travaillons activement avec AMD pour voir comment maximiser cela. Le plus grand défi que nous rencontrons actuellement, en particulier avec les serveurs les plus récents, est simplement de déterminer la densité au niveau du rack et d’obtenir un refroidissement liquide au niveau du rack.

Depuis des années, la plate-forme CUDA de NVIDIA est à la fois un outil puissant et une cage dorée pour les développeurs d’IA. En tant que plate-forme informatique parallèle dont les bibliothèques robustes en ont fait la norme de l’industrie, CUDA a créé un puissant « fossé » qui rend difficile aux concurrents de gagner des parts de marché.

S’il était confirmé, l’effort de Microsoft constituerait une attaque directe contre ce fossé. Bien que le ROCm d’AMD soit une alternative open source performante, un chemin de conversion fiable permettrait aux clients Azure de Microsoft de bénéficier des avantages financiers du matériel AMD sans abandonner l’environnement CUDA familier.

Des options permettant d’exécuter CUDA avec des puces AMD sont déjà disponibles, telles que la la chaîne d’outils GPGPU de SCALE. Cependant, la perte d’efficacité due à la conversion continue d’être un obstacle permanent que Microsoft veut apparemment s’attaquer.

Un jeu de réduction des coûts pour le boom de l’inférence de l’IA

Encouragés par l’explosion des dépenses liées aux opérations d’IA, les géants de la technologie recherchent désormais de manière agressive des mesures de réduction des coûts. L’intervenant dans la transcription a souligné que la principale motivation derrière la prétendue boîte à outils est financière, en particulier pour la phase d’inférence de l’IA, où des modèles formés sont utilisés.

À mesure que les services d’IA s’étendent à des millions d’utilisateurs, l’inférence représente une part massive des coûts opérationnels.

L’intérêt croissant pour la rentabilité fait des GPU d’AMD, à des prix plus compétitifs, une alternative attrayante au matériel haut de gamme de NVIDIA, à condition que la barrière logicielle puisse être surmontée.

Au-delà En raison du coût des logiciels et des puces, les contraintes physiques du centre de données deviennent un goulot d’étranglement critique. La source dans la transcription a noté que le défi fondamental n’est plus seulement d’obtenir suffisamment d’électricité, mais de la gérer efficacement.

L’accent mis sur la densité de puissance et le refroidissement liquide met en évidence les immenses exigences liées au logement des accélérateurs d’IA de nouvelle génération.

Les efforts déployés à l’échelle de l’industrie pour briser l’emprise de CUDA

La stratégie présumée de Microsoft s’alignerait sur une initiative significative à l’échelle de l’industrie pour cultiver une offre de matériel d’IA plus compétitive. chaîne. Pour NVIDIA, dont le leadership sur le marché repose autant sur ses logiciels que sur son silicium, cette tendance représente une menace à long terme.

Oracle, acteur clé de l’infrastructure cloud, a récemment annoncé un partenariat majeur pour déployer 50 000 puces AMD AI. Karan Batta, vice-président senior d’Oracle Cloud, a explicitement souligné la valeur de cette alternative pour les charges de travail sensibles aux coûts.

Le laboratoire de recherche en IA de premier plan, OpenAI, prend également des mesures décisives pour diversifier sa base de calcul. Il a conclu un accord définitif de plusieurs milliards de dollars avec AMD pour déployer 6 gigawatts de ses GPU.

Son partenariat comprend un warrant unique pouvant aller jusqu’à 160 millions d’actions, ce qui pourrait donner à OpenAI une participation d’environ 10 % dans le fabricant de puces, alignant ainsi profondément leurs objectifs.

Cette tendance de « coopétition » s’étend même aux rivaux historiques. Intel est en pourparlers pour fabriquer des puces pour AMD, soulignant l’importance stratégique d’une chaîne d’approvisionnement diversifiée en semi-conducteurs.

Si les affirmations concernant la boîte à outils de Microsoft sont exactes, l’entreprise ne s’efforce pas seulement de résoudre un problème de coûts internes, mais contribue également à une évolution plus large du marché. Un outil de conversion réussi pourrait signaler un avenir de développement d’IA indépendant du matériel, libérant les développeurs de la dépendance vis-à-vis d’un fournisseur.

Un tel changement potentiel marquerait une nouvelle phase de maturation pour l’ensemble du secteur de l’IA, passant d’un accaparement frénétique des terres informatiques à un écosystème plus stratégique et multipolaire.