Des chercheurs de Microsoft ont détaillé une nouvelle attaque par canal secondaire appelée « Whisper Leak » qui peut deviner le sujet des discussions cryptées par l’IA, exposant ainsi un risque fondamental pour la vie privée dans l’industrie de l’IA.

Dans un rapport, l’équipe a montré comment les modèles de taille et de synchronisation du trafic réseau peuvent révéler ce dont les utilisateurs discutent, même avec le cryptage TLS. La faille affecte 28 modèles d’IA majeurs, créant un risque sérieux pour la vie privée des utilisateurs du monde entier. Un observateur sur un réseau pourrait repérer des discussions sensibles sur des sujets juridiques ou sanitaires.

Après un processus de divulgation qui a débuté en juin, des fournisseurs majeurs comme OpenAI et Microsoft ont commencé à déployer des correctifs, mais le problème met en évidence un risque majeur dans le streaming de l’IA.

Comment Whisper Leak Écoutes clandestines des discussions cryptées avec l’IA

L’ingéniosité de l’attaque réside dans sa capacité à fonctionner sans briser le cryptage TLS sous-jacent qui protège les communications en ligne. Au lieu de cela, il exploite les métadonnées que le cryptage laisse intrinsèquement exposées.

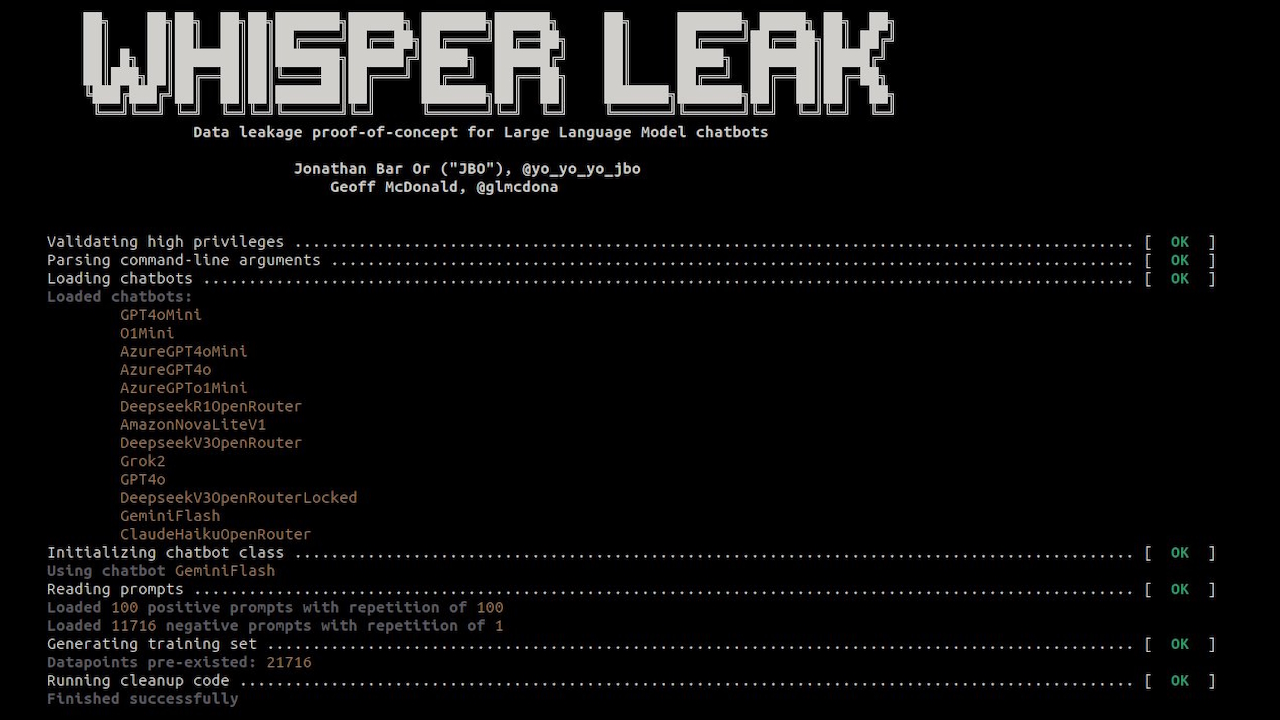

Selon la documentation du projet, « Whisper Leak est une boîte à outils de recherche qui démontre comment les conversations chiffrées en continu avec de grands modèles linguistiques divulguent des informations d’invite en fonction de la taille et du timing des paquets. »

La méthode contourne la sécurité du contenu en se concentrant sur la forme et le rythme du flux de données.

Les réponses LLM, générées jeton par jeton, créent des séquences uniques de paquets de données lorsque diffusé à un utilisateur. Chaque sujet, de l’analyse juridique à la conversation informelle, génère un texte avec un vocabulaire et des structures de phrases distincts. Ces modèles linguistiques produisent une « empreinte numérique » caractéristique dans le trafic réseau.

En analysant les séquences de tailles de paquets et les temps entre les arrivées, les chercheurs ont construit des classificateurs pour reconnaître ces empreintes digitales avec une grande précision.

La boîte à outils publique du projet le confirme. méthode, qui utilise des modèles d’apprentissage automatique pour apprendre les signatures subtiles de différents types de conversations. Même avec du contenu crypté, les modèles de trafic trahissent le sujet de la conversation.

Une faille à l’échelle de l’industrie affectant 28 modèles majeurs d’IA

Whisper Leak n’est pas un bug isolé mais une vulnérabilité systémique affectant une large partie de l’industrie de l’IA. L’équipe Microsoft a testé 28 LLM disponibles dans le commerce et a constaté que la majorité d’entre eux étaient très sensibles.

Pour de nombreux modèles, l’attaque a atteint une classification presque parfaite. Les chercheurs ont noté dans un article de blog :”Cela nous indique que les”empreintes digitales”numériques uniques laissées par les conversations sur un sujet spécifique sont suffisamment distinctes pour que notre système d’écoute basé sur l’IA puisse les détecter de manière fiable lors d’un test contrôlé.”

Pour les entreprises qui s’appuient sur l’IA pour leurs communications sensibles, les résultats représentent un nouveau vecteur de menace difficile. La recherche a démontré une précision alarmante dans des conditions réalistes.

Dans une simulation avec un rapport bruit de fond/conversations cibles de 10 000 : 1, l’attaque a identifié des sujets sensibles avec une précision de 100 % pour 17 des 28 modèles, tout en détectant 5 à 20 % de toutes les conversations cibles.

Un adversaire de réseau passif, tel qu’un FAI, une agence gouvernementale ou un attaquant sur un réseau Wi-Fi public, pourrait identifier de manière fiable. les utilisateurs discutent de questions juridiques, financières ou de santé confidentielles.

Cette fonctionnalité transforme les discussions cryptées par l’IA en une source potentielle de surveillance ciblée. Comme l’indiquent les chercheurs : « Cette vulnérabilité à l’échelle de l’industrie présente des risques importants pour les utilisateurs sous surveillance réseau par les FAI, les gouvernements ou les adversaires locaux. 96,0 % 59,5 % 100,0 % microsoft-deepseek-r1 98,6 % 98,9 % 46,3 % 99,9 % 99,9 % 61,0 % 94,8 % 95,5 % 56,8 % 99,9 % xai-grok-3-mini-bêta 99,1 % 98,8 % 73,0% 99,9% 99,9% 73,2% 97,2% 97,5% 74,9% 99,9% mistral-petit 98,3% 97,6% 60,7% 99,9% 99,8% 65,1% 94,1% 94,3% 61,3% 99,9% groq-llama-4-maverick 99,3 % 99,2 % 52,9 % 99,6 % 99,7 % 56,4 % 93,6 % 94,2 % 60,4 % 99,7 % deepseek-deepseek-r1 98,8 % 98,6 % 46,5 % 99,3 % 99,4 % 62,5% 96,7% 96,9% 65,4% 99,4% alibaba-qwen2.5-plus 98,0% 97,7% 66,3% 99,1% 99,0% 63,5% 97,1% 97,3% 67,4% 99,1% xai-grok-2 99,0% 98,8% 66,9% 98,5% 98,7% 70,1% 93,2% 94,9% 72,9% 99,0% alibaba-qwen2.5-turbo 97,2% 96,8% 71,9% 97,5% 97,6% 71,8% 99,0% 98,9% 71,2% 99,0% openai-o1-mini 97,8% 98,0% 58,7% 98,9% 98,9% 62,1% 97,0% 96,9% 64,6% 98,9% openai-gpt-4o-mini 97,5% 97,8% 76,7% 98,2% 98,3% 75,4% 98,6% 98,6% 72,6% 98,6% deepseek-deepseek-v3-chat 98,3% 98,0% 58,6% 98,1% 98,1% 59,7% 97,6% 97,6% 60,6% 98,3% openai-gpt-4.1-mini 96,8 % 96,6 % 78,5 % 97,3 % 98,0 % 77,6 % 97,4 % 97,3 % 76,3 % 98,0 % lambda-llama-3.1-8b-instruct 96,8 % 97,5 % 59,9 % 76,3 % 97,8 % 68,3% 91,9% 92,5% 59,6% 97,8% lambda-llama-3.1-405b 97,7% 97,5% 62,6% 93,2% 96,6% 66,8% 95,5% 95,6% 62,0% 97,7% groq-llama-4-scout 97,6% 97,3% 60,3% 68,5% 70,0% 64,8% 89,0% 89,6% 57,4% 97,6% openai-gpt-4.1-nano 96,1% 96,8% 77,8% 97,1% 97,1% 75,5% 96,2% 96,4% 77,1% 97,1% microsoft-gpt-4o-mini 93,4% 93,2% 77,8% 88,5% 81,3% 81,8% 91,3% 91,5% 77,2% 93,4% anthropique-claude-3-haiku 90,2% 76,8% 78,7% 91,2% 80,1% 80,0% 87,9% 74,5% 77,9% 91,2% microsoft-gpt-4.1-nano 89,5% 91,0% 84,0% 88,1% 82,4% 85,4% 86,6% 86,9% 80,5% 91,0% microsoft-gpt-4o 89,9 % 90,1 % 78,0 % 87,2 % 81,4 % 83,0 % 87,3 % 87,9 % 77,7 % 90,1 % microsoft-gpt-4.1-mini 89,7 % 89,4 % 75,4 % 86,7 % 80,4 % 78,9 % 86,6 % 87,3 % 76,0 % 89,7 % google-gemini-2.5-pro 77,1 % 74,3 % 78,1 % 83,1 % 76,3 % 82,4 % 84,0 % 78,5 % 83,4 % 84,0 % google-gemini-1.5-flash 81,0 % 76,2% 80,2% 82,4% 78,3% 81,6% 83,5% 81,6% 82,8% 83,5% google-gemini-1.5-flash-light 79,9% 74,6% 79,4% 79,7% 75,5% 79,0% 81,9% 77,8% 81,4 % 81,9 % amazon-nova-pro-v1 46,2 % 57,9 % 46,6 % 77,5 % 74,9 % 57,3 % 60,9 % 60,6 % 57,6 % 77,5 % microsoft-phi-3.5-mini-moe-instruct 70,0 % 70,0 % 75,3 % 75,3% 72,1% 76,9% 75,9% 72,5% 74,4% 76,9% amazon-nova-lite-v1 67,6% 68,3% 63,2% 71,2% 70,5% 67,7% 65,8% 65,5% 65,1% 71,2% Moyenne 96,8 % 96,8 % 70,9 % 93,2 % 97,1 % 71,8 % 92,5 % 93,3 % 69,7 % nan%

Performances d’attaque (AUPRC) sur les LLM cibles hébergés par les fournisseurs et ensembles de fonctionnalités spécifiés et l’architecture du modèle d’attaque. Des nombres plus élevés correspondent à une plus grande efficacité de l’attaque par canal secondaire. Les métriques sont calculées sous la forme d’une médiane sur 5 essais, où une répartition aléatoire est effectuée par essai. La colonne « Meilleur » correspond également à la médiane des 5 meilleurs essais parmi les modèles et les ensembles de fonctionnalités utilisés. (Source : Microsoft)

Une solution difficile : atténuation et réponses incohérentes des fournisseurs

Microsoft a lancé un processus de divulgation responsable en juin 2025, en informant les 28 fournisseurs concernés. En novembre, les réponses étaient mitigées.

Alors que des fournisseurs comme OpenAI, Microsoft, Mistral et xAI ont décidé de corriger la faille, le rapport note que d’autres fournisseurs ont refusé de mettre en œuvre des correctifs ou sont restés insensibles.

Cet incident met en évidence une incohérence troublante dans la façon dont le secteur gère les nouvelles menaces natives de l’IA. Cela fait suite au refus de Google en octobre de corriger une faille critique de « contrebande ASCII » dans ses modèles Gemini, qu’il a classée comme un problème d’ingénierie sociale plutôt que comme un bug de sécurité.

Cela fait également écho à une récente vulnérabilité d’exfiltration de données dans Claude d’Anthropic, où la société a initialement rejeté le rapport avant de reconnaître un « problème de processus ».

Comme l’a noté le chercheur en sécurité Johann Rehberger dans ce cas, « la sécurité vous protège des accidents. vous protège des adversaires. La distinction est essentielle à mesure que les agents d’IA deviennent plus autonomes et intégrés aux données sensibles.

Réparer les fuites de métadonnées n’est pas simple. Les chercheurs ont évalué plusieurs mesures d’atténuation, chacune comportant des compromis importants. Le remplissage aléatoire des données, désormais mis en œuvre par certains fournisseurs, ajoute du bruit à la taille des paquets mais ne réduit que partiellement le succès des attaques.

Une autre stratégie, le regroupement par lots de jetons, regroupe plusieurs jetons avant de les envoyer, masquant ainsi les modèles individuels. Bien qu’efficace pour des lots de plus grande taille, cela peut dégrader la sensation de réactivité en temps réel d’un chatbot, ce qui a un impact sur l’expérience utilisateur.

Une troisième option, l’injection de paquets de « bruit » synthétiques, peut également obscurcir les modèles de trafic. Cette approche augmente cependant la surcharge de bande passante, un facteur de coût important pour les fournisseurs.

L’épisode montre qu’à mesure que l’IA s’intègre de plus en plus dans les flux de travail sensibles, la protection de la confidentialité des utilisateurs nécessite de regarder au-delà du cryptage du contenu pour sécuriser les modèles mêmes de communication numérique.